Professional Documents

Culture Documents

Teoria Sobre El Proyecto de Cadenas de Markov

Uploaded by

Wilmar RØdriguezCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Teoria Sobre El Proyecto de Cadenas de Markov

Uploaded by

Wilmar RØdriguezCopyright:

Available Formats

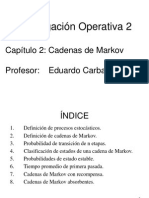

CADENAS DE MARKOV

Una cadena de Markov es una serie de eventos, en la cual la probabilidad de que ocurra un

evento depende del evento inmediato anterior. En efecto, las cadenas de este tipo tienen

memoria, "Recuerdan" el ltimo evento y esto condiciona las posibilidades de los eventos

futuros. Esta dependencia del evento anterior distingue a las cadenas de Markov de las

series de eventos independientes, como tirar una moneda al aire o un dado. En los

negocios, las cadenas de Markov se han utilizado para analizar los patrones de compra,los

deudores morosos, para planear las necesidades de personal y para analizar el reemplazo

de equipo. El anlisis de Markov, llamado as en honor de un matemtico ruso que

desarrollo el mtodo en 1907, permite encontrar la probabilidad de que un sistema se

encuentre en un estado en particular en un momento dado. Algo ms importante an, es

que permite encontrar el promedio a la larga o las probabilidades de estado estable para

cada estado. Con esta informacin se puede predecir el comportamiento del sistema a

travs del tiempo. La tarea ms difcil es reconocer cundo puede aplicarse. La

caracteristica ms importante que hay que buscar en la memoria de un evento a otro.

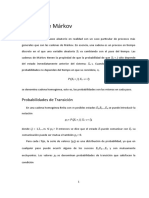

Una cadena de markov consta de unos estados E1 E2 E3 E4..E

n

. que inicialmente en un

tiempo 0 o paso 0 se le llama estado inicial, adems de esto consta de una matriz de

transicin que significa la posibilidad de que se cambie de estado en un prximo tiempo o

paso.

MATRIZ DE TRANSICIN:

Una matriz de transicin para una cadena de Markov de n estado es una matriz de n X n

con todos los registros no negativos y con la propiedad adicional de que la suma de los

registros de cada columna (o fila) es 1. Por ejemplo: las siguientes son matrices de

transicin.

REPRESENTACIN GRAFICA DE UNA MATRIZ DE TRANSICIN:

Es el arreglo numrico donde se condensa las probabilidades de un estado a otro. A travs

de una grfica de matriz de transicin se puede observar el comportamiento estacionario

representado por una cadena de Markov tal que los estados representan la categora en

que se encuentre clasificado. Como se aprecia a continuacin:

p

(r

PROPIEDADES:

1- la suma de las probabilidades de los estados debe ser igual a 1.

2- la matriz de transicin debe ser cuadrada.

3- las probabilidades de transicin deben estar entre 0 y 1

7. Cadenas absorbentes: resultados tericos

Recordando que en una cadena hay slo dos tipos de estados (absorbentes y

transientes), nos resultar conveniente llamar al conjunto de estados absorbentes

A y al conjunto de estados transientes T .

En una cadena absorbente y empezando en cualquier estado, sea transiente o

absorbente, tenemos una probabilidad positiva de llegar en algn momento a un

estado absorbente, ya que en otro caso se formara un conjunto ergdico (que no

es el total) con ms de un punto porque hay un nmero finito de estados. Desde

el punto de vista del digrafo asociado, esto se refleja en que desde todo estado

transiente existe un camino (dirigido) hacia algn estado absorbente.

En otras palabras, para cada estado u existe un estado v A y un nmero de

pasos r tales que la probabilidad de ir desde u hasta v en r pasos es positiva, o sea,

uv

> 0.

Como una vez que llegamos a un estado absorbente nos tenemos que quedar

all, podemos tomar un mismo r (el mximo de los anteriores) que sirva para todos

los estados. Del mismo modo, tomando ahora el mnimo de las probabilidades,

vemos que podemos encontrar > 0 tal que para todo estado u existe un estado

absorbente v T tal que p

(r )

.

Como estamos en un proceso de Markov, la probabilidad de que empezando

desde cualquier estado no lleguemos a un estado absorbente en a lo ms r pasos es

menor o igual que 1 . Repitiendo el razonamiento, vemos que la probabilidad de

no llegar en k r pasos (k N) a un estado absorbente es menor o igual que (1 )

k

,

pero como 1 < 1, esta probabilidad tiende a 0.

Podemos resumir este argumento en el siguiente:

7.1. Teorema. En toda cadena de Markov absorbente, la probabilidad de absorcin

(que empezando en cualquier lugar se llegue a un estado absorbente) e

Eventualmente renumerando los estados, podemos escribir la matriz de transi- cin asociada en

forma cannica:

absorbentes

z }| {

transientes

z }| {

absorbentes {

I 0

(7.2)

transientes { R Q

En este caso, si hay n estados, de los cuales m son absorbentes y n m transientes,

la submatriz I es la matriz identidad en R

mm

, la submatriz 0 R

m(nm)

tiene

todos los coeficientes 0, y las submatrices R y Q estn en R

(nm)m

y R

(nm)(nm)

respectivamente.

Puesto que comenzando desde un estado absorbente, la probabilidad de no

llegar a un estado absorbente se acerca a 0 a medida que aumenta el nmero de

pasos (por el teorema 7.1), y como las entradas de Q

k

son las probabilidades de

que empezando en un estado transiente despus de k pasos lleguemos a otro estado

transiente, tenemos:

7.3. Teorema. En una cadena de Markov absorbente cuya matriz cannica tiene la

forma de la ecuacin (7.2),

a) Q

r

0 (la matriz con todos 0s) cuando r ,

b) si I es la matriz identidad en R

(nm)(nm)

, entonces I Q es inversible y

X

(I Q)

1

=

r =0

Q

r

.

La ltima parte del teorema anterior sigue las ideas de la demostracin de que

1

1 x

X

=

k=0

x

k

,

cuando x es un nmero real con |x | < 1, y no la hacemos, pero observamos desde

ya la relacin con la variante I de la pg. 9.

Claro que si tenemos un estado transiente u T , en la forma cannica de la

matriz P tiene asociado un ndice (digamos i), pero en la matriz Q tiene asociado

otro ndice (i m). En lo que sigue, para no complicar las notaciones supondremos

implcitamente que no tenemos esta ambigedad y hacemos un corrimiento de

ndices cuando apropiado.

Poniendo

N = (I Q)

1

, (7.4)

a veces llamada matriz fundamental de la cadena absorbente, tenemos el siguiente:

7.5. Teorema. En una cadena absorbente, si se empieza en el estado transiente u

i

T ,

el nmero esperado de veces en que la cadena est en el estado transiente u

j

T es la

entrada i j de la matriz fundamental N .

Demostracin: Pongamos

1 si la cadena est en el estado u

j

en el paso s,

( j, s) =

0 en otro caso,

i j

1 1

1

2

Figura 7.1: Una cadena absorbente simple.

y para cualquier x sea E

i

( x ) el valor esperado de x si el proceso empieza en el

estado u

i

. Entonces si e

i j

es la esperanza buscada,

e

i j

= E

i

X

( j, s)

=

X

E

i

(( j, s)) =

X

(1 p

(s)

) 0 + p

(s)

1

=

X

p

(s)

,

s=0

s=0

s=0

i j i j i j

s=0

donde la suma empieza desde s = 0 pues no eliminamos la posibilidad i = j.

Recordando que p

(s)

es la entrada i j-sima de Q

s

(despus de un corrimiento

de ndices), vemos que e

i j

es la entrada i j-sima de

P

Q

s

, que es N por el

teorema 7.3.

En el teorema no excluimos la condicin i = j, lo cual trae algunos problemas de

interpretacin. Tomemos por ejemplo la cadena absorbente de la figura 7.1 donde

hay dos estados. El estado 1 es absorbente, mientras que el estado 2 es transiente

pero la probabilidad de pasar al estado 1 en un paso es 1. La matriz Q en este

caso se reduce a Q = [0], de modo que N = (I Q)

1

= [1]. Es decir, seguro que

empezando desde 2 en un paso llegamos al estado 1, as que esperamos llegar a 1

en un paso y permanecer 0 pasos en el estado 2. Esta aparente contradiccin resulta

de haber considerado el trmino s = 0 en la demostracin del teorema, y como

i i

= 1, el paso 0 siempre se cuenta en el teorema.

Tomando las precauciones debidas, tenemos entonces el siguiente corolario que

usaremos con frecuencia en las aplicaciones:

7.6. Corolario. El nmero esperado de pasos hasta la absorcin (sin contar el paso 0),

dado que el proceso comienza en el estado no-absorbente u

i

es la suma de las entradas

de la fila i-sima de N .

Veamos un ltimo resultado antes de pasar a las aplicaciones.

7.7. Teorema. Consideremos una cadena absorbente, con matriz cannica en la forma

de la ecuacin (7.2). Sea b

i j

la probabilidad de que empezando en el estado transiente

u

i

se termine en el estado absorbente u

j

, y formemos la matriz B R

(nm)m

con estos

coeficientes.

Entonces

B = N R,

donde R es como en la ecuacin (7.2) y N es la matriz fundamental de la ecuacin (7.4).

Demostracin: Buscamos una relacin de recurrencia para los coeficientes b

i j

. Si

empezamos en el estado u

i

, en el prximo paso podemos ir al estado absorbente

u

j

con probabilidad p

i j

, o a otro estado absorbente u

k

, k = j, con probabilidad

p

i k

, o ir a otro estado transiente u

`

con probabilidad p

i`

. La probabilidad de que

estando en estos estados, u

j

, u

k

o u

`

, terminemos en el estado absorbente u

j

es,

respectivamente, 1, 0 y b

` j

, de modo que

b

i j

= p

i j

+

X

` : u

`

T

p

i`

b

` j

.

Como u

i

es transiente y u

j

absorbente, p

i j

es la entrada correspondiente de

la matriz R (con algn eventual desplazamiento de ndices). De modo similar, p

i`

es la entrada i` de la matriz Q, y b

` j

es la entrada de la matriz B. Podemos

escribir entonces la ecuacin anterior en forma matricial como

B = R + QB o (I Q) B = R,

de donde sigue el resultado pues I Q es inversible con inversa N .

Vale la pena observar que la tcnica usada en la demostracin es

esencialmente la usada en la variante II de la pg. 10.

7.8. Problema. Juntando los teoremas 7.1 y 7.7, para todo estado transiente u

i

debe ser

X

b

i j

= 1.

j

A

Sin usar estos resultados, verificar directamente a partir de las definiciones que las

sumas de las filas de N R es siempre 1.

(7)

Cadenas regulares

Una cadena de Markov se dice regular (tambin primitiva o ergdica) si existe alguna potencia

positiva de la matriz de transicin cuyas entradas sean todas estrictamente mayores que cero.

Cuando el espacio de estados E es finito, si P denota la matriz de transicin de la cadena se tiene

que:

donde W es una matriz con todos sus renglones iguales a un mismo vector de probabilidad w,

que resulta ser el vector de probabilidad invariante de la cadena. En el caso de cadenas

regulares, ste vector invariante es nico.

You might also like

- Cadenas de Marko-ResumenDocument16 pagesCadenas de Marko-ResumenArturo CLorcaNo ratings yet

- Cadenas de MarkovDocument18 pagesCadenas de MarkovCIELOCINo ratings yet

- SEMANA 14 (15 Al 19 Agosto 2022-1)Document81 pagesSEMANA 14 (15 Al 19 Agosto 2022-1)Nik Antoni Aguilar SanchezNo ratings yet

- Aplicaciones y Técnicas en El Uso de MarkovDocument10 pagesAplicaciones y Técnicas en El Uso de MarkovReyna Cristina Chucuya ApazaNo ratings yet

- Cadenas de MarkovDocument21 pagesCadenas de MarkovangieebiirofbNo ratings yet

- 4.4. - Estados AbsorbentesDocument7 pages4.4. - Estados AbsorbentesJuan Sanchez EspinosaNo ratings yet

- Cadenas de MarkovDocument5 pagesCadenas de MarkovAlx GarciaNo ratings yet

- Probabilidad de Transicion Estacionaria de Estados Estables EsthelaDocument6 pagesProbabilidad de Transicion Estacionaria de Estados Estables EsthelaJefr FloresNo ratings yet

- Cadenas de Markov 2010 IIDocument129 pagesCadenas de Markov 2010 IIroberto1809100% (3)

- Cadena de Markov Ejerciciodocx PDFDocument26 pagesCadena de Markov Ejerciciodocx PDFPaolaNo ratings yet

- Análisis de MarcovDocument18 pagesAnálisis de MarcovKELLY KIARA VELEZ AGUILARNo ratings yet

- Cadenas de MarkovDocument15 pagesCadenas de MarkovMagbep100% (1)

- Cadenas de MarkovDocument14 pagesCadenas de MarkovMercado IMCNo ratings yet

- MarkovDocument42 pagesMarkovsergio200800No ratings yet

- Tarea 1 Inv Operaciones 2Document8 pagesTarea 1 Inv Operaciones 2Joshua LeonNo ratings yet

- Cadenas de Markov 12Document40 pagesCadenas de Markov 12Astrid SandovalNo ratings yet

- Herramientas para La Toma de Decisiones Ucv Clase 9 Cadena de Markov 2015 IIDocument80 pagesHerramientas para La Toma de Decisiones Ucv Clase 9 Cadena de Markov 2015 IIjosselyn rodriguezNo ratings yet

- Cadenas de Markov Act1 Tema 4Document8 pagesCadenas de Markov Act1 Tema 4Papeleria vatisNo ratings yet

- Modelos de Markov para La Trayectoria AcadémicaDocument15 pagesModelos de Markov para La Trayectoria AcadémicaMarcelo GutierrezNo ratings yet

- FM03 Tema 2Document23 pagesFM03 Tema 2Mauricio TorresNo ratings yet

- Actividad 9 - Cadenas de Markov - Carlos Agustin Hernandez HernandezDocument5 pagesActividad 9 - Cadenas de Markov - Carlos Agustin Hernandez HernandezCarlos HernandezNo ratings yet

- Procesos Estocásticos 2019 PDFDocument56 pagesProcesos Estocásticos 2019 PDFstephanie leivaNo ratings yet

- Inves RochaDocument12 pagesInves RochaJesus PerezNo ratings yet

- E3T1 Coronado López Alejandra MarcelaDocument8 pagesE3T1 Coronado López Alejandra MarcelaALEJANDRA MARCELA CORONADO LOPEZNo ratings yet

- Cadena de Markov. EjerciciodocxDocument26 pagesCadena de Markov. EjerciciodocxNany Pacman0% (1)

- Cadenas MarkovDocument51 pagesCadenas MarkovYsmar Laisney Lucena Perdomo0% (2)

- Resumenes Cadenas de MarkovDocument5 pagesResumenes Cadenas de MarkovAngela NuñezNo ratings yet

- 2 Cadenas de MarkovDocument43 pages2 Cadenas de MarkovgustavobenitesNo ratings yet

- Unidad 4 y 5Document43 pagesUnidad 4 y 5Karla LiceaNo ratings yet

- Procesos EstocasticosDocument73 pagesProcesos EstocasticosYoleidy Huerfano100% (1)

- Cadena de Markov en Tiempo DiscretoDocument5 pagesCadena de Markov en Tiempo DiscretoGricelda Prado OrdonezNo ratings yet

- CADENAS DE MARKOV y Sus PropiedadesDocument39 pagesCADENAS DE MARKOV y Sus PropiedadesCarlittos CalderoneNo ratings yet

- Cadenas de MarkovDocument10 pagesCadenas de MarkovLUIS EMANUEL RAMOS ARZATENo ratings yet

- La Cadena de MarkovDocument13 pagesLa Cadena de MarkovMarlonmitchel Guevara CarrascoNo ratings yet

- CADENAS DE MARKOV (1) .En - EsDocument14 pagesCADENAS DE MARKOV (1) .En - EsKevin FloresNo ratings yet

- Clasificación de Estados de Una Cadena de Markov en Tiempo DiscretoDocument5 pagesClasificación de Estados de Una Cadena de Markov en Tiempo DiscretoGricelda Prado OrdonezNo ratings yet

- Cadena de MarkovDocument27 pagesCadena de MarkovLeo MessiNo ratings yet

- Ta - Inv - Oper.-6-5-Zurita-Avalos-JesusDocument19 pagesTa - Inv - Oper.-6-5-Zurita-Avalos-JesusJesus ZuritaNo ratings yet

- Cadena de Markov1Document7 pagesCadena de Markov1anon_615179342No ratings yet

- Cadenas de MarkovDocument18 pagesCadenas de MarkovEl BoxeadorNo ratings yet

- Trabajo Final de Cadenas de MarkovDocument20 pagesTrabajo Final de Cadenas de MarkovluisNo ratings yet

- Cadenasde MarkovDocument40 pagesCadenasde MarkovPatricia Bustos CaballeroNo ratings yet

- Cadenas de Márkov IO2 201403563 RetrasadaDocument22 pagesCadenas de Márkov IO2 201403563 RetrasadaJhony Castañeda100% (1)

- Meio 2Document42 pagesMeio 2Cèsar Enrique Racer FestNo ratings yet

- Cadena de MarkovDocument21 pagesCadena de MarkovEdzon Alberto Cervantes ZetinaNo ratings yet

- Tipos de Cadenas de MarkovDocument5 pagesTipos de Cadenas de MarkovLiiss Carranza100% (1)

- Cadema MarkovDocument54 pagesCadema MarkovVanesa RojasNo ratings yet

- Trabajo Investigación Investigación de Operaciones 2Document14 pagesTrabajo Investigación Investigación de Operaciones 2Marco CastañazaNo ratings yet

- Cadenas de MarkovDocument2 pagesCadenas de Markovgeo2805No ratings yet

- 7 - Cadenas de Markov Largo PlazoDocument25 pages7 - Cadenas de Markov Largo PlazoNacho HualaNo ratings yet

- Introducción A Las Cadenas o Procesos de MarkovDocument3 pagesIntroducción A Las Cadenas o Procesos de MarkovAztroResendizNo ratings yet

- Cadena Markov PDFDocument10 pagesCadena Markov PDFManuel VásquezNo ratings yet

- Jeancarlos Marizan 17-7883 Tarea 2Document9 pagesJeancarlos Marizan 17-7883 Tarea 2Armando LucianoNo ratings yet

- Eduardo - Cristian U3 Parte 1 - Cadenas MarkovDocument14 pagesEduardo - Cristian U3 Parte 1 - Cadenas MarkovEduardo LesseyNo ratings yet

- Tema 6Document13 pagesTema 6Oliver CastilloNo ratings yet

- Cadenas de MarkovDocument6 pagesCadenas de MarkovCindy J Lauper100% (1)

- Tema5pe PROCESOS MARTINGALADocument22 pagesTema5pe PROCESOS MARTINGALAmarinaderompidoNo ratings yet

- CADENAS DE MARKOV Cadenas Ergodica y AbsorbentesDocument7 pagesCADENAS DE MARKOV Cadenas Ergodica y AbsorbentesIngrid Janeth Rojas LizardoNo ratings yet

- Cad MarkDocument14 pagesCad MarkRoguiciiNo ratings yet

- Critica de Fondo Construccion de Caminos en La SelvaDocument5 pagesCritica de Fondo Construccion de Caminos en La SelvaWilmar RØdriguezNo ratings yet

- CRITICA DE FONDO Enseñanza en La GeotecniaDocument2 pagesCRITICA DE FONDO Enseñanza en La GeotecniaWilmar RØdriguezNo ratings yet

- Temario A Estudiar de Examen IndaabinDocument67 pagesTemario A Estudiar de Examen IndaabinWilmar RØdriguezNo ratings yet

- Confiabilidad en Geotecnia CriticaDocument2 pagesConfiabilidad en Geotecnia CriticaWilmar RØdriguez100% (1)

- Criterios Normativos, y No Vinculativos Del SAT de (IVA-IEPS)Document4 pagesCriterios Normativos, y No Vinculativos Del SAT de (IVA-IEPS)Wilmar RØdriguezNo ratings yet

- Metodologia de La Auditoría AdministrativaDocument8 pagesMetodologia de La Auditoría AdministrativaWilmar RØdriguezNo ratings yet

- El Liderazgo en La Ingenieria CivilDocument3 pagesEl Liderazgo en La Ingenieria CivilWilmar RØdriguezNo ratings yet

- Estudio de Mercado de Un Despacho ContableDocument3 pagesEstudio de Mercado de Un Despacho ContableWilmar RØdriguez83% (6)

- Cuentas Cargo y AbonoDocument4 pagesCuentas Cargo y AbonoWilmar RØdriguezNo ratings yet

- Proceso Constructivo de CarreterasDocument9 pagesProceso Constructivo de CarreterasWilmar RØdriguezNo ratings yet

- Aceites Lubricantes Contaminacion Del SueloDocument2 pagesAceites Lubricantes Contaminacion Del SueloWilmar RØdriguez100% (1)

- Estructuras de Acero (HUESO de PERRO)Document14 pagesEstructuras de Acero (HUESO de PERRO)Wilmar RØdriguezNo ratings yet

- Pesos y Dimenciones de VehiculosDocument10 pagesPesos y Dimenciones de VehiculosWilmar RØdriguezNo ratings yet

- Aspectos Relativos de Refuerzos Metalicos, Desencofrado y ResanadoDocument20 pagesAspectos Relativos de Refuerzos Metalicos, Desencofrado y ResanadoJesus Andres Diaz Velasquez0% (1)

- Fundacion El Amanecer Del Alma Retiro de Yoga y MeditacionDocument4 pagesFundacion El Amanecer Del Alma Retiro de Yoga y MeditacionParameshwar Aum AnandajiNo ratings yet

- CotizacionDocument2 pagesCotizacionAngel JMNo ratings yet

- Fuente Dc. Laboratorio CircuitosDocument4 pagesFuente Dc. Laboratorio CircuitosJunior ALdair Andrade SiancasNo ratings yet

- Capítulo 1 MerchandisingDocument8 pagesCapítulo 1 MerchandisingGina SolarteNo ratings yet

- Herramientas de Power PointDocument67 pagesHerramientas de Power PointGermanNo ratings yet

- Tema 7.2. Artes y CienciasDocument51 pagesTema 7.2. Artes y CienciasBeatriz Pañeda MurciaNo ratings yet

- Fisicoquímica Farmacéutica Clase 6. Calor, Trabajo Y EnergíaDocument22 pagesFisicoquímica Farmacéutica Clase 6. Calor, Trabajo Y EnergíaJoansalome CampañaNo ratings yet

- 6.4 Estructura Del Programa de Proteccion CivilDocument16 pages6.4 Estructura Del Programa de Proteccion CivilMarco Gómez SernaNo ratings yet

- Orden de Matricula Nit: 860401734-9 PBX: 3813222 Fax: 3347101Document1 pageOrden de Matricula Nit: 860401734-9 PBX: 3813222 Fax: 3347101Diana Elizabeth Proano FragaNo ratings yet

- Planificación de La Conversación 2021 - 2022Document7 pagesPlanificación de La Conversación 2021 - 2022yeison tupuro100% (2)

- Historia Evaluacionformativa3 Cuartosab Oa3 Semana17Document13 pagesHistoria Evaluacionformativa3 Cuartosab Oa3 Semana17María José araya ibacacheNo ratings yet

- Ejercicios MatDocument8 pagesEjercicios Materikamireyda23No ratings yet

- Practica 4 Reconocimiento de Voz MatlabDocument5 pagesPractica 4 Reconocimiento de Voz MatlabMiguel Ángel López González100% (1)

- Consumo de Agua Al Interior de Una ViviendaDocument4 pagesConsumo de Agua Al Interior de Una ViviendaHernan Kcana ChuraNo ratings yet

- Activar La Licencia de ArcMapDocument2 pagesActivar La Licencia de ArcMapTJJeffersonNo ratings yet

- Acta de Inicio 1278Document18 pagesActa de Inicio 1278Mabel JojoaNo ratings yet

- 039 - Bases Psicológicas de La Conducta Humana - PpsDocument16 pages039 - Bases Psicológicas de La Conducta Humana - PpsNazareth Velasco LópezNo ratings yet

- Elec 167 2861 Elec M 20140515180536Document7 pagesElec 167 2861 Elec M 20140515180536LH Otoya MedinaNo ratings yet

- Mof AlmacenDocument21 pagesMof AlmacenRAUL ARRIVASPLATA GARCIANo ratings yet

- Proyecto Vinagre de Guineo-FundamentoDocument1 pageProyecto Vinagre de Guineo-FundamentoGiovanny Jimenez MezaNo ratings yet

- Inseguridad CorporalDocument4 pagesInseguridad CorporalSantiago Rivera LópezNo ratings yet

- Comentario de AristótelesDocument2 pagesComentario de AristótelesHeyy8No ratings yet

- Aplicaciones de Numeros ComplejosDocument9 pagesAplicaciones de Numeros ComplejosFreddy Alexys Durand QuispeNo ratings yet

- Infaimon PDFDocument30 pagesInfaimon PDFEva SuárezNo ratings yet

- 012 CM Granite P.J.L. 18.0 Allison E5 1Document2 pages012 CM Granite P.J.L. 18.0 Allison E5 1Nelson Andrade VelasquezNo ratings yet

- Diseño y Lanzamiento de Tijeras para Poda para El Consumidor. 1Document94 pagesDiseño y Lanzamiento de Tijeras para Poda para El Consumidor. 1Luis AvilaNo ratings yet

- UntitledDocument90 pagesUntitledjose jose prieto santanaNo ratings yet

- Formato de Entrevista General para Casos de Ninos en PsicologiaDocument16 pagesFormato de Entrevista General para Casos de Ninos en PsicologiaSaul Ortiz UlinNo ratings yet

- Guía 10. Porcentajes - PN PDFDocument3 pagesGuía 10. Porcentajes - PN PDFmichelledelvalleNo ratings yet

- El Tao de la física: Una exploración de los paralelismos entre la física moderna y el misticismo orientalFrom EverandEl Tao de la física: Una exploración de los paralelismos entre la física moderna y el misticismo orientalRating: 5 out of 5 stars5/5 (3)

- Armónicas en Sistemas Eléctricos IndustrialesFrom EverandArmónicas en Sistemas Eléctricos IndustrialesRating: 4.5 out of 5 stars4.5/5 (12)

- Guía práctica para la refracción ocularFrom EverandGuía práctica para la refracción ocularRating: 5 out of 5 stars5/5 (2)

- Había una vez el átomo: O cómo los científicos imaginan lo invisibleFrom EverandHabía una vez el átomo: O cómo los científicos imaginan lo invisibleRating: 5 out of 5 stars5/5 (3)

- La teoría de casi todo: El modelo estándar, triunfo no reconocido de la física modernaFrom EverandLa teoría de casi todo: El modelo estándar, triunfo no reconocido de la física modernaRating: 4 out of 5 stars4/5 (32)

- Electricidad: Fundamentos y problemas de electrostática, corriente continua, electromagnetiFrom EverandElectricidad: Fundamentos y problemas de electrostática, corriente continua, electromagnetiRating: 3.5 out of 5 stars3.5/5 (5)

- Mentalidades matemáticas: Cómo liberar el potencial de los estudiantes mediante las matemáticas creativas, mensajes inspiradores y una enseñanza innovadoraFrom EverandMentalidades matemáticas: Cómo liberar el potencial de los estudiantes mediante las matemáticas creativas, mensajes inspiradores y una enseñanza innovadoraRating: 4.5 out of 5 stars4.5/5 (5)

- Mi proyecto escolar Matemáticas Lúdicas: Adaptaciones curriculares para preescolar, primaria y secundariaFrom EverandMi proyecto escolar Matemáticas Lúdicas: Adaptaciones curriculares para preescolar, primaria y secundariaRating: 5 out of 5 stars5/5 (5)

- Sanación por Cristales - La guía definitiva para principiantes: Descubre el poder de los cristales curativos, piedras y minerales para la salud y la felicidadFrom EverandSanación por Cristales - La guía definitiva para principiantes: Descubre el poder de los cristales curativos, piedras y minerales para la salud y la felicidadRating: 4.5 out of 5 stars4.5/5 (14)

- Fundamentos de mecánica de fluidos.: Con ejercicios parcialmente resueltosFrom EverandFundamentos de mecánica de fluidos.: Con ejercicios parcialmente resueltosNo ratings yet

- Física cuántica para principiantes: Descubra los fundamentos de la mecánica cuántica y cómo afecta al mundo en que vivimos a través de todas sus teorías más famosasFrom EverandFísica cuántica para principiantes: Descubra los fundamentos de la mecánica cuántica y cómo afecta al mundo en que vivimos a través de todas sus teorías más famosasRating: 5 out of 5 stars5/5 (4)

- La física cuántica: Todo sobre la teoría capaz de explicar por qué los gatos pueden estar vivos y muertos a la vezFrom EverandLa física cuántica: Todo sobre la teoría capaz de explicar por qué los gatos pueden estar vivos y muertos a la vezRating: 4 out of 5 stars4/5 (4)

- La Teoría de Conjuntos y los Fundamentos de las MatemáticasFrom EverandLa Teoría de Conjuntos y los Fundamentos de las MatemáticasRating: 5 out of 5 stars5/5 (1)

- El principio de posibilidad: Cómo la física cuántica puede mejorar tu forma de pensar, vivir y amarFrom EverandEl principio de posibilidad: Cómo la física cuántica puede mejorar tu forma de pensar, vivir y amarRating: 4 out of 5 stars4/5 (6)

![Diseño de Experimentos [Métodos y Aplicaciones]](https://imgv2-2-f.scribdassets.com/img/word_document/436271314/149x198/596c96deb2/1654336147?v=1)