Professional Documents

Culture Documents

Implant A Cio de Clusters

Uploaded by

azmodeuz470 ratings0% found this document useful (0 votes)

11 views150 pagesOriginal Title

Implant a Cio de Clusters

Copyright

© © All Rights Reserved

Available Formats

PDF, TXT or read online from Scribd

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

© All Rights Reserved

Available Formats

Download as PDF, TXT or read online from Scribd

0 ratings0% found this document useful (0 votes)

11 views150 pagesImplant A Cio de Clusters

Uploaded by

azmodeuz47Copyright:

© All Rights Reserved

Available Formats

Download as PDF, TXT or read online from Scribd

You are on page 1of 150

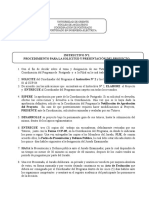

Autorizada la entrega del proyecto del alumno:

Manuel Reao Costales

EL DIRECTOR DEL PROYECTO

Miguel Angel Robles Rumayor

Fdo: Fecha:

V B del Coordinador de Proyectos

David Contreras Brcena

Fdo: Fecha:

PROYECTO DE FIN DE CARRERA

IMPLANTACIN DE CLUSTERS DE ALTA

DISPONIBILIDAD

DIRECTOR: Miguel Angel Robles

AUTOR: Manuel Reao Costales

UNIVERSIDAD PONTIFICIA COMILLAS

ESCUELA TCNICA SUPERIOR DE INGENIERA (ICAI)

INGENIERO EN INFORMTICA

RESUMEN DEL PROYECTO

En los entornos empresariales se demanda cada vez ms que las aplicaciones den

servicio de forma continua, siendo necesario para muchas aplicaciones de produccin

ofrecer una disponibilidad de 24x7. Esta necesidad lleva a muchas empresas a firmar

Acuerdos de Niveles de Servicio (ANS) que establecen los tiempos de parada mximos

que son asumibles por el negocio. Estos ANS pueden ser acuerdos internos con los

departamentos de IT de la propia empresa, pero tambin pueden ser externos con otras

empresas, si tienen externalizados los servicios de administracin IT, o si sus

aplicaciones dependen de aplicaciones de terceros.

Dentro de este marco, todas las tareas destinadas a evitar los fallos o a minimizar el

impacto de dichos fallos toman mucha ms importancia, puesto que cada incidencia

penaliza en cuanto al resultado de los ANS.

Sin embargo, no son las cadas por causas accidentales las responsables de la mayor

parte tiempo de no disponibilidad. Las tareas necesarias para la administracin y el

mantenimiento de los servidores y las aplicaciones son las causantes del 85% de media

del tiempo total de indisponibilidad, frente al 1% causado por fallos del HW, y el 14%

debido a otros factores, en su mayora errores humanos en la administracin.

Este proyecto nace de las dificultades que experimentaba el departamento de IT de una

empresa para alcanzar los niveles marcados por los ANS que tienen firmados. Los

servidores tenan problemas de rendimiento y cortes de servicio de las aplicaciones de

explotacin. Estos cortes estaban provocados tanto por la sobrecarga experimentada y

por incidencias accidentales como por las tareas de mantenimiento, cada vez ms

frecuentes a medida que la plataforma HW se quedaba obsoleta. Una vez identificada la

problemtica, la empresa ha solicitado presupuesto a varias compaas para que diseen

una solucin que corrija su situacin. Este proyecto conforma la propuesta presentada a

dicha empresa, y ha sido seleccionado e implantado con xito.

Para solucionar estos problemas, este proyecto propone dos aspectos: la renovacin de

los sistemas y la implantacin de una solucin de alta disponibilidad. La renovacin

HW pretende solucionar los problemas de rendimiento y reducir las tareas de

mantenimiento, y la solucin de alta disponibilidad pretende minimizar el impacto de

las cadas accidentales y enmascarar los tiempos de las paradas planificadas.

La primera etapa de este proyecto ha sido la de anlisis de requisitos y se ha realizado

de forma previa a la presentacin de la propuesta. Esta etapa ha consistido en la

identificacin de la plataforma HW del cliente y de las aplicaciones que componen sus

sistemas de produccin, desarrollo y calidad. Se han tomado datos de rendimiento de los

servidores para identificar los cuellos de botella y poder dimensionar correctamente los

nuevos sistemas.

La segunda etapa del proyecto, realizada tambin antes de la presentacin de la

propuesta, ha sido la del diseo de la solucin. Esta etapa se ha dividido en dos fases:

diseo de la plataforma HW y diseo de la topologa de cluster. Para la plataforma HW

se ha seleccionado entre los distintos servidores IBM System p5, que utilizan un sistema

operativo de tipo UNIX propietario de IBM llamado AIX. Para la solucin de clusters

de alta disponibilidad se ha seleccionado una solucin llamada IBM HACMP, y se han

configurado 4 clusters de dos nodos, en modo activo-activo para soportar todas las

aplicaciones de produccin de la empresa. Una vez realizado el diseo de la solucin se

ha presentado la propuesta al cliente.

Una vez aprobada la oferta, la siguiente etapa del proyecto ha sido la implantacin de la

solucin. Esta implantacin ha incluido la instalacin completa de los servidores y la

configuracin de los clusters, y la realizacin de pruebas de rendimiento y de

funcionamiento de HACMP. Esta etapa se ha concluido con la aceptacin por parte del

cliente de los resultados de las pruebas.

La ltima etapa del proyecto ha sido la entrega de la documentacin al cliente y el cierre

del proyecto. Dentro de la documentacin entregada se han incluido las conclusiones

que confirman que los objetivos iniciales se han alcanzado, y tambin se ha incluido una

serie de propuestas, para futuras ampliaciones o mejoras de los sistemas. Con le entrega

de la documentacin y la aceptacin por parte del cliente de las conclusiones se ha dado

por finalizado este proyecto.

HIGH AVAILABILITY CLUSTERS IMPLANTATION

ABSTRACT

In enterprises environments, there is a growing demand for their business applications

to offer a continuous availability, being necessary for some live applications to run in a

24x7 way. This necessity forces a lot of enterprises to sign Service Levels Agreements

(SLA), which establish the maximum downtimes that can be accepted by business.

This makes all the tasks focused on avoiding failures or diminishing the impact of these

failures to take much more relevance, since each incidence penalizes SLAs results.

Nevertheless, its not unplanned downtimes, due to accidental factors, that are

responsible of the longest total downtime. Tasks needed and scheduled for the

administration and maintenance of systems and applications are responsible for 85% of

the total system downtime, meanwhile HW failures only represents 1% and other

factors like human errors represents 14%.

This project is born of the difficulties that an IT department experienced to achieve their

SLAs signed levels. Their servers had performance issues and their applications

suffered loss of service. This downtimes were caused by servers overload, accidentals

failures and by maintenance tasks, more and more frequent as the HW remained

obsolete. Once they did identify the problem, this company asked several providers for

a solution that corrects their situation. This project is a proposal made to this company,

and it has been selected and successfully installed.

To solve these problems, this project suggests two ways: HW renovation and a high

availability (HA) clustering solution. HW renovation will lead to a performance

increase and will reduce maintenance necessity, and the HA solution will reduce

unplanned downtimes and it will also mask planned downtime.

The first step is to analyze the clients requirements, study their HW platform and their

applications. The performance has been analyzed, collecting the performance data to

identify bottlenecks and to determine the new systems capacities.

This projects second step is to design the HW platform and the clusters topology. HW

has been chosen from the IBM System p5 family, which runs a UNIX like operating

system called IBM AIX. The selected HA clustering solution is IBM HACMP,

configured with 4 two-node clusters, in an active-active topology, to achieve continuous

availability for their live applications.

The next step is the implantation. This step includes the servers complete installation,

the HA clusters configuration, and the performance and availability tests. This step is

concluded when the client gives its agreement to the results of the tests.

The last step of this project is the delivery of the documentation to the client. Within the

delivered documentation there are some conclusions that prove that the initial goals

have been achieved, and there are also some new proposals, for future upgrades and

improvements of the systems. Once the documentation has been delivered, the project

ends with the clients agreement to the conclusions presented.

ndice

I. Introduccin 1

II. Objetivos del proyecto 3

III. Alta Disponibilidad 6

IV. Anlisis de requisitos 12

IV.1. Situacin actual del cliente 12

IV.2. Rendimiento actual de los servidores 15

IV.3. Anlisis de los datos obtenidos 19

IV.4. Requisitos de los nuevos sistemas 22

V. Estudio de soluciones 24

V.1. Sistema operativo IBM AIX 24

V.2. Servidores IBM pSeries 25

V.3. Particionamiento Lgico LPAR 26

V.4. Ampliacin de capacidad bajo demanda (CUoD) 30

V.5. Habilitacin de capacidad bajo demanda (CoD) 30

V.6. IBM HACMP Clusters de Alta Disponibilidad 31

VI. Diseo de la solucin 36

VI.1. Configuracin hardware 36

VI.2. Configuracin HACMP 50

VI.3. Diseo final 56

VII. Evaluacin Econmica de la Oferta 62

VII.1. Valoracin Econmica HW/SW 62

VII.2. Valoracin Econmica servicios 84

VII.3. Valoracin Econmica Total 85

VIII. Implantacin de la solucin 86

VIII.1. Enracado de los servidores 86

VIII.2. Interconexin HMC Sistemas gestionados 88

VIII.3. Creacin de particiones 89

VIII.4. Instalacin del sistema operativo 98

VIII.5. Configuracin HACMP 99

IX. Configuracin adicional 107

IX.1. Auditoria de eventos 107

IX.2. Movimiento de recursos 108

IX.3. Sincronizacin horaria 110

X. Conclusiones 111

X.1. Objetivos alcanzados 111

X.2. Mejoras propuestas 117

Bibliografa 120

Anexos 121

Anexo A Auditoria 121

Anexo B Movimientos de recursos 127

Anexo C Configuracin de ntp 132

Anexo D Alta Disponibilidad sobre Linux 135

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 1 de 142

I. Introduccin

En los entornos empresariales, las aplicaciones de produccin as como los datos

que stas manejan constituyen dos de los activos ms valiosos y a la vez ms crticos de

las empresas. Su falta de disponibilidad puede suponer perjuicios graves tanto en

trminos econmicos como de prdida de confianza de los clientes y de merma de la

imagen. Garantizar la mxima disponibilidad de estos activos se ha convertido por lo

tanto en una de las principales prioridades de muchas empresas, dedicando a ello cada

vez mayores recursos. Claros ejemplos de esto son empresas como los bancos o las

empresas aseguradoras, cuyo negocio depende cada vez en mayor medida de las

aplicaciones on-line, pero tambin las administraciones pblicas que estn realizando

cuantiosas inversiones para desarrollar la llamada e-administracin.

Para poder aumentar la disponibilidad de las aplicaciones es vital conocer cuales

son los factores que pueden afectarla. Dichos factores se pueden englobar en tres

grandes categoras: disminucin de la disponibilidad por causas accidentales, por

gestin del sistema y por sobrecarga del sistema.

Disminucin de la disponibilidad por causas accidentales

Son tiempos de parada no planificados, y las causas ms comunes son:

- Fallo de un componente del servidor (alimentacin, adaptador de red,

procesador, memoria, etc)

- Fallo completo del servidor

- Fallo de acceso a los datos

- Fallo de un disco

- Fallo de un componente de la red (switches, cableado, etc)

- Fallo del suministro elctrico

Disminucin de la disponibilidad por gestin del sistema

Son tiempos de parada necesarios y planificados, y segn las estadsticas son la causa de

la mayor parte del tiempo de indisponibilidad. Las causas ms comunes son:

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 2 de 142

- Actualizacin de versiones (del sistema operativo o de las aplicaciones)

- Aplicacin de parches

- Tareas de administracin, mantenimiento y gestin (procesos batch, copias

de seguridad, etc)

- Pasos a produccin de nuevas aplicaciones

Disminucin de la disponibilidad por sobrecarga del sistema

- Normalmente picos temporales (horas punta, finales de mes, etc)

- Disminucin del rendimiento

- Ralentizacin de las transacciones

- Desconexin por time-out en las aplicaciones cliente

Los clusters de alta disponibilidad estn enfocados a paliar los efectos de las dos

primeras categoras (accidente y gestin). Son soluciones que mediante el uso de

elementos hardware y software intentan minimizar los tiempos de cada por accidente y

eliminar o enmascarar los tiempos de parada planificada por tareas de gestin. Se basan

en el uso de componentes hardware redundantes y de scripts para la automatizacin de

las tareas.

En el caso de la sobrecarga del sistema, los mecanismos ofrecidos por los

clusters de alta disponibilidad no mejoran el rendimiento, de hecho las medidas

adoptadas por estas soluciones pueden afectar en momentos puntuales el rendimiento.

Para estos casos hay que implementar soluciones que permitan la habilitacin de

capacidad bajo demanda (CoD, Capacity on Demand).

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 3 de 142

II. Objetivos del proyecto

Este proyecto nace debido a las dificultades que tiene el departamento de IT de

una empresa para cumplir los acuerdos de nivel de servicio (SLA, Service Level

Agreement) que tiene definidos, tanto internamente con otros departamentos de la

empresa como externamente con otras empresas. Debido a estos problemas se ha

planteado una renovacin de la plataforma hardware existente, consolidacin de

servidores de produccin y desarrollo, y la implantacin de alguna solucin que permita

aumentar la disponibilidad de las aplicaciones de produccin. Una vez planteado el

proyecto se ha solicitado una solucin a varios proveedores, que incluya los siguientes

requerimientos y condicionantes:

- Aumento del rendimiento

- Disminucin del tiempo de indisponibilidad

- Plataforma hardware ampliable

- Futura integracin de nuevas aplicaciones

- Ahorro de espacio

Es con estos condicionantes como se enfoca inicialmente este proyecto,

definiendo una lista de objetivos a cumplir:

Plataforma IBM AIX

Los sistemas actuales del cliente se basan en el sistema operativo IBM AIX

(sistema operativo UNIX propietario de IBM). Si bien no es requisito indispensable, el

uso de un sistema operativo conocido por el cliente, y la continuidad del soporte a las

aplicaciones es un factor positivo a la hora de presentar la oferta al cliente.

Aumento del rendimiento

El hardware ofertado debe ofrecer un rendimiento mayor del que obtienen con

su plataforma hardware actual.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 4 de 142

Asegurar la capacidad de proceso (CoD)

La sobrecarga generada en horas punta puede llegar a provocar una prdida de

disponibilidad. Mediante la habilitacin de capacidad bajo demanda se elimina un

posible punto de fallo.

Eliminacin de los puntos nicos de fallo (SPOF, Single Point Of

Failure)

Los SPOFs son componentes que constan de un solo elemento dentro del

sistema. Asegurando redundancia de todos los componentes se eliminan dichos SPOFs

y se asegura la disponibilidad en el caso de un fallo.

Eliminar o enmascarar el tiempo de parada planificado

El tiempo de parada planificado representa ms del 80% del tiempo total de no

disponibilidad de los sistemas. Eliminar este tiempo de parada supone por lo tanto una

mejora sustancial a la hora de cumplir con los acuerdos SLA.

Minimizar el tiempo de cada accidental

El tiempo de recuperacin tras una cada accidental depende del tiempo que se

tarda en detectar la cada y el componente que la ha causado. Haciendo que sea el

sistema quien detecte las cadas y automatizando el proceso de recuperacin se reduce

al mnimo posible este tiempo de no disponibilidad.

Asegurar la validez y consistencia de los datos

Si no se puede asegurar la validez de los datos estos carecen de valor para la

empresa. Una integracin adecuada de las aplicaciones con la solucin se logra

mediante el uso de scripts que controlan el estado de las bases de datos en el arranque y

en la parada de las aplicaciones.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 5 de 142

Integrar las aplicaciones de produccin

El objetivo de los clusters no es disponer de hardware redundante o de

servidores en alta disponibilidad, sino que se trata de poner en alta disponibilidad las

aplicaciones. La solucin adoptada debe por lo tanto permitir la integracin de muy

diversas aplicaciones, tanto comerciales como desarrollos propios.

Ahorro de espacio

Para el cliente el ahorro de espacio es muy importante, ya que sus servidores se

encuentran alojados en las instalaciones de un proveedor de servicios de hosting y

housing. En estas condiciones un ahorro de espacio supone para el cliente un ahorro de

costes en la relacin con su proveedor.

Asegurar capacidad de crecimiento

Para el cliente es primordial asegurar la capacidad de crecimiento de la solucin

adoptada, ya que en caso contrario no se justifica la inversin necesaria para realizar el

proyecto.

Ahorro de costes

Este proyecto conforma la oferta que se va a realizar a un cliente que ha

solicitado una solucin a varios proveedores, por lo que debe ser econmicamente

competitivo.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 6 de 142

III. Alta Disponibilidad

Este proyecto consiste en su mayor parte en el diseo, la implantacin y la

configuracin de una solucin de alta disponibilidad por lo que es conveniente aclarar lo

que se entiende por alta disponibilidad en los sistemas informticos y ver las diferencias

respecto de otras soluciones.

Los sistemas informticos se pueden clasificar en funcin de la disponibilidad y

fiabilidad que ofrecen en las siguientes categoras:

- sistemas stand-alone

- sistemas mejorados

- clusters de alta disponibilidad

- sistemas tolerantes a fallos

Sistemas stand-alone

Es la configuracin ms sencilla, y consta de un servidor nico y sin acceso a

almacenamiento externo. Si bien en la actualidad la mayora puede ofrecer muchas

mejoras, sigue teniendo mltiples SPOFs.

Puntos fuertes

- sistema de ficheros registrado por diario (por ejemplo JFS, Journaled File

System), que ofrece deteccin recuperacin de fallos leves

- fuentes de energa redundantes

- sistemas de refrigeracin redundantes

- memoria ECC, con cdigo de correccin de errores (ECC, Error Correcting

Code)

- desactivacin de procesadores en caliente

- procesador de servicio o similar, para una mejor administracin del HW y

administracin en remoto (incluido arranque en remoto)

- discos en distintos niveles de RAID

- kernel dinmico

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 7 de 142

Puntos nicos de fallo

- cada del servidor

- fallo de un interfaz de red

- fallo de la red

- fallo de la aplicacin

- fallo del sistema operativo

- camino nico a los datos

- discos no reemplazables en caliente

- fallo del site

Sistemas mejorados

Los sistemas mejorados disponen de acceso a almacenamiento externo con

distintos niveles de raid y que puede soportar el acceso a los datos por mltiples

caminos.

Puntos fuertes

- sistema de ficheros JFS

- fuentes de energa redundantes

- sistemas de refrigeracin redundantes

- memoria ECC

- desactivacin de procesadores en caliente

- procesador de servicio

- discos en distintos niveles de RAID

- kernel dinmico

- tarjetas reemplazables en caliente (hot-swap)

- mltiples caminos a los datos

- discos reemplazables en caliente (hot-swap)

- discos de reemplazo automtico (hot-spare)

- sistema de almacenamiento independiente

- fuentes de energa del almacenamiento redundantes

- sistemas de refrigeracin del almacenamiento redundantes

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 8 de 142

Puntos nicos de fallo

- cada del servidor

- fallo de un interfaz de red

- fallo de la red

- fallo de la aplicacin

- fallo del sistema operativo

- fallo del site

Sistemas de alta disponibilidad

Los sistemas de alta disponibilidad intentan solventar los problemas de los

sistemas stand-alone y mejorados mediante la redundancia de todos sus componentes.

Si uno de sus componentes fallase, otro componente de backup est a la espera para

asumir su carga de trabajo. Por ejemplo, si falla un adaptador de red otro adaptador

asume de manera automtica su direccin IP y su carga de trabajo.

Puntos fuertes

- sistema de ficheros JFS

- fuentes de energa redundantes

- sistemas de refrigeracin redundantes

- memoria ECC

- desactivacin de procesadores en caliente

- procesador de servicio

- discos en distintos niveles de RAID

- kernel dinmico

- tarjetas reemplazables en caliente (hot-swap)

- mltiples caminos a los datos

- discos reemplazables en caliente (hot-swap)

- discos de reemplazo automtico (hot-spare)

- sistema de almacenamiento independiente

- fuentes de energa del almacenamiento redundantes

- sistemas de refrigeracin del almacenamiento redundantes

- adaptadores de disco duales

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 9 de 142

- nodos redundantes (sistema operativo y aplicaciones)

- adaptadores de red redundantes

- redes redundantes

- monitorizacin de las aplicaciones

- sites redundantes mediante la replicacin a larga distancia

Puntos nicos de fallo

- fallo de la replicacin del site

Sistemas tolerantes a fallos

Los sistemas tolerantes a fallos estn diseados para no fallar nunca. Son

soluciones extremadamente complejas y costosas si se comparan con soluciones

basadas en clusters de alta disponibilidad. Los escasos fabricantes que venden sistemas

tolerantes a fallos ofrecen una gama reducida de soluciones, lo que significa poca

compatibilidad y poca escalabilidad.

En estos sistemas, la relacin entre precio y beneficio supone un problema,

como tambin lo supone la naturaleza propietaria del hardware y del sistema operativo,

lo que suele implicar el desarrollo a medida de todas las aplicaciones.

Dicho esto, los sistemas tolerantes a fallos estn diseados para no fallar, por lo

que si no se puede permitir ningn tiempo de cada de las aplicaciones (sistemas crticos

para la vida humana) entonces hay que plantearse este tipo de soluciones.

Puntos fuertes

- sistema de ficheros JFS

- fuentes de energa redundantes

- sistemas de refrigeracin redundantes

- memoria ECC

- desactivacin de procesadores en caliente

- procesador de servicio

- discos en distintos niveles de RAID

- kernel dinmico

- tarjetas hot-swap

- mltiples caminos a los datos

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 10 de 142

- discos hot-swap

- discos hot-spare

- sistema de almacenamiento independiente

- fuentes de energa del almacenamiento redundantes

- sistemas de refrigeracin del almacenamiento redundantes

- adaptadores de disco duales

- nodos redundantes

- adaptadores de red redundantes

- redes redundantes

- monitorizacin de las aplicaciones

- sites redundantes

- procesadores a prueba de bloqueos

- procesadores sncronos (lock-step)

- sistema operativo a prueba de bloqueos

- sistema operativo sncrono (lock-step)

- reinicio en continuo

Puntos nicos de fallo

- en teora ninguno, si bien en algunas configuraciones puede darse fallo del

site

La siguiente tabla ofrece la relacin entre algunos factores relevantes a la hora

de disear un sistema, en cuanto a disponibilidad se refiere:

Stand-alone Mejorados

Alta

disponibilidad

Tolerantes a

fallos

Tiempo de

recuperacin

Puede llegar a

das

Un par de

horas

Cinco

minutos

En teora

nulo

Disponibilida

d de los datos

La ltima

copia de

seguridad

disponible

La ltima

transaccin

La ltima

transaccin

Sin prdida

de datos

Coste

relativo

1 1,5 2-3 > 10

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 11 de 142

Beneficios de las soluciones de alta disponibilidad

Las distintas soluciones de alta disponibilidad ofrecen los siguientes beneficios:

- uso de componentes estndar, sin necesidad de hardware especializado

- se pueden implementar usando sistemas ya disponibles, por lo que se puede

evitar el gasto de invertir en HW nuevo

- funcionan con casi cualquier tipo de aplicacin, en cuanto a aplicaciones

comerciales se refiere

- trabajan sobre sistemas operativos comunes

- ofrecen una gran disponibilidad a un coste relativamente bajo

Requisitos para la alta disponibilidad

Para que un sistema de alta disponibilidad funcione correctamente y rentabilice la

inversin, es necesario cumplir una serie de requisitos:

- un diseo robusto y una planificacin detallada

- eliminacin de los puntos nicos de fallo

- seleccin del HW apropiado (si bien no necesita HW especializado para alta

disponibilidad, si que debe tener unas caractersticas mnimas)

- implementacin correcta y cuidadosa

- disciplina a la hora de administrar el sistema

- documentacin detallada y actualizada

- realizar pruebas exhaustivas

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 12 de 142

IV. Anlisis de requisitos

Para poder presentar una configuracin adecuada es necesario realizar un estudio

detallado de la situacin actual del cliente, la plataforma hardware, el sistema operativo

y las aplicaciones que tiene. De esta manera se podrn definir los requisitos mnimos

que deben tener los nuevos sistemas para cumplir con los objetivos.

IV.1. Situacin actual del cliente

En la actualidad el cliente tiene sus aplicaciones sobre mquinas con las

siguientes caractersticas:

- servidores 7026-B80 (pSeries 640 Model B80)

- 1 o 2 procesadores POWER3-II 375 MHz

- entre 512 MB y 4 GB de memoria ECC SDRAM

- 1 o 2 discos internos de 36,4 GB

- modelo enracable de 5 Us de alto

IBM pSeries 640 Model B80

La relacin de los servidores y sus configuraciones con las aplicaciones que

soportan es la siguiente:

Servidor Configuracin Aplicaciones

Baco 1-way 375 MHz, 1 GB

memoria, 2 discos

internos

Produccin: Ediswitch

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 13 de 142

Ceres 1-way 375 MHz, 1 GB

memoria, 2 discos

internos. Utiliza X25

Produccin: Editran +

Expedite

Cupido 1-way 375 MHz, 1 GB

memoria, 2 discos internos

Desarrollo: Informix +

servidor web

Diana 2-way 375 MHz, 1 GB

memoria, 1 disco interno

Produccin: Odex

Febo 1-way 375 MHz, 1 GB

memoria, 1 disco interno.

Utiliza X25

Produccin: Odex

Juno 2-way 375 MHz, 2 GB

memoria, 2 discos

internos

Produccin: Oracle

Jpiter 2-way 375 MHz, 2 GB

memoria, 2 discos

internos

Produccin: Oracle

Marte 2-way 375 MHz, 2 GB

memoria, 2 discos

internos

Produccin: Oracle

Mercurio 1-way 375 MHz, 2 GB

memoria, 2 discos

internos

Produccin: Oracle +

Informix

Minerva 1-way 375 MHz, 2 GB

memoria, 2 discos internos

Desarrollo: Oracle +

Informix

Neptuno 1-way 375 MHz, 1 GB

memoria, 2 discos internos

Desarrollo/Calidad:

Servidor web

Ops 1-way 375 MHz, 4 GB

memoria, 1 disco interno

Desarrollo: Weblogic

Pluton 1-way 375 MHz, 512 MB

memoria, 1 disco interno

Desarrollo: Weblogic

Saturno 1-way 375 MHz, 512 MB

memoria, 1 disco interno

Desarrollo: Weblogic

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 14 de 142

Urano 1-way 375 MHz, 2 GB

memoria, 1 disco interno

Desarrollo: Weblogic

Venus 1-way 375 MHz, 2 GB

memoria, 1 disco interno

Desarrollo: Weblogic

Relacin servidores/aplicaciones (en negrita estn las que se quieren poner en alta

disponibilidad

Rendimiento

Para los sistemas IBM pSeries existen varias medidas para el clculo del

rendimiento terico de los servidores. Estas medidas llamadas Relative Online

Transaction Processing (ROLTP) y Relative Performance (rPerf) establecen una

comparacin del rendimiento terico frente a una configuracin de base. En este caso se

usar la unidad rPerf como medida del rendimiento.

Los valores rPerf de los servidores del cliente son los siguientes:

- 1 procesador: rPerf = 1

- 2 procesadores: rPerf 2 (en realidad ligeramente inferior a 2, pero se toma

rPerf = 2 para las estimaciones)

El valor total de rPerf de los sistemas es por lo tanto de 20.

Almacenamiento

Los servidores con 2 discos internos tienen los discos en mirror (RAID nivel 1)

para evitar posibles fallos.

Los discos internos estn dedicados al sistema operativo y los ejecutables de las

aplicaciones.

Las aplicaciones de produccin con necesidades especiales de almacenamiento

(por ejemplo las bases de datos) tienen acceso a almacenamiento externo a travs de una

red SAN (Storage Area Network). Dicho almacenamiento est ubicado en cabinas de

discos externas, con acceso mediante conexiones de fibra ptica (cabinas EMC

CLARiiON).

Las aplicaciones de desarrollo y calidad tienen espacio asignado a travs de una

red NAS (Network Attached Storage).

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 15 de 142

Ubicacin y enracado

Los servidores del cliente se encuentran alojados en las instalaciones de un

proveedor de servicios de hosting y housing. Este proveedor proporciona el espacio

necesario dentro de unas salas de servidores acondicionadas segn los estndares:

suministro elctrico, temperatura y humedad controladas, seguridad de acceso, etc

Los servidores se encuentran enracados en armarios estndar de 36 Us de alto,

ocupando actualmente un total de 86 Us en 3 armarios (16 servidores de 5 Us de alto +

3 pantallas TFT de 2 Us de alto cada una).

IV.2. Rendimiento actual de los servidores

Desde la implantacin de los sistemas actuales, la carga de trabajo de todos los

servidores y las aplicaciones ha aumentado de manera considerable, lo que ha

provocado una disminucin del rendimiento. Dicha disminucin se ha traducido en unos

tiempos de respuesta cada vez mayores, provocando incluso desconexiones por time-out

cada vez ms frecuentes.

Para poder dimensionar correctamente el cliente ha facilitado los datos de

rendimiento de sus sistemas actuales en la situacin actual. En cada caso se va a estudiar

principalmente el rendimiento desde el punto de vista del procesador y de la memoria.

Se ha decidido que los aspectos relativos a los accesos a disco y los protocolos de red no

se tendrn en cuenta para el estudio de la solucin ya que para influir sobre estos dos

aspectos habra que estudiar el diseo de las aplicaciones, y esto est fuera del alcance

de este proyecto. Sin embargo, si en algn momento se detecta un problema con las

operaciones de entrada/salida, tanto en los discos como en la red, que pueda evidenciar

un problema ajeno al diseo de la aplicacin se estudiar una posible mejora de la

situacin, dentro de los lmites de este proyecto.

Servidor Baco

El servidor Baco consta de un procesador y 1 GB de memoria (rPerf = 1). La

aplicacin que soporta es una aplicacin de produccin (Ediswitch).

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 16 de 142

Los datos medios de ocupacin del procesador, obtenidos mediante el comando

sar, son los siguientes:

%usr %sys %wio %idle

Average 45 38 17 0

Los datos medios de utilizacin de la memoria, obtenidos mediante el comando

vmstat, son los siguientes:

kthr memory page faults cpu

----- ------------ ------------------------ -------------- -----------

r b avm fre re pi po fr sr cy in sy cs us sy id wa

19 3 277873 216415 0 14 6 72 600 0 498 5533 816 45 37 0 18

Los datos del espacio de paginacin, obtenidos mediante el comando lsps, son

los siguientes:

PgSpace PhysicalVolume VolumeGroup Size %Used Active Auto Type

hd6 hdisk0 rootvg 2048MB 35 yes yes lv

Servidor Ceres

El servidor Ceres consta de un procesador y 1 GB de memoria (rPerf = 1). Las

aplicaciones que soporta son aplicaciones de produccin (Editran y Expedite).

Los datos medios de ocupacin del procesador, obtenidos mediante el comando

sar, son los siguientes:

%usr %sys %wio %idle

Average 51 31 13 5

Los datos medios de utilizacin de la memoria, obtenidos mediante el comando

vmstat, son los siguientes:

kthr memory page faults cpu

----- ------------ ------------------------ -------------- -----------

r b avm fre re pi po fr sr cy in sy cs us sy id wa

8 1 211606 312682 0 17 8 67 743 0 512 6345 724 50 31 6 13

Los datos del espacio de paginacin, obtenidos mediante el comando lsps, son

los siguientes:

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 17 de 142

PgSpace PhysicalVolume VolumeGroup Size %Used Active Auto Type

hd6 hdisk0 rootvg 2048MB 29 yes yes lv

Servidor Pluton

El servidor Pluton consta de un procesador y 512 MB de memoria (rPerf 1).

La aplicacin que soporta es una aplicacin de desarrollo (Weblogic).

Los datos medios de ocupacin del procesador, obtenidos mediante el comando

sar, son los siguientes:

%usr %sys %wio %idle

Average 37 29 32 2

Los datos medios de utilizacin de la memoria, obtenidos mediante el comando

vmstat, son los siguientes:

kthr memory page faults cpu

----- ------------ ------------------------ -------------- -----------

r b avm fre re pi po fr sr cy in sy cs us sy id wa

9 2 100766 1564 0 224 123 521 894 0 738 5248 965 36 30 2 32

Los datos del espacio de paginacin, obtenidos mediante el comando lsps, son

los siguientes:

PgSpace PhysicalVolume VolumeGroup Size %Used Active Auto Type

hd6 hdisk0 rootvg 1024MB 91 yes yes lv

Servidor Saturno

El servidor Saturno consta de un procesador y 512 MB de memoria (rPerf 1).

La aplicacin que soporta es una aplicacin de desarrollo (Weblogic).

Los datos medios de ocupacin del procesador, obtenidos mediante el comando

sar, son los siguientes:

%usr %sys %wio %idle

Average 36 30 31 3

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 18 de 142

Los datos medios de utilizacin de la memoria, obtenidos mediante el comando

vmstat, son los siguientes:

kthr memory page faults cpu

----- ------------ ------------------------ -------------- -----------

r b avm fre re pi po fr sr cy in sy cs us sy id wa

9 2 101635 2703 0 384 309 639 523 0 863 6150 827 36 30 4 30

Los datos del espacio de paginacin, obtenidos mediante el comando lsps, son

los siguientes:

PgSpace PhysicalVolume VolumeGroup Size %Used Active Auto Type

hd6 hdisk0 rootvg 1024MB 93 yes yes lv

Servidor Diana

El servidor Diana consta de dos procesadores y 1 GB de memoria (rPerf 2). La

aplicacin que soporta es una aplicacin de produccin (Odex).

Los datos medios de ocupacin del procesador, obtenidos mediante el comando

sar, son los siguientes:

%usr %sys %wio %idle

Average 51 31 13 5

Los datos medios de utilizacin de la memoria, obtenidos mediante el comando

vmstat, son los siguientes:

kthr memory page faults cpu

----- ------------ ------------------------ -------------- -----------

r b avm fre re pi po fr sr cy in sy cs us sy id wa

8 1 211606 312682 0 17 8 67 743 0 512 6345 724 50 31 6 13

Los datos del espacio de paginacin, obtenidos mediante el comando lsps, son

los siguientes:

PgSpace PhysicalVolume VolumeGroup Size %Used Active Auto Type

hd6 hdisk0 rootvg 2048MB 29 yes yes lv

Si bien aqu solo se presentan los datos medios, el estudio del rendimiento ha

incluido la toma de datos de forma continuada durante un periodo de tiempo. De esta

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 19 de 142

manera tambin se contemplan los picos de sobrecarga temporales, las horas valle y la

evolucin de la carga. Es cierto que el periodo de tiempo no ha sido suficientemente

largo como para poder estudiar la estacionalidad de la carga del sistema, pero las

variaciones provocadas por dicha estacionalidad son mnimas segn los datos del

cliente, por lo que no supone un problema a la hora de dimensionar los nuevos

servidores.

Esta operativa se ha realizado sobre los 16 servidores, obteniendo datos

similares para todos. Con el anlisis de estos datos se obtendrn los problemas y los

cuellos de botella de cada servidor, y se podrn dimensionar los nuevos sistemas.

IV.3. Anlisis de los datos obtenidos

Comando sar

La columna %usr muestra en porcentaje el tiempo de ocupacin del procesador por

parte de los procesos de usuario.

La columna %sys muestra en porcentaje el tiempo de ocupacin del procesador por

parte de procesos del sistema operativo.

La columna %wio muestra en porcentaje el tiempo que el procesador est inactivo

porque algn proceso est a la espera de una operacin de entrada/salida.

La columna %idle muestra en porcentaje el tiempo que el procesador no est ocupado.

Un valor bajo de %idle con valores elevados de %usr y %sys suele indicar un

problema por falta de capacidad de proceso. Si los valores de %usr y %sys no son

elevados el problema se debe a un valor demasiado elevado de %wio, lo que puede

indicar varios problemas (mal diseo de las aplicaciones, problemas con las

controladoras de los discos, problemas de paginacin, etc).

Comando vmstat

Columna pi: pginas cargadas en memoria desde el espacio de paginacin

Columna po: pginas sacadas al espacio de paginacin desde la memoria

Columna fr: pginas liberadas (reemplazadas por otras)

Columna avm: pginas de memoria virtual activas

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 20 de 142

Columna fre: tamao de la free list

Columna r: hilos de ejecucin cargados en la lista de ejecucin

Columna b: hilos de ejecucin bloqueados a la espera de recursos

Un valor elevado de r tiende a indicar una limitacin desde el punto de vista del

procesador.

El valor de b suele ser proporcional al valor de %wio del comando sar. Por lo

tanto un valor elevado de b indica que hay procesos en espera por operaciones de

entrada/salida.

Valores elevados de pi, po y fr suelen indicar problemas por falta de memoria.

En estos casos suele aparecer un valor de fre bastante reducido en comparacin con el

valor de avm.

Comando lsps

Un valor elevado de %Used supone un problema para el servidor, y por lo

general indica un problema por falta de memoria. Si el espacio de paginacin se llena

demasiado el rendimiento del servidor cae de manera drstica hasta el punto de no poder

conectarse a l. Esto se puede solucionar aumentando el tamao del espacio de

paginacin, pero normalmente esta solucin no supone ms que un arreglo temporal por

lo que en esos casos es conveniente aumentar la memoria.

Analizando los datos de los servidores del cliente y teniendo en cuenta estas

consideraciones se observa en los servidores lo siguiente:

- Baco:

o CPU: est muy limitado por la CPU

o Memoria: no est limitado por la memoria

- Ceres:

o CPU: est bastante limitado por la CPU

o Memoria: no est limitado por la memoria

- Cupido:

o CPU: est muy limitado por la CPU

o Memoria: no est limitado por la memoria

- Diana:

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 21 de 142

o CPU: est bastante limitado por la memoria

o Memoria: no est limitado por la memoria

- Febo:

o CPU: est ligeramente limitado por la CPU

o Memoria: no est limitado por la memoria

- Juno:

o CPU: est bastante limitado por la CPU

o Memoria: est limitado por la memoria

- Jupiter:

o CPU: est bastante limitado por la CPU

o Memoria: est limitado por la memoria

- Marte:

o CPU: est bastante limitado por la CPU

o Memoria: est limitado por la memoria

- Mercurio:

o CPU: est muy limitado por la CPU

o Memoria: est limitado por la memoria

- Minerva:

o CPU: est muy limitado por la CPU

o Memoria: est bastante limitado por la memoria

- Neptuno:

o CPU: est muy limitado por la CPU

o Memoria: no est limitado por la memoria

- Ops:

o CPU: est bastante limitado por la CPU

o Memoria: est ligeramente limitado por la memoria

- Pluton:

o CPU: est bastante limitado por la CPU

o Memoria: est muy limitado por la memoria

- Saturno:

o CPU: est bastante limitado por la CPU

o Memoria: est muy limitado por la memoria

- Urano:

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 22 de 142

o CPU: est bastante limitado por la CPU

o Memoria: est ligeramente limitado por la memoria

- Venus:

o CPU: est bastante limitado por la CPU

o Memoria: est ligeramente limitado por la memoria

IV.4. Requisitos de los nuevos sistemas

Rendimiento

Con la configuracin actual los sistemas estn experimentando una carga

demasiado elevada para su capacidad de procesamiento. De manera adicional, la

implantacin de la solucin HACMP puede suponer en momentos puntuales una

sobrecarga en alguno de los sistemas. Para solventar estos problemas de rendimiento y

soportar la sobrecarga puntual provocada por HACMP, se estima que doblando su

capacidad total los sistemas podrn hacer frente a la carga de trabajo actual.

A corto plazo (de aqu a 3 aos), con el ritmo de crecimiento estimado de la

carga de las aplicaciones y la implantacin de nuevas aplicaciones, se estima que la

carga de trabajo que tendrn que soportar los servidores es el doble de la carga actual.

Adicionalmente, los sistemas ofertados deben tener capacidad de crecimiento y

ampliacin ms all de los tres primeros aos, como mnimo del doble del crecimiento

previsto a corto plazo.

Partiendo de un rPerf total actual de 20:

- para solventar los problemas de rendimiento se estima un rPerf total 40

- para hacer frente al crecimiento a corto plazo se estima un rPerf total 80

- para el crecimiento a medio plazo se estima un rPerf total 160

Almacenamiento

Al igual que en la configuracin actual, todos los datos de las aplicaciones de

produccin estarn en almacenamiento externo en la red SAN y se seguirn usando las

mismas cabinas EMC CLARiiON. Esto implica la necesidad de tarjetas de fibra ptica

para el acceso al almacenamiento externo.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 23 de 142

Las aplicaciones de desarrollo y calidad seguirn usando almacenamiento en una

red NAS.

A diferencia de la configuracin actual, el sistema operativo y los ejecutables de

las aplicaciones deben residir en dos discos internos en mirror en todos los servidores.

Ubicacin y enracado

Los sistemas ofertados se ubicarn en las instalaciones del proveedor de

housing, ocupando el lugar de los servidores actuales. Por lo tanto deben ser todos

modelos enracables (ningn servidor con formato de torre o sobremesa) y deben ocupar

un mximo de 3 armarios de 36 Us (108 Us).

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 24 de 142

V. Estudio de soluciones

V.1. Sistema operativo IBM AIX

El sistema operativo AIX es un sistema operativo de tipo UNIX propietario de

IBM. Tiene dos caractersticas principales que lo diferencian del resto de sistemas tipo

UNIX que son la integracin de un gestor de volmenes (LVM) y de un repositorio de

informacin del sistema (ODM) dentro del ncleo.

El LVM (Logical Volume Manager) es un gestor de volmenes lgicos que se

encarga de establecer el mapeado entre los filesystems, los volmenes lgicos sobre los

que residen y los volmenes fsicos (dispositivos de discos duros). Este gestor facilita

en gran medida la administracin de los discos y del espacio, permitiendo por ejemplo

realizar mirror (raid nivel 1) de los discos a nivel del sistema operativo sin necesidad de

una controladora de raid hardware.

La ODM (Object Data Manager) es un repositorio interno del sistema cuya

estructura mezcla el concepto de base de datos con el de orientacin a objetos. Este

repositorio contiene informacin del estado de todo el sistema, de los dispositivos

conectados, de los drivers que los controlan y del software instalado. Esta base de datos

supone una poderosa herramienta a la hora de administrar el sistema y ofrece mltiples

soluciones para la recuperacin del sistema frente a posibles fallos.

En la actualidad el sistema operativo IBM AIX est ligado a la plataforma

hardware RS6000/pSeries, que es una plataforma hardware propietaria de IBM basada

en la arquitectura RISC (Reduced Instructions Set Computer).

La versin actual de AIX es la versin 5.3 de AIX 5L. La letra L en el nombre

AIX 5L indica afinidad con Linux, lo que se traduce en la posibilidad de integrar

soluciones de Linux en el sistema operativo AIX (como por ejemplo la instalacin de

paquetes rpm).

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 25 de 142

V.2. Servidores IBM pSeries

Como ya se ha visto, la eleccin del sistema operativo IBM AIX condiciona la

eleccin del hardware y obliga al uso de servidores de la plataforma RS6000 de IBM.

La familia de servidores pSeries es la gama actual de la plataforma IBM

RS6000, y sus modelos ms actuales son los modelos IBM System p5.

Los procesadores que utilizan son procesadores de la familiar POWER

(Performance Optimization With Enhanced RISC), y estn actualmente en los modelos

POWER5 y POWER5+. Los servidores con procesadores POWER5+ podrn

actualizarse con procesadores POWER6 cuando estn disponibles (a lo largo de 2007)

mientras que los servidores con procesadores POWER5 no podrn.

El desarrollo de la arquitectura RS6000 y pSeries est estrechamente ligado al

del sistema operativo AIX, hasta tal punto que es la nica arquitectura sobre la que corre

dicho sistema operativo. Sin embargo los ltimos modelos de estos servidores aceptan

tambin Linux (algunas versiones especficas) e i5/OS (nueva versin del AS/400)

como sistema operativo. La arquitectura POWER tambin se ha estado usando en los

procesadores PowerPC, instalados por ejemplo en los ordenadores Macintosh de Apple

(hasta hace poco).

A lo largo de los aos, al desarrollo de estos servidores se han ido incorporando

progresivamente caractersticas propias de los sistemas mainframe de IBM (s390 y

zSeries), como la consola de gestin de hardware HMC (Hardware Management

Console) y el particionamiento LPAR (Logical PARtition).

Los modelos actuales de la familia POWER permiten la ampliacin de

capacidad bajo demanda (CUoD, Capacity Upgrade on Demand) mediante la activacin

de procesadores en caso de necesidad. Tambin permiten la habilitacin de capacidad

bajo demanda (CoD) mediante la asignacin de forma automtica de procesadores

activos pero no usados.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 26 de 142

V.3. Particionamiento Lgico LPAR

Particin

Una particin es una agrupacin de recursos del sistema. La creacin de

particiones divide el sistema en sistemas virtuales separados. Cada particin es un

entorno operativo independiente.

Cada particin tiene su propio sistema operativo, que puede o no coincidir con el

tipo de sistema operativo del resto de particiones del mismo sistema. Cada particin

puede arrancarse o pararse de manera independiente a las otras particiones.

Existen particiones fsicas y particiones lgicas. Las particiones fsicas se basan

en la divisin de los recursos por bloques fsicos. Cada bloque est compuesto de una

cantidad determinada de recursos (procesadores, memoria, discos y ranuras para

tarjetas), y estos recursos no se pueden compartir entre particiones, ni mover de una a

otra.

Particiones lgicas

Se habla de particiones lgicas cuando la divisin de los recursos se hace

mediante firmware. Al no basarse en bloques fsicos permite configuraciones ms

flexibles.

El particionamiento lgico es la capacidad de hacer que un nico sistema (un

nico bloque fsico) funcione como si fuese dos o ms sistemas. Cada particin

representa una divisin de los recursos del sistema.

Se habla de particionamiento lgico ya que la divisin de los recursos es virtual

y no se basa en asociaciones fsicas. Existen sin embargo ciertas reglas de configuracin

que hay que seguir a la hora de crear las particiones.

La asignacin de los recursos del sistema a las particiones y el acceso a estos se

hace mediante firmware. Aunque existan reglas de configuracin, la granularidad de las

unidades de los recursos que se pueden asignar a las particiones es muy flexible. Se

puede aadir una pequea cantidad de memoria sin importar el tamao de las tarjetas de

memoria y sin aadir ms procesadores o ranuras si no son necesarios.

La administracin de las particiones (creacin, asignacin de recursos,

movimientos de recursos, etc) se hace a travs de una consola externa denominada

HMC (Hardware Management Console) y un procesador adicional del servidor.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 27 de 142

La consola HMC consiste en un servidor adicional que lleva instalado un

sistema operativo Linux restringido y una aplicacin de gestin. Esta aplicacin se

comunica con el procesador adicional del servidor llamado procesador de servicio.

Este procesador de servicio es un procesador PowerPC a 970 MHz y es donde

corre el firmware que gestiona todos los recursos del servidor y los asignados a cada

particin.

Asignacin de recursos

Procesador

Al hablar de particiones lgicas existen distintos conceptos para los procesadores:

- procesadores fsicos

o procesadores instalados en el sistema.

- procesadores activos/inactivos

o los procesadores instalados pueden estar activos o inactivos. Los

inactivos no se pueden usar, y estn pensados para la ampliacin de

capacidad bajo demanda.

- procesadores dedicados

o los procesadores se pueden asignar a las particiones de manera

dedicada. En este caso se asignan procesadores completos. La

particin utiliza los mismos procesadores mientras est funcionando.

Si la particin se apaga estos procesadores pueden entrar o no en el

pool de procesadores compartidos.

- procesadores compartidos

o los procesadores compartidos son procesadores fsicos que se asignan

a las particiones sobre una base de comparticin del tiempo,

asignando ranuras de tiempo de procesamiento. Las particiones que

utilizan el pool de procesadores compartidos utilizan ranuras de

tiempo de cualquiera de los procesadores compartidos. El mnimo

que se puede asignar a una particin es 0,1 unidad de proceso, y los

incrementos se hacen en cantidades de 0,01 unidad de proceso. Una

unidad de proceso completo equivale al uso en exclusiva de un

procesador durante todo el tiempo. Una gran ventaja es que es posible

asignar menos de un procesador a las particiones con poca necesidad,

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 28 de 142

obteniendo as un importante ahorro. Otra ventaja es que una

particin con sobrecarga puede utilizar unidades de procesamiento

que no estn asignadas en ese momento.

- procesadores virtuales

o en el caso de los procesadores compartidos, el nmero de

procesadores virtuales es el nmero de procesadores fsicos que el

sistema operativo cree que tiene. Con esta cantidad se controla el

nmero de hilos de ejecucin que se pueden ejecutar

simultneamente. Aumentando esta cantidad se puede aumentar el

rendimiento sin aumentar la capacidad de proceso total asignada.

- procesadores lgicos

o el sistema operativo AIX tiene una opcin llamada Simultaneous

Multi-Threading (SMT) que permite la ejecucin de dos threads

distintos de manera simultnea en un mismo procesador (fsico o

virtual). Al activar la opcin de SMT el sistema operativo ejecuta dos

hilos de forma simultnea, usando para un hilo los tiempos de espera

del otro hilo. Esta opcin permite un uso ms eficiente del tiempo del

procesador.

Al asignar los procesadores a una particin, ya sea de manera dedicada o

compartida, hay que indicar tres cantidades: la mxima, la deseada y la mnima.

La cantidad deseada es la cantidad que intenta asignar a la particin al arrancar.

Si no hay disponible tanta cantidad va bajando hasta encontrar una cantidad disponible.

Si al llegar a la cantidad mnima indicada sigue sin haber suficiente no seguir bajando

y no arrancar la particin.

En caso de que la particin experimente una sobrecarga se le puede asignar ms

capacidad (ms procesadores o ms unidades de procesamiento) hasta llegar a la

cantidad mxima. Una vez asignada la capacidad mxima no se le asignar ms

capacidad.

A una particin arrancada nunca se la quitar capacidad de proceso de forma

automtica, pero se le puede quitar de manera manual para asignrsela a otra particin

con ms necesidad (o para realizar pruebas de stress). Si la particin llega a tener solo la

cantidad mnima indicada no se lo podr quitar ms.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 29 de 142

Memoria

La asignacin de memoria se realiza de manera muy parecida a la asignacin de

los procesadores. A cada particin se le indica una cantidad mnima, una cantidad

deseada y una cantidad mxima. Existe un tamao de los sectores de la memoria que

coincide con la cantidad mnima de memoria que se le puede asignar a una particin y

con el tamao de los incrementos en la asignacin de memoria. Este tamao vara en

funcin del modelo del servidor y del tipo de la memoria.

Slots de I/O

La asignacin de los recursos de entrada/salida se hace asignando las ranuras

(slots) en las que estn pinchadas las tarjetas (de red, de fibra, SCSI, etc). Las ranuras

se pueden asignar como necesarias y tambin como deseadas. En el caso de los

dispositivos asignados como necesarios la particin no arranque si dicho dispositivo no

est disponible (es decir que est asignado a otra particin). Estos dispositivos no se

pueden eliminar de la particin sin pararla, por lo que no se pueden mover de manera

dinmica. En el caso de los dispositivos asignados como deseados la particin intentar

arrancar con el dispositivo, pero si est asignado a otra particin puede arrancar de todas

maneras. Estos dispositivos si se pueden eliminar estando la particin arrancada, por lo

que se pueden mover de manera dinmica de una particin a otra. Esto es muy til en el

caso del lector de CD o la unidad de cinta.

Discos

La asignacin de los discos a las particiones se hace mediante la asignacin de

las controladoras SCSI internas que gestionan las bahas de los discos. Cada

controladora gestiona varias bahas, lo que implica que no se pueden asignar los discos

individualmente sino que hay se asignan por bloques. La cantidad de bahas gestionadas

por cada controladora vara en funcin del modelo del servidor, lo que permite

configuraciones ms flexibles en algunos modelos que en otros. Al igual que con los

slots de I/O las controladoras se pueden asignar como necesarias y como deseadas

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 30 de 142

Virtualizacin

En la mayora de los servidores pSeries se puede dar el caso en el que por

nmero de controladoras de disco y/o por nmero de tarjetas de red no se puedan crear

ms que nmero limitado de particiones, y sin embargo el nmero de procesadores y la

cantidad de memoria permitiran crear ms particiones. En estos casos es posible la

virtualizacin de los discos y de las tarjetas.

Esta virtualizacin se hace creando una particin especial llamada VIO Server

(Virtual I/O Server). Dicha particin lleva instalada una versin especial de AIX que le

permite compartir sus discos y sus adaptadores de red al resto de particiones. En el resto

de particiones se crean dispositivos virtuales que simulan de cara al sistema operativo

los dispositivos fsicos. De esta manera los discos controlados por una nica

controladora pueden estar asignados a varias particiones, y lo mismo con los

adaptadores de red. Esta opcin tiene la desventaja de que se desaprovecha cierta

cantidad de capacidad de procesamiento y de memoria, que est asignada al VIO Server

pero no es aprovechable por las aplicaciones, ya que la versin de AIX del VIO Server

solo est preparada para esta funcin, y no para la ejecucin de aplicaciones.

V.4. Ampliacin de capacidad bajo demanda (CUoD)

Los servidores pSeries permiten la instalacin de procesadores y memoria

inactivos en el sistema para su posterior activacin. La activacin de estos recursos se

puede hacer de manera permanente o de manera temporal. En el caso de la activacin

permanente se habla de ampliacin de capacidad (CUoD, Capacity Upgrade on

Demand). La activacin permanente puede ser necesaria para crear e instalar otra

particin o para aumentar la capacidad de alguna de las ya existentes.

V.5. Habilitacin de capacidad bajo demanda (CoD)

En los casos de activacin temporal de los recursos se habla de habilitacin de

capacidad (CoD, Capacity on Demand). La activacin temporal de procesadores o

memoria puede ser necesaria en ciertos casos como finales de mes o de ao, que pueden

generar sobrecarga en algunos sistemas. En estos casos la activacin se realiza de

manera manual, y solo se paga por los das que han estado activos los recursos.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 31 de 142

Existe tambin una opcin de CoD temporal sin costes. Esta activacin se realiza

por un periodo de 30 das, por ejemplo para realizar pruebas de una nueva aplicacin.

Adems de estas dos opciones existe tambin otra posibilidad llamada CoD de

Reserva. En esta opcin se solicita cierta cantidad de procesadores activos y cierta

cantidad de procesadores de reserva, pagando nicamente por los procesadores

activos. La caracterstica de esta opcin es que los procesadores de reserva estn en

realidad activos y colocados en el pool de procesadores compartidos, de manera que en

caso de sobrecarga se pueden asignar a las particiones de manera automtica. En este

caso solo se paga por los procesadores de reserva cuando la capacidad total asignada

sobrepasa la capacidad de los procesadores activos iniciales.

V.6. IBM HACMP Clusters de Alta Disponibilidad

Filosofa de HACMP

La solucin HACMP (High Availability Cluster Multi-Processing) es la solucin

de alta disponibilidad que tiene IBM para sus sistemas pSeries y el sistema operativo

AIX, y est basada en la arquitectura de cluster. Proporciona a la vez dos entornos:

- Alta Disponibilidad: se asegura la disponibilidad de una aplicacin mediante

el uso de recursos duplicados y el acceso compartido a los datos. Es la

opcin ms interesante de esta solucin.

- Cluster Multi-Procesamiento: balanceo de la carga de trabajo y de las

comunicaciones mediante el acceso concurrente a los datos desde mltiples

nodos. Esta opcin solo es posible cuando la aplicacin soporta y gestiona el

acceso concurrente y en la actualidad hay muy pocas aplicaciones

comerciales que lo hagan, por lo que no es relevante para este proyecto ya

que no es el caso.

Objetivos de HACMP

Centrndose en la opcin de alta disponibilidad, el objetivo de HACMP es la

disponibilidad en continuo (o por lo menos la mxima posible) de las aplicaciones. Para

lograrlo se centra en dos aspectos:

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 32 de 142

- operacin en continuo

o la arquitectura de cluster permite eliminar, o por lo menos

enmascarar, los tiempos de parada planificados por tareas de gestin.

Al estar constituido el cluster por varios nodos, los tiempos de

indisponibilidad de uno de los nodos no afectan a la disponibilidad de

la aplicacin ya que sta sigue activa en otro nodo.

- alta disponibilidad

o el uso de todos los componentes redundantes, incluidos los nodos, y

la automatizacin de las tareas de recuperacin reducen al mximo

los tiempos de cada por causas accidentales

Fundamentos de HACMP

Es una solucin basada en software pero que requiere que la configuracin

hardware sea adecuada, como por ejemplo el uso de componentes redundantes o la

configuracin de dos tipos distintos de redes de comunicacin (una red IP y una red no-

IP).

El software de HACMP chequea el estado de distintos componentes y la

disponibilidad de la aplicacin y automatiza mediante scripts las tareas de recuperacin

y reasignacin de los recursos (direcciones IP, discos, etc).

La solucin HACMP se basa en la creacin de grupos de recursos y de clusters.

Los clusters son asociaciones de servidores (o particiones) que comparten la

responsabilidad de mantener disponible una misma aplicacin (o varias). Si bien las

configuraciones ms usuales son las configuraciones de clusters de dos nodos se pueden

crear clusters con ms de dos nodos en funcin de las necesidades de cada entorno.

Los grupos de recursos son agrupaciones definidas que incluyen todos los

elementos necesarios para que una aplicacin est funcionando y disponible. Estos

recursos incluyen los discos y los filesystems con los datos, las direcciones IP y la

aplicacin (o las aplicaciones) que tienen que estar levantadas.

Dentro de un cluster, un grupo de recursos se considera como un solo elemento y

todos sus recursos se asignan a la vez a cada nodo, ya que no interesa que un nodo tenga

habilitada la direccin IP de acceso si los datos estn asignados a otro nodo.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 33 de 142

Clusters activo-activo y clusters activo-standby

Dentro de HACMP existen dos tipos bsicos de clusters diferentes: el cluster

activo-activo y el cluster activo-standby. Estos dos tipos se refieren bsicamente a

clusters de dos nodos, pero son extrapolables a clusters de ms nodos.

Un cluster es activo-activo cuando cada nodo tiene asociado al menos un grupo

de recursos. Esto implica que en condiciones normales cada nodo del cluster tiene al

menos una aplicacin activa. En caso de fallo de uno de los servidores el otro servidor

soporta la carga de las aplicaciones de ambos servidores.

Un cluster es activo-standby si solo uno de los dos servidores (en el caso de

clusters de dos nodos) tiene asociado algn grupo de recursos. Esto implica que en

condiciones normales solo uno de los nodos tiene activa una aplicacin, mientras que el

otro nodo est a la espera, de respaldo del primer nodo. En caso de fallo del servidor

que tiene la aplicacin el otro nodo tomara los recursos y activara la aplicacin. En

caso de fallo del servidor que est a la espera no pasa nada, salvo que el nodo con la

aplicacin se queda sin respaldo.

En el caso de clusters de ms de dos nodos las configuraciones ms usuales son

las siguientes:

- todos los nodos activos

o en esta configuracin todos los nodos tienen asociada una aplicacin.

En caso de fallo se suelen seguir polticas de fallover circulares.

- un nodo standby y el resto activos

o en esta configuracin todos los nodos menos uno tienen asociada una

aplicacin. En caso de fallo de alguno de los nodos activos se suele

tener definido en la poltica de fallover al nodo standby como

siguiente nodo para todas las aplicaciones.

Funcionamiento bsico de HACMP

En un cluster con los nodos y los grupos de recursos ya definidos, al arrancar el

cluster cada aplicacin se activa en un nodo. El nodo de activacin se define siguiendo

distintas polticas (nodo preferido, lista de prioridades, primer nodo activo o ltimo

nodo en el que estuvo activa) y se puede definir para cada aplicacin una poltica de

activacin distinta.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 34 de 142

La activacin de la aplicacin supone que el nodo se asigna los recursos

definidos para el grupo de recursos de la aplicacin en cuestin: tomar el control de los

discos compartidos y los filesystems con los datos, habilitar las direcciones IP en sus

adaptadores de red y levantar la aplicacin mediante el script definido para dicha tarea.

En ese momento empieza a monitorizar los distintos recursos; algunos elementos

se monitorizan mediante scripts propios de HACMP pero otros se tienen que

monitorizar mediante scripts definidos por el usuario (como por ejemplo la aplicacin o

elementos poco usuales como interfaces para X25). Si en algn momento detecta que

uno de los elementos no est disponible intentar recuperarlo en el mismo nodo. En el

caso del fallo de un adaptador de red habilitar la direccin IP en otro adaptador, o si el

fallo est en uno de los caminos de acceso a los discos compartidos habilitar el acceso

por otro camino. Si no puede recuperar el fallo en el mismo nodo inicia la accin de

fallover que consiste en trasladar los recursos a otro nodo (el siguiente disponible en

la lista de prioridades).

El orden en las listas de prioridades para el fallover se define de manera

independiente para cada grupo de recursos, por lo que distintas aplicaciones pueden

seguir polticas diferentes.

Por otro lado, mientras la aplicacin est activa en un nodo, el resto de nodos

monitoriza la disponibilidad del nodo y de la aplicacin. Si detectan que la aplicacin

no est disponible y que el nodo en el que est activa no puede recuperar el fallo, uno de

los nodos inicia por su cuenta el fallover de esa aplicacin, forzando el traspaso de los

recursos. Si solo existiese una red de comunicacin IP entre los nodos y sta fallase, se

podra dar el caso de que dos (o ms) nodos creyesen que la aplicacin no est

disponible en ningn nodo e intentasen tomar el control de los recursos y levantar la

aplicacin. Esto se conoce como cluster particionado y provoca fallos graves como la

inconsistencia o la corrupcin de los datos.

Los clusters particionados se evitan mediante el uso de dos tipos distintos de

redes de comunicacin. Por un lado estn las redes IP entre los nodos y con el exterior,

y por otro lado est una red no-IP que comunica nicamente los nodos de un cluster. De

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 35 de 142

esta manera si la comunicacin IP entre los nodos falla todava se comunican a travs de

esta segunda red y no levantan varios nodos la aplicacin. Esta segunda red se puede

realizar mediante cables serie (redes punto a punto) o mediante la comunicacin a travs

de los discos compartidos.

En caso de que el nodo original vuelva a estar disponible el grupo de recursos

puede volver o no a dicho nodo, realizando la accin de fallback. La opcin de

realizar o no fallback se define para cada grupo de recursos y puede ser una de las

siguientes: realizar siempre fallback, no realizar nunca fallback y volver al nodo

original al reiniciar el cluster.

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 36 de 142

VI. Diseo de la solucin

VI.1. Configuracin hardware

Servidores pSeries actuales

Dentro de la familia de servidores IBM System p5 los modelos actuales se

encuentran disponibles con procesadores de la gama POWER5 y POWER5+. Como ya

se ha visto, los sistemas con procesadores POWER5+ podrn actualizarse a POWER6

cuando est disponible (a lo largo de 2007), mientras que los sistemas con procesadores

POWER5 no podrn. Por lo tanto tan solo se tendrn en cuenta configuraciones con

procesadores POWER5+.

Dentro de la familia de servidores IBM System p5, teniendo en cuenta que

deben ser enracables y disponer de procesadores POWER5+, se encuentran las

siguientes opciones:

System p5 505 Express

- 1 o 2 procesadores POWER5+ 1,9 GHz o 2 procesadores POWER5+ 2,1

GHz

- de 1 GB a 32 GB de memoria DDR2 SDRAM

- hasta 600 GB de almacenamiento interno (2 bahas de discos)

- controladora Ultra320 SCSI Dual (interna y externa)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 2 slots PCI-X (1 largo, 1 corto)

- enracable, 1 U de alto

- opcional:

o tarjeta Fibre Channel 4 GB

o tarjeta ethernet 10 Gbps

System p5 505Q Express

- 4 procesadores POWER5+ 1,65 GHz

- de 1 GB a 32 GB de memoria DDR2 SDRAM

- hasta 600 GB de almacenamiento interno (2 bahas de discos)

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 37 de 142

- controladora Ultra320 SCSI Dual (interna y externa)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 2 slots PCI-X (1 largo, 1 corto)

- enracable, 1 U de alto

- opcional:

o tarjeta Fibre Channel 4 GB

o tarjeta ethernet 10 Gbps

IBM System p5 505 y 505Q Express

System p5 510 Express

- 1 o 2 procesadores POWER5+ 1,9 GHz o 2,1 GHz

- de 1 GB a 32 GB de memoria DDR2 SDRAM

- hasta 1,2 TB de almacenamiento interno (4 bahas de discos)

- controladora Ultra320 SCSI Dual (interna y externa)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 3 slots PCI-X

- enracable, 2 Us de alto

- opcional:

o tarjeta Fibre Channel 4 GB

o tarjeta ethernet 10 Gbps

System p5 510Q Express

- 4 procesadores POWER5+ 1,5 GHz o 1,65 GHz

- de 1 GB a 32 GB de memoria DDR2 SDRAM

- hasta 1,2 TB de almacenamiento interno (4 bahas de discos)

- controladora Ultra320 SCSI Dual (interna y externa)

- tarjeta ethernet 10/100/1000 Mbps Dual

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 38 de 142

- 3 slots PCI-X

- enracable, 2 Us de alto

- opcional:

o tarjeta Fibre Channel 4 GB

o tarjeta ethernet 10 Gbps

IBM System p5 510 y 510Q Express

System p5 520 Express

- 1 o 2 procesadores POWER5+ 1,65 GHz o 2,1 GHz o 2 procesadores

POWER5+ 1,9 GHz

- de 1 GB a 32 GB de memoria DDR2 SDRAM

- hasta 2,4 TB de almacenamiento interno (8 bahas de discos) hasta 16,8 TB

con cajones de expansin

- controladora Ultra320 SCSI Dual (interna)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 6 slots PCI-X

- enracable, 4 Us de alto

- opcional:

o tarjeta Fibre Channel 4GB

o tarjeta ethernet 10 Gbps

o 4x InfiniBand Switch

o hasta 4 cajones de expansin 7311-D20

System p5 520Q Express

- 4 procesadores POWER5+ 1,5 GHz o 1,65 GHz

- de 1 GB a 32 GB de memoria DDR2 SDRAM

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 39 de 142

- hasta 2,4 TB de almacenamiento interno (8 bahas de discos) hasta 16,8 TB

con cajones de expansin

- controladora Ultra320 SCSI Dual (interna)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 6 slots PCI-X

- enracable, 4 Us de alto

- opcional:

o tarjeta Fibre Channel 4GB

o tarjeta ethernet 10 Gbps

o 4x InfiniBand Switch

o hasta 4 cajones de expansin 7311-D20

IBM System p5 520 y 520Q Express

System p5 550 Express

- 2 o 4 procesadores POWER5+ 1,65 GHz o 1,9 GHz o 2,1 GHz

- de 1 GB a 64 GB de memoria DDR2 SDRAM

- hasta 2,4 TB de almacenamiento interno (8 bahas de discos) hasta 31,2 TB

con cajones de expansin

- controladora Ultra320 SCSI Dual (interna)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 5 slots PCI-X

- enracable, 4 Us de alto

- opcional:

o tarjeta Fibre Channel 4GB

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 40 de 142

o tarjeta ethernet 10 Gbps

o 4x InfiniBand Switch

o hasta 8 cajones de expansin 7311-D20

System p5 550Q Express

- 4 u 8 procesadores POWER5+ 1,5GHz o 1,65 GHz

- de 1 GB a 64 GB de memoria DDR2 SDRAM

- hasta 2,4 TB de almacenamiento interno (8 bahas de discos) hasta 31,2 TB

con cajones de expansin

- controladora Ultra320 SCSI Dual (interna)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 5 slots PCI-X

- enracable, 4 Us de alto

- opcional:

o tarjeta Fibre Channel 4GB

o tarjeta ethernet 10 Gbps

o 4x InfiniBand Switch

o hasta 8 cajones de expansin 7311-D20

IBM System p5 550 y 550Q Express

System p5 570

A diferencia de los modelos anteriores, que se componen de un solo bloque con

capacidad de proceso, el modelo 570 puede estar compuesto por ms de un bloque, en

funcin de la cantidad de memoria y del nmero de procesadores, slots PCI-X y bahas

de discos que se necesiten. Cada bloque de 4 Us de alto incorpora sus propios

Manuel Reao Costales Implantacin de Clusters

de Alta Disponibilidad

Pgina 41 de 142

procesadores y memoria, sus bahas de discos internos (6 bahas) y sus slots PCI-X (6

slots), y se interconectan los mdulos de los procesadores y los buses de datos.

Caractersticas de una configuracin con un nico bloque:

- 2 o 4 procesadores POWER5+ 1,9 GHz o 2,2 GHz

- de 2 GB a 64 GB de memoria DDR2 SDRAM a 533 MHz, o de 32 a 128 GB

de memoria DDR2 a 400 MHz (solo con procesadores a 2,2 GHz)

- hasta 1,8 TB de almacenamiento interno (6 bahas de discos) hasta 30,6 TB

con cajones de expansin

- 2 controladoras Ultra320 SCSI (internas)

- tarjeta ethernet 10/100/1000 Mbps Dual

- 6 slots PCI-X hot-plug (5 largos, 1 corto)

- enracable, 4 Us de alto

- opcional:

o tarjeta Fibre Channel 2 GB o 4 GB

o tarjeta ethernet 10 Gbps

o 4x InfiniBand Switch

o hasta 8 cajones de expansin 7311-D20

Caractersticas de la configuracin mxima con 4 bloques:

- hasta 16 procesadores POWER5+ 1,9 GHz o 2,2 GHz