Professional Documents

Culture Documents

Moerland2000 PDF

Uploaded by

simonpdf0 ratings0% found this document useful (0 votes)

13 views163 pagesOriginal Title

Moerland2000.pdf

Copyright

© Attribution Non-Commercial (BY-NC)

Available Formats

PDF or read online from Scribd

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Attribution Non-Commercial (BY-NC)

Available Formats

Download as PDF or read online from Scribd

0 ratings0% found this document useful (0 votes)

13 views163 pagesMoerland2000 PDF

Uploaded by

simonpdfCopyright:

Attribution Non-Commercial (BY-NC)

Available Formats

Download as PDF or read online from Scribd

You are on page 1of 163

MIXTURE MODELS FOR UNSUPERVISED

AND SUPERVISED LEARNING

THESE N° 2189 (2000)

PRESENTEE AU DEPARTEMENT D'INFORMATIQUE

ECOLE POLYTECHNIQUE FEDERALE DE LAUSANNE

POUR LOBTENTION DU GRADE DE DOCTEUR éS SCIENCES TECHNIQUES

PAR

Perry MOERLAND

Ingénieur informaticien, Technische Universiteit Eindhoven, Pays-Bas

de nationalité néerlandaise

‘acceptée sur proposition du jury:

Prof. W. Gerstner, directeur de thése

Prof. B. Faltings, rapporteur

Dr E. Mayoraz, rapporteur

Prof. C. Pellegrini, rapporteur

Dr J. Schmighuber, rapporteur

Lausanne, EPFL

‘2000

Version Abrégée

Cette these s"inscrit dans le vaste domaine de l'apprentissage automatique, Dans une société qui pro-

duit et consomme une quantité croissante (voire Aébordante) d'information, des méthodes permettant

de donner un sens & toute cette information deviennent.indispensables. L’apprentissage automatique

essaie de répondre & ce besoin par des modéles qui expliquent certains aspects dun flot de données.

Lors de la construction de tels modeles, il est important de se poser les questions suivantes

~ Quelle est la structure des données? Cette question est particuligrement pertinente pour des

données haute dimension que ’on ne peut plus visualiser dune fagon informative,

= Quelles sont les caractéristiques principales des données?

une autre?

~ Comment prédire si un motif appar

Cette these étudie ces trois questions avec, comme trait d'union, Pidée de construire des modéles

complexes & partir de modeles trés simples. La décomposition en sous-problémes se traduit aussi dans

les procédures utilisées pour estimer les valeurs des paramétres de ces modéles. Les algorithmes pour

Jes modéles simples forment le noyau des algorithmnes pour le modéle complexe

i une classe plutdt qu

Les questions posées ci-dessus sont traitées en trois volets

Apprentissage non-supervisé Cette partie est consacrée au probleme de Vestimation d'une den-

sité de probabilité, qui a pour but de trouver une bonne représentation probabiliste des données. Un

des modéles les plus utilisés pour l'estimation de densité est le mélange de Gaussiennes (ou multigaus-

siennes). Une alternative prometteuse au mélange de Gaussiennes consiste en un mélange de modéles

a variables cachées comme lanalyse en composantes principales (ACP) ou l’analyse factorielle. L’avan-

tage de ces modéles est qu’ils permettent, de représenter des matrices de covariance avec un nombre

inférieur de paramétres défini par le choix de la dimension d'un sous-espace. Une évaluation empirique

sur une large collection de bases de données montre que des modéles a variables cachées donnent des

résultats bien meilleurs que des multigaussiennes.

Pour pallier au choix par validation croisée de la dimension du sous-espace, une méthode d’esti-

mation Bayesienne pour des mélanges de modéles & variables cachées est. proposée. Cette méthode

permet de déterminer automatiquement la dimension adéquate pendant lentrainement. du modéle.

Extraction de caractéristiques L’AcP est aussi (et surtout) une méthode classique pour Vex-

traction de caractéristiques. Cependant, elle est limitée & une extraction linéaire par le moyen d'une

projection dans un sous-espace. L’ACP & base de fonctions noyaux (“kernel Pca”) permet 'extraction

non-linéaire des caractéristiques des données. L’application de la kernel Pca a une base de données

de N motifs demande de trouver les vecteurs propres d'une matrice de taille Nx.V. Un algorithme

“Expectation-Maximization” (Em) pour ACP qui ne nécessite pas le stockage de cette matrice, est

adapté & la kernel PCA afin que l'on puisse l’appliquer aux grandes bases de données de plus de 10.000

motifs. Les expériences démontrent Pintérét de cette approche et les caractéristiques extraites par ce

pré-traitement permettent entrainement de classifieurs simples mais performants. On décrit ici une

nouvelle variante de l'algorithme EM pour l'AcP qui l'aceélére considérablement en rendant possible

adaptation des paramétres d'une fagon inerémentale,

Apprentissage supervisé Cette partie montre deux maniéres de construire des modéles complexes

& partir de modales simples pour le probléme de la classification. La premiére approche s'inspire

directement des modeles de mélange pour l'apprentissage non-supervisé. Le modéle qui en résulte,

nommé mélange d'experts, essaie de diviser un probleme complexe en sous-problémes et attribue des

modiles simples & chaque sous-probléme. La division de Pespace et 1a recombinaison des réponses

des experts se fait par un antre modele, nommé pondérateur, dépendant des entrées. Aprés une vue

ensemble de ce moddle et des algorithmes existants destinés & Ventrainer, différents pondérateurs

sont proposés et comparés. Parmi ceux-ci se trouvent les modeles de mélange pour lapprentissage non-

supervisé. Les expériences montrent qu’un mélange d’experts standard avec un réseau de neurones

comme pondérateur donne les meilleurs résultats,

La deuxitme approche est un algorithme constructif, nommé “boosting”, et erée un ensemble

de modéles on mettant de plus en plus de poids sur les données qui ont été classifiées d’ume fagon

cerronée par les classificurs précédents. Un modéle a été développé qui se trouve & mi-chemin entre un

mélange d'experts et le boosting. Le mode ajoute au boosting une combinaison dynamique (comme

un pondérateur). Ceci a l'avantage qu’avec un ensemble nettement. plus petit le résultat obtenn est

souvent aussi bon qu’avec le boosting, De plus, le modéle a des bases solides dans la théorie de

Papprentissage.

Finalement, les moddles étudiés ici ont été évalués sur deux bases de données dans le domaine de

Ja vision. Les résultats confirment V'intérét des mélanges de modéles & variables cachées avec lesquels

on obtient des trés bons résultats dans un classifieur Bayesien.

You might also like

- Her Body and Other Parties: StoriesFrom EverandHer Body and Other Parties: StoriesRating: 4 out of 5 stars4/5 (821)

- The Sympathizer: A Novel (Pulitzer Prize for Fiction)From EverandThe Sympathizer: A Novel (Pulitzer Prize for Fiction)Rating: 4.5 out of 5 stars4.5/5 (119)

- Devil in the Grove: Thurgood Marshall, the Groveland Boys, and the Dawn of a New AmericaFrom EverandDevil in the Grove: Thurgood Marshall, the Groveland Boys, and the Dawn of a New AmericaRating: 4.5 out of 5 stars4.5/5 (265)

- The Yellow House: A Memoir (2019 National Book Award Winner)From EverandThe Yellow House: A Memoir (2019 National Book Award Winner)Rating: 4 out of 5 stars4/5 (98)

- A Heartbreaking Work Of Staggering Genius: A Memoir Based on a True StoryFrom EverandA Heartbreaking Work Of Staggering Genius: A Memoir Based on a True StoryRating: 3.5 out of 5 stars3.5/5 (231)

- The Little Book of Hygge: Danish Secrets to Happy LivingFrom EverandThe Little Book of Hygge: Danish Secrets to Happy LivingRating: 3.5 out of 5 stars3.5/5 (399)

- Hidden Figures: The American Dream and the Untold Story of the Black Women Mathematicians Who Helped Win the Space RaceFrom EverandHidden Figures: The American Dream and the Untold Story of the Black Women Mathematicians Who Helped Win the Space RaceRating: 4 out of 5 stars4/5 (890)

- Team of Rivals: The Political Genius of Abraham LincolnFrom EverandTeam of Rivals: The Political Genius of Abraham LincolnRating: 4.5 out of 5 stars4.5/5 (234)

- The Emperor of All Maladies: A Biography of CancerFrom EverandThe Emperor of All Maladies: A Biography of CancerRating: 4.5 out of 5 stars4.5/5 (271)

- Shoe Dog: A Memoir by the Creator of NikeFrom EverandShoe Dog: A Memoir by the Creator of NikeRating: 4.5 out of 5 stars4.5/5 (537)

- On Fire: The (Burning) Case for a Green New DealFrom EverandOn Fire: The (Burning) Case for a Green New DealRating: 4 out of 5 stars4/5 (73)

- The Unwinding: An Inner History of the New AmericaFrom EverandThe Unwinding: An Inner History of the New AmericaRating: 4 out of 5 stars4/5 (45)

- The Subtle Art of Not Giving a F*ck: A Counterintuitive Approach to Living a Good LifeFrom EverandThe Subtle Art of Not Giving a F*ck: A Counterintuitive Approach to Living a Good LifeRating: 4 out of 5 stars4/5 (5794)

- Grit: The Power of Passion and PerseveranceFrom EverandGrit: The Power of Passion and PerseveranceRating: 4 out of 5 stars4/5 (587)

- The World Is Flat 3.0: A Brief History of the Twenty-first CenturyFrom EverandThe World Is Flat 3.0: A Brief History of the Twenty-first CenturyRating: 3.5 out of 5 stars3.5/5 (2219)

- The Gifts of Imperfection: Let Go of Who You Think You're Supposed to Be and Embrace Who You AreFrom EverandThe Gifts of Imperfection: Let Go of Who You Think You're Supposed to Be and Embrace Who You AreRating: 4 out of 5 stars4/5 (1090)

- The Hard Thing About Hard Things: Building a Business When There Are No Easy AnswersFrom EverandThe Hard Thing About Hard Things: Building a Business When There Are No Easy AnswersRating: 4.5 out of 5 stars4.5/5 (344)

- Never Split the Difference: Negotiating As If Your Life Depended On ItFrom EverandNever Split the Difference: Negotiating As If Your Life Depended On ItRating: 4.5 out of 5 stars4.5/5 (838)

- Elon Musk: Tesla, SpaceX, and the Quest for a Fantastic FutureFrom EverandElon Musk: Tesla, SpaceX, and the Quest for a Fantastic FutureRating: 4.5 out of 5 stars4.5/5 (474)

- Dyoniso Aguado-EtudeDocument2 pagesDyoniso Aguado-EtudesimonpdfNo ratings yet

- Helton 2006Document35 pagesHelton 2006simonpdfNo ratings yet

- Poly RDocument27 pagesPoly RsimonpdfNo ratings yet

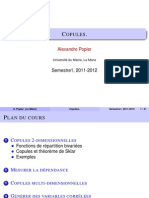

- Slides Copules PDFDocument51 pagesSlides Copules PDFsimonpdf0% (1)

- Gine2002 PDFDocument15 pagesGine2002 PDFsimonpdfNo ratings yet

- Wang2007 Input-Ouput ClusteringDocument6 pagesWang2007 Input-Ouput ClusteringsimonpdfNo ratings yet