Professional Documents

Culture Documents

Arquitectura de Sistemas Operativos (Resumen)

Uploaded by

DaniraOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Arquitectura de Sistemas Operativos (Resumen)

Uploaded by

DaniraCopyright:

Available Formats

lOMoARcPSD|3375621

Guia - Pratical practice for all the assigment.

Arquitectura De Sistemas Operativos (Universidad Abierta Interamericana)

StuDocu no está patrocinado ni avalado por ningún colegio o universidad.

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

GUIA DE REVISION

CUESTIONARIOS SOBRE LOS TEMAS TRATADOS

UNIDAD 1

1. Concepto de sistema operativo.

Es un programa que actúa de intermediario entre el usuario y el hardware porque crea un entorno de

ejecución de aplicaciones de usuario y administra el hardware de una computadora, las principales

funciones que debe tener un sistema operativo son:

Ofrecer una interfaz amigable: El objetivo primario de un Sistema Operativo es la comodidad del

usuario ya que existen porque se supone que es mas fácil la ejecución de aplicaciones con ellos que

sin ellos.

Brindar un entorno de ejecución de aplicaciones: El objetivo principal de las computadoras es la

ejecución de aplicaciones de usuario y facilitar la solución de los problemas del usuario, ejecutar sus

programas de usuario asignándoles recursos con la capacidad de detectar errores y mejorar el uso de

la CPU. El Sistema Operativo crea un entorno dentro del que otros programas pueden realizar un

trabajo útil.

Administrar recursos: Un Sistema Operativo es similar a un gobierno, si los componentes de un

sistema de computación son su Hardware, Software y Datos, entonces debe proporcionar los medios

para aprovechar adecuadamente esos recursos. Podemos ver al Sistema Operativo como un asignador

de recursos, dentro de un sistema de computación existen varios recursos (hardware y software) que

pueden ser necesarios para la resolución de un problema como el tiempo del CPU, espacio en memoria,

espacio para almacenamiento de archivos, dispositivos de E/S y demás. El Sistema Operativo actúa

como gestor de dichos recursos y los asigna a programas y usuarios según los necesiten.

Gestionar almacenamiento: Describe cómo se gestiona el sistema de archivos, el almacenamiento

masivo y las operaciones de E/S en un sistema informático moderno. El sistema de archivos

proporciona el mecanismo para el almacenamiento, acceso a datos y programas que residen en disco.

Prever mecanismos de seguridad y protección: Un Sistema Operativo debería garantizar la proteccion

(acceso a procesos, acceso de los usuarios a los recursos) y seguridad (defender al sistema de ataques

internos y externos) del sistema para que se preserve la integridad del sistema y de sus datos.

Ofrecer mecanismos de comunicación y sincronización entre procesos: El Sistema Operativo puede

proporcionar medios para que procesos cooperativos1 se comuniquen entre si a traves de mecanismos

de comunicación. Debido a que el acceso concurrente a datos compartidos por muchos procecsos

puede dar pie a inconsistencia en los datos, para eso existen mecanismos de sincronizacion que

aseguran la ejecución ordenada de procesos cooperativos que comparten un espacio de direcciones

logico, con el fin de mantener la consistencia de datos.

2 . Recursos que administra un SO.

Procesador: En el caso del procesador, el recurso que el Sistema Operativo debe asignar es el tiempo

de ejecución del procesador y la forma de asignarlo es la planificación para satisfacer varios objetivos

que incluyen equidad, uso eficiente del tiempo del procesador y poca sobrecarga.

Memoria: Una tarea central del Sistema Operativo es la gestión de memoria, lo que implica traer y

llevar bloques de datos de memoria secundaria y la gestión de transferencias entre memoria principal y

secundaria. Debido a los largos tiempos de las operaciones E/S, el Sistema Operativo debe asignar la

1

Los procesos cooperativos son procesos que pueden afectar o ser afectados por otros procesos que se ejecutan.

Resumen de sistemas operativos Página 1 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

memoria para asegurar una cantidad de procesos listos que consuman el tiempo disponible del

procesador.

Dispositivos de entrada y salida: Un Sistema Operativo debe ofrecer muchas funcionalidades a las

aplicaciones para que ellas puedan controlar todos los aspectos de los dispositivos y optimizar la E/S de

modo que la concurrencia sea máxima.

Archivos: Para que los usuarios puedan acceder a los archivos, guardarlos y mantener la integridad de

sus contenidos, los Sistemas Operativos proporcionan programas que se ejecutan como aplicaciones

privilegiadas. Los archivos necesitan servicios especiales del Sistema Operativo.

3 . Procesos por lotes.

Los sistemas operativos que trabajaban con procesos por lotes eran sencillos, su principal obligación era

transferir el control de un trabajo (un único programa) al siguiente, con la llegada del disco rigido, los

procesos por lotes incorporaron el spooling y esto logro que cuando el sistema necesitara realizar una

salida de datos de un trabajo se podia iniciar la entrada de datos de otro trabajo. La idea central bajo el

esquema de procesamiento por lotes sencillo es el uso de una pieza de software denominada monitor

(primera implementacion conocida de un sistema operativo) que controla la secuencia de eventos y los

programas de usuario, para ello gran parte del monitor debe estar residente en memoria.

4 . Aplicaciones del JCL.

JCL significa Job Control Language, lenguaje de control de trabajos, es un lenguaje de programación de

órdenes para un sistema operativo. Un sistema operativo puede ordenar que se comience o finalice un

trabajo, para ejecutar programa, solicitar una lectura o escritura de memoria, etc.

5 . Concepto de Spooling.

Su nombre proviene de acrónimo de operación periferica simultanea en linea, donde el disco se utiliza

como buffer para poder leer lo mas posible de los perifericos de entrada y para guardar los archivos de

salida hasta que los dispositivos de salida puedan aceptarlos. Esto permite funcionar con alto

rendimiento al procesador y a los dispositivos de entrada y salida. El spooling se comenzo a utilizar en

los sistmas por lotes sencillos que permitian discos rigidos, de modo que cuando un trabajo tenia que

realizar una salida, se podia realizar el ingreso de otro trabajo ya que el disco rigido trabajaba como un

buffer que almacenaba cosas para que el receptor pudiera tomar esos datos sin importar el tiempo que

transcurra.

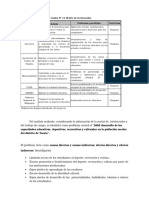

8 . Diferencias entre monoprogramacion y multiprogramación

Monoprogramacion Multiprogramacion

Solo se tiene un proceso que ocupa el procesador Una aplicación puede dividirse en varios

Resumen de sistemas operativos Página 2 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

y es el unico que se encuentra en memoria procesos.

debido a que no hay otros procesos Varios procesos pueden estar almacenados en

ejecutandose, una vez que termino de ejecutarse memoria esperando a utilizar el procesador.

la memoria es liberada. Según las politicas de planificación del

Predominaba en las computadoras con sistemas procesador, un proceso puede ser despojado del

operativos de un solo usuario y una sola tarea. procesador para que otro proceso que esta

Los procesos de una aplicación acaparaban la esperando a ser ejecutado lo ocupe.

CPU hasta su finalización. Permite ofrecer servicios a varios usuarios a la

vez.

Con la multiprogramacion se incrementa el aprovechamiento de la CPU y logra reducir los tiempos que la

CPU se encuentra ociosa.

9 . Describir los sistemas de programación por lotes, tiempo compartido y tiempo real.

Sistemas de programación por lotes: Existen dos tipos principales de sistemas por lotes:

Sistemas de lotes sencillos: En estos sistemas se mantiene en memoria un solo trabajo que es el que se

esta ejecutando. El funcionamiento de lsistema de procesamiento de un sistema por lotes sencillo está

garantizado por una pieza de software llamada monitor, cuya gran parte se encuentra siempre en

memoria, disponible para su ejecución. El monitor lee de uno en uno los trabajos desde el dispositivo de

entrada, una vez leído un trabajo, ese trabajo se coloca en el area en memoria dedicada a los programas

de usuario y se le pasa el control, antes de que el trabajo se termine de ejecutar los resultados se

muestran en dispositivos de salida, luego el monitor retoma el control que inmediatamente lee otro

trabajo. Una variante de los sistemas de lotes sencillos consistia en la incorporación de un disco, en vez

de leer las tarjetas desde el lector y llevarlas a memoria, se las llevaban al disco, asi mismo cuando el

trabajo requería realizar la salida de datos, esa salida de datos se almacenaba primero en disco antes de

enviarlo al dispositivo de salida. Esta forma de procesamiento se llama Spooling, en donde el disco se

utiliza como un gran buffer para leer por adelantado hasta donde sea posible de los dispositivos de

entrada y para guardar archivos de salida hasta que los dispositivos de salida puedan aceptarlos.

Sistemas de lotes multiprogramables: En los sistemas en lotes sencillos el procesador se encuentra

ocioso frecuentemente debido a que los dispositivos de E/S son mas lentos que el procesador, pero eso

puede evitarse albergando varios trabajos en memoria al mismo tiempo con el fin de que la CPU siempre

tenga un trabajo que ejecutar, para esto se requiere nuevas formas de planificación de memoria y

procesador para que se decida cuál de los trabajos se debe ejecutar. En los sistemas de programación

por lotes multiprogramables, al procesar un trabajo, tarde o temprano éste tendrá que usar un

dispositivo de E/S, sin embargo el Sistema Operativo selecciona otro trabajo, lo ejecuta y así

sucesivamente hasta que el primer trabajo termine de usar un dispositivo de E/S y recupere la CPU, de

esta manera, siempre que haya un trabajo que ejecutar, la CPU nunca estará ociosa. La

multiprogramacion se ha convertido en el primer caso en que el Sistema Operativo debe tomar una

decisión por el usuario: cuál de los trabajos procesar. Un sistema de lotes multiprogramados, al ser

compatible con la multiprogramación requiere formas de gestión de memoria para poder tener varios

programas en memoria principal al mismo tiempo. Tambien requiere de formas de formas de

planificación de la CPU si varios procesos están listos para ejecutarse al mismo tiempo, ya que el Sistema

Operativo debe escoger a cual de ellos le pasa el control.

Los sistemas de tiempo compartido han surgido de la incapacidad que el usuario tenía para interactuar

con el trabajo en el momento de su ejecución ya que los sistemas operativos por lotes eran apropiados

para ejecutar trabajos grandes que casi no necesitan interaccion ya que el usuario solo presentaba un

trabajo y luego esperaba un tiempo para obtener los resultados. En solucion a dicha poca interactividad,

surgen los sistemas de tiempo compartido, una extensión lógica de la multiprogramación, en la que la

CPU puede ser compartida por varios procesos, es tan frecuente la conmutación entre los procesos que

permite que el usuario pueda interactuar con cada programa durante su ejecución, pueda darle

instrucciones al programa para que éste las reciba y de una respuesta rapida. Los sistemas de tiempo

compartido permiten una comunicación directa entre el usuario y el sistema y ofrecen una ventaja a los

programadores por la flexibilidad y libertad que generaba desarrollar programas ya que debido a la alta

Resumen de sistemas operativos Página 3 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

interactividad con el usuario y el sistema es facil la deteccion de errores y mas rapida la obtención de

resultados, lo que en ocaciones se hace a traves de un mecanismo de intercambio, donde los procesos

entran y salen de la memoria principal a la memoria secundaria (disco) permitiendo la ejecución de

programas que no entran completamente en la memoria principal, substituyendola desde el punto de

vista logico por una matriz uniforme de almacenamiento de gran tamaño, separando asi la memoria

fisica de la logica, esta ultima es como la ve el usuario, esta disposición libera a los programadores de

preocuparse por las limitaciones de almacenamiento en memoria principal. Los sistemas de tiempo

paralelo permite a multiples usuarios compartir la computadora simultáneamente siendo que cada

usuario necesita un poco de tiempo del CPU. En los sistemas de tiempo compartido para que los

usuarios puedan acceder con comodidad tanto a los datos como al codigo de los programas, deben

contar con un sistema de archivos en linea, por lo general los archivos representan datos y programas,

los archivos se organizan en grupos logicos o directorios para facilitar la localizacion y el acceso a ellos

ya que es deseable controlar quién puede acceder a los archivos y de qué formas puede hacerlo.

Los sistemas de tiempo compartido son mas complejos que los sistemas por lotes multiprogramados y

necesitan lo siguiente:

Gestion y protección de memoria: Al igual que en la multiprogramacion, es necesario tener varios

trabajos simultáneamente en memoria.

Memoria virtual: Es una técnica que permite ejecutar un trabajo que tal vez no está en su totalidad en

memoria principal, se usa para lograr un buen tiempo de respuesta a la hora de intercambiar trabajos

desde la memoria principal y el disco y tambien para que las aplicaciones no estén limitadas al tamaño

de memoria principal

Planificación de CPU: Debido a los mecanismos de de ejecución concurrente de procesos.

Gestión de discos: Lo necesita debido a que el sistema de archivos reside en una colección de discos.

Sincronizacion y comunicación de procesos: Para asegurar que los trabajos no se atasquen en un

bloqueo mutuo, esperando cada uno a que el otro termine.

Sistemas de tiempo real: Son sistemas que deben ejecutar procesos en un tiempo estrictamente definido,

solo sistema solo funciona correctamente si produce los resultados correctos en el tiempo estipulado, de

manera contraria fallara. Esto contrasta con los sistemas por lotes en donde no hay restricciones de

tiempo y predomina la monoprogramacion y los sistemas de tiempo compartido en los que es deseable

responder de forma rapida pero no es obligatorio como en los sistemas de tiempo real. En estos

sistemas el uso del almacenamiento secundario es muy limitado y el sistema operativo busca separar

aun mas al usuario del hardware.

1 0 . Multiprocesamiento.

Es una caracteristica de los sistemas multiprocesador, que permite la existencia de varios procesadores

que pueden comparir el bus, reloj, a veces la memoria y los periféricos que fisicamente forman parte de

una computadora. Al incrementar el número de procesadores aumenta el rendimiento, aunque al llevar a

cabo una tarea existe cierto gasto del rendimiento para mantener todos los componentes funcionando

correctamente.

Las ventajas del multiprocesamiento son las siguientes:

Mejor rendimiento: Si bien la mejora en la velocidad con n procesadores no es una multiplicación por n,

sino que es menor que tal resultado, se realiza mayor cantidad de trabajo en menos tiempo, parte de

trabajo que se emplea es para conseguir que los n procesadores funcionen correctamente y para

garantizar el correcto funcionamiento del sistema en la contienda por los recursos compartidos por

todos los procesadores.

Economía de escala: Resultan más economicos que tener multiples sistemas con un solo procesador ya

que comparten perifericos (procesamientos masivos, fuentes de alimentación, etc).

Mayor fiabilidad: si solo un procesador falla, el resto no deja de funcionar pero si ocurre una baja en el

rendimiento.

Hay dos tipos de multiprocesamiento:

Resumen de sistemas operativos Página 4 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Multiprocesamiento asimetrico: Cada procesador se asigna a una tarea especifica, un procesador

maestro controla el sistema y el resto de los procesadores esperan a que el maestro les de instrucciones

o tienen asignadas tareas definidas.

Multiprocesamiento simetrico: Es el tipo de multiprocesamiento mas comun, cada procesador realiza

todas las tareas correspondiente al sistema operativo, sin existir una relacion exclavo maestro entre los

procesadores.

La diferencia entre procesamiento simetrico y asimetrico puede deberse tanto al hardware (el hardware

diferencia los multiples procesadores) como software (se puede programar el software para que solo

haya un mastro y multiples esclavos).

El multiprocesamiento permite la multitarea, que es una tecnica en la cual una aplicación en ejecución

(proceso) se divida en una seria de hilos que pueden ejecutarse concurrentemente.

Hilo Proceso

Es una unidad de trabajo, incluye el contexto de la Es una colección de 1 o más hilos y sus recursos de

CPU (que contiene el contador del programa y el sistema asociados (codigo, datos, memoria, etc),

puntero de pila) y su propia area de datos para una esto corresponde al concepto de programa en

pila (para posibilitar el salto a subrutinas), un hilo ejecución.

se ejecuta secuencialmente y se puede interrumpir

de forma que el procesador pueda dar paso a la

ejecución de otro hilo.

La diferencia entre hilos y procesos es que los hilos comparten el espacio de memoria del proceso en el

que viven, excepto la pila.

1 1 . Señalar diferencias entre proceso distribuido y multiproceso.

Proceso distribuido

Se distribuye un proceso entre varios procesadores que no comparten la memoria ni el reloj, cada

procesador cuenta con su propia memoria pero se comunican entre si a través de cables de red.

Se puede distribuir la ejecución de un proceso en varios procesadores que lo ejecutan de forma

concurrente.

Si un procesador falla el resto de los procesadores pueden seguir funcionando siempre que no haya

dejado de ejecutar algun proceso critico en el sistema.

Consta de un conjunto de maquinas fisicamente separadas.

Una computadora puede ejecutar un sistema operativo de red, esta computadora se comunica con

otras que se encuentran en la misma red.

Multiproceso:

Varios procesadores comparten el bus, reloj, a veces la memoria y los periféricos de la computadora.

Los procesadores se encuentran fisicamente en una misma maquina.

UNIDAD 2

1 . Estructuras que presentan los SO.

Estructura simple y por niveles.

2 . Características fundamentales de la estructura monolítica

Resumen de sistemas operativos Página 5 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Los sistemas operativos con estructura monolítica suelen ser mas simples y pequeños, no es dividido en

niveles, por lo tanto incluso una aplicación puede utilizar rutinas del sistema operativo para realizar

operaciones de entrada y salida sin ningún tipo de restricción, lo que hace que sea vulnerable a cuando

fallan las aplicaciones de usuario. La estructura monolitica usada en Unix era solo el kernel acompañado

por los programas de sistema, pero como el kernel se encargaba de la gran mayoria de las funciones del

sistema era difícil de implementar y mantener.

3 . Características de la estructura jerárquica

La estructura jerárquica de un sistema operativo es por niveles o módulos, esto significa que el sistema

operativo se divide por capas. El conjunto de rutinas de mas bajo nivel lo tiene el kernel que es el

encargado de cumplir con la funcionalidad del sistema operativo (solicitudes a dispositivos E/S,

planificación de procesos, gestion de memoria, sistemas de archivos, paginación, etc). Cuando una capa

superior realiza una solicitud de algun servicio del sistema operativo, ese servicio es brindado por una

capa inferior, esto sucede para que se oculten los detalles de implementacion del sistema operativo a las

capas superiores, porque solo es necesario que las capas superiores sepan que cosas puedan solicitar,

eso significa que lo visible para cada capa superior a una capa inferior es la interfaz de ésta ultima. El

nivel mas bajo de un sistema operativo es el kernel, que es la parte del sistema operativo que mas en

contacto está con el hardware, un nivel superior al kernel son las bibliotecas del sistema, interpretes de

comando y compiladores y a un nivel aun mas alto estan los usuarios.

4 . Concepto de máquina virtual.

Es un software que crea un entorno virtual entre la plataforma de la computadora y el usuario final,

permitiendo que este ejecute un software determinado. Este entorno visual es lo que aísla al usuario del

funcionamiento interno de la máquina que puede resultar ser muy complejo. En realidad la idea principal

es la de permitir ejecutar varios sistemas operativos simultáneamente sobre el mismo hardware. Para

ello, separa las dos funciones básicas que realiza un sistema de tiempo compartido: multiprogramación

y abstracción del hardware.

Una característica esencial de las máquinas virtuales es que los procesos que ejecutan están limitados

por los recursos y abstracciones proporcionados por ellas. Estos procesos no pueden escaparse de este

"ordenador virtual". Una máquina virtual es un software que emula a un ordenador y puede ejecutar

programas como si fuese un ordenador real.

5 . Función del núcleo en un SO del tipo cliente- servidor.

Un sistema del tipo Cliente-Servidor es un tipo especializado de un sistema distribuido en el que el

sistema Cliente realiza peticiones a un sistema Servidor para que este ultimo pueda realizar lo que el

cliente pide en caso de que si se pueda.

Un servidor proporciona una interfaz a la que el cliente le envia una solicitud para realizar una accion,

este mensaje es manejado por el núcleo y se llama Request. Si el servidor puede realizar lo que el cliente

le pide le envia una respuesta que tambien es un mensaje manejado por el núcleo y se llama Reply.

Entonces la funcion del núcleo en un sistema operativo Cliente-Servidor es permitir que ambos se

puedan comunicar entre si enviándose mensajes.

6 . Servicios que debe proporcionar un SO.

Debido a que un sistema operativo proporciona un entorno para la ejecución de aplicaciones, presta

servicios a los programas y usuarios de dichos programas. Los servicios que resultan utiles al usuario

son:

Resumen de sistemas operativos Página 6 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Proveer una interfaz de usuario: Puede tratarse de una interfaz de linea de comando (interprete de

comando, shell) o interfaz gráfica de usuario (GUI).

Ejecución de programas: Cargar programas en memoria, ejecutarlos y terminar con su ejecución de

forma normal o anormal.

Controlar los dispositivos de E/S: Todo proceso puede realizar una E/S y por cuestiones de proteccion

el sistema operativo debe llevarlo a cabo.

Manipulación de sistemas de archivo: Permitir definir permisos para manipular el sistema de archivos,

incluidos los programas de usuario para acceder a los archivos, permitir leerlos, modificarlos, escribirlos,

borarrlos, etc.

Comunicaciones: Proporcionar medios por los cuales procesos puedan comunicarse entre si mediante

paso de mensajes o utilizando memoria compartida, dicha comunicación puede tener lugar entre

procesos que están en la misma computadora o diferentes computadoras conectadas a una red.

Deteccion de errores: Necesita detectar constantemente los posibles errores, estos errores pueden

producirse en el hardware (procesador, memoria, dispositivos e/s) o en el software (programas de

usuario), para cada tipo de error, el sistema operativo debe llevar a cabo la accion apropiada para

asegurar el correcto funcionamiento del sistema.

Los servicios que brindan los sistemas operativos pero que no se relacionan con el usuario sino con el

correcto funcionamiento del sistema son:

Asignación de recursos: Cuando hay varios usuarios y varios procesos a ejecutar, se debe asignar los

recursos necesarios y liberarlos a cada ellos como los ciclos de cpu, memoria principal, espacio de

almacenamiento de archivos, etc. Por lo tanto debe contener politicas para la planificación de los

procesos, su sincronizacion, memoria principal, etc.

Proteccion y seguridad: La proteccion implica que el sistema operativo asegure todos los accesos a

recursos del sistema (proteccion de la cpu para que no entre en ciclos infinitos, acceso de un programa

de usuario a una era de memoria que le corresponde al sistema operativo, etc), la seguridad implica

asegurar el acceso al sistema (mediante contraseñas, permisos de usuario, etc).

7 . Manejo de las interrupciones

Una interrupción es una suspensión temporaria de la ejecución de un proceso para llamar a subritunas

del sistema operativo o de la ROM BIOS. Puesto que una interrupción es una forma de llamado a

subrutina, tambien comprende mecanismos para el uso de una pila para almacenar direcciones de

retorno y contenido de los registros, la pila es necesaria porque es comun que la subrutina llamada por

una interrupción a su vez sea interrumpida para llamar a otra subrutina y esta sengunda tambien puede

sufrir interrupciones y asi sucesivamente.

Existen tres dos basicos de interrupciones:

Interrupción por software: Es una interrupción interna, por medio de una instrucción específica

presente en un proceso, se interrumpe la ejecución del proceso para llamar a subrutinas del sistema

operativo.

Interrupción por hardware: Ocurren en el exterior del CPU, tienen lugar cuando una interfaz activa su

señal de solicitur de interrupción (IRQ).

Una interrupción por software sucede cuando en la ejecución de un proceso hay una instrucción que

solicita llamara a una subrutina específica del sistema operativo que brinda un servicio. A diferencia de

las interrupciones por hardware, queda establecido en que momento de la ejecución de un proceso

ocurrirá ya que se trata de una instrucción que está presente en un programa, dicha instrucción es la que

solicita llamara a las rutinas del sistema operativo, por ejemplo abrir o cerrar un archivo, acceder a disco,

imprimir, visualizar información en pantalla y todo lo relacionado con manejo de perifericos.

Resumen de sistemas operativos Página 7 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

1) La ejecución del proceso debe solicitar una llamada a una subrutina del sistema operativo con la

instrucción INT21, según cuantas posiciones de memoria ocupe cada vector, el sistema operativo

multiplica el numero de la interrupción por ese numero de posiciones (en este caso son 4) para

acceder a la direccion de la rutina que atiende a esa interrupción.

2) El resultado obtenido en el punto 1 es el desplazamiento dentro del primer segmento donde

comienza la memoria principal denominada zona interrupcion, en esta direccion obtenida por medio

de una calculo se encuentra la direccion CS:IP de la subrutina que aitnede a la interrupcion.

3) La unidad de control apila el registro de estado (que contiene el contenido de los flags) y luego la

direccion de la proxima instrucción a la interrupcion.

4) Comienza la ejecución de la subrutina que atiende a la interrupcion.

a. Las primeras instrucciones apilan el contenido de los registros del procesador que tenia antes

del llamado a la subrutina que atiende la interrupcion.

b. Se ejecuta el codigo de la subrutina.

c. En las ultimas instrucciones de la subrutina se ordena desapilar el contenido de los registros

que se apilaron en 4a.

5) La ultima instrucción de la subrutina necesariamente debe ser IRET y ordena desapilar la dirección de

la siguiente instrucción de la interrupcion del programa llamador.

Una interrupcion por hardware sucede cuando a la CPU le llega una señal IRQ por medio de un cable

proveniente de la placa interfaz de un dispositivo con el objetivo de solicitarle al sistema operativo que

atienda la señal que envió dicha placa interfaz del dispositivo. La placa interfaz de un dispositivo envia

una señal IRQ a la CPU cuando el periferico conectado a esa interfaz concretó algo, por ejemplo se pulsó

una tecla en el teclado, se liberó una tecla, una impresora está lista para recibir mas datos, se terminó de

leer o escribir en disco, mostrar un aviso de estado del dispositivo en pantalla, generar la hora y los

minutos que se ven en pantalla, etc. Notese como estos eventos (tecla pulsada, fin de acceso directo a

memoria, reloj, etc) a diferencia de las interrupciones por software no pueden ser previstos cuando

ocurriran.

Resumen de sistemas operativos Página 8 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

1) La linea IRQ de la interfaz 1 envia una

señal a un chip donde se encuentra el

arbitro de interrupciones, en caso de que

hayan mas señales IRQ provenientes de

otras interfaces simultáneamente, el arbitro

le otorga la petición de interrupcion a la IRQ

que mas prioridad tiene, en el grafico es a

la menor subíndice.

2) En correspondencia a la linea IRQ con

mayor prioridad, el arbitro activa la linea

INTR que va a la CPU para que la Unidad de

Control verifique (según el valor del flag i),

si el procecso en ejecución puede ser

interrumpido o no.

3) Luego de terminar de ejecutar cada

instrucción, la Unidad de Control censa que

la linea INTR que le llega desde el arbitro

esté activada, si no está activada, ejecuta la

siguiente instrucción, pero si está activada,

como en este caso, se acepta la solicitud.

4) El flag i vale 1 y se acepta la solicitud de

interrupcion que llegó al activarse INTR, la

Unidad de Control le envia al arbitro de

instrucciones una señal llamada INTA

(aceptación) pasando la CPU de modo

usuario a modo kernel.

5) El arbitro envía hacia la Unidad de

Control por el bus de datos la direccion en

memoria donde está el vector interrupcion

que contiene la direccion de la subrutina

del sistema operativo que está preparada

exclusivamente a atender la interrupcion.

6) La Unidad de Control ordena escribir en la pila (como en las interrupciones por software) el IP y CS de

la próxima instrucción a ejecutar del proceso interrumpido (direccion de retorno) y el valor de los flags

(RE).

7) La Unidad de Control direcciona la primera instrucción de la subrutina que atiende a la interrupcion,

las primeras instrucciones de la subrutinas ordenan apilar contenidos de los registros mientras que las

ultimas ordenan desafilarlos.

8) se ejecuta la ultima instrucción (IRET) de la pila de la Unidad de Control, desafila el valor del registro

RE del proceso interrumpido y luego el IP y CS de la direccion de retorno y se reanuda la ejecución del

proceso interrumpido.

La interrupcion tratada es enmascarable porque según el valor del flag i, a la interrupcion se le acepta la

petición de interrumpir el programa en ejecución para llamar a una subrutina del sistema operativo. Una

interrupcion enmascarable es aquella a la cual según el valor del flag i se le puede conceder la solicitud

de interrupcion o no. El flag i se establece por software y la interrupcion no puede ocurrir si tiene una

instrucción CLI (que hace i=0) y al terminar debe hacer i=1 mediante la instrucción STI (que hace i=1).

Las interrupciones por hardware no enmascarables son por medio de una linea NMI, una interrupcion no

puede ser enmascarada por el flag i, ocurre sin importar si el proceso en ejecución se puede interrumpir,

por ejemplo cuando la fuente de alimentación deja de producir tension.

Las interrupciones son tratadas por el sistema opearativo a traves de llamadas al sistema porque, por

medio de las llamadas al sistema provee mencanismos para que un proceso pueda realizar una llamada a

subrutinas del sistema operativo que brindan determinados servicios.

Si se produce una interrupcion, el procecsador lleva a cabo un cambio de contexto y pasa el control al

sistema operativo que debe contar con una rutina de tratamiento de interrupciones, que suele ser un

programa corto que determina la naturaleza de la interrupcion y realiza las acciones que sean necesarias

Resumen de sistemas operativos Página 9 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

para saber cual es la rutina que atiende a la interrupcion. Luego de atenderse la interrupcion y ejecutar

las rutinas necesarias, se invoca al planificador a corto plazo del sistema operativo para que seleccione

un proceso para su ejecucion. En caso de que ocurra un error en el tratamiento de una excepcion, un

gestor de interrupciones detecta el error en la comprobación de condiciones de error y la rutina de

tratamiento de interrupciones puede enviar una señal al proceso que solicito originalmente la operación

de e/s.

usualmente los programas utilizan llamdas a biblioteca para realiar llamadas al sistema, estas rutinas de

biblioteca comprueban los argumentos proporcionados por la aplicacion, construyen una estructura de

datos para entregar esos argumentos al kernel y luego ejecutan una instruccion especial llamada

interrupcion software que tiene un operando que identifica el servicio del kernel adecuado. Cuando el

proceso ejecuta la interrupcion por sw, el hw de interrupcion guarda el estado del codigo de usuario,

conmuta a modo supervisor y realiza el despacho a la rutina del kernel que implementa el servicio

solicitado. La interrupcion software tiene una prioridad de interrupcion relativamente baja comparada a

las interrupciones por hardware.

8 . ¿En qué consiste una llamada al SO y cómo se ejecuta? Interfaces de llamadas de usuario, etc.

Una llamada al sistema es el mecanismo usado por un programa para solicitar un servicio al sistema

operativo, aunque para ejecutar la llamada al sistema, el proceso de usuario debe ejecutarse en modo

privilegiado. Las llamadas al sistema operativo proporcionan una interface entre la aplicación que se está

ejecutando y los servicios que brinda el sistema operativo.

En los sistemas operativos multitarea, puede haber varios procesos ejecutándose concurrentemente, el

acceso a los recursos debe ser administrado por el sistema operativo para garantizar su correcto uso y

evitar problemas de seguridad. Por eso mismo la única forma de acceder al hardware es a través de las

llamadas al sistema, que están perfectamente definidas. Las llamadas al sistema pueden agruparse en

control de procesos, manipulación de archivos, manipulación de dispositivos, mantenimiento de la

información y comunicaciones y todas aquellas tareas que pertenecen a los servicios que el sistema

operativo presenta.

Para ejecutar los servicios del sistema operativo (llamadas al sistema) 2

Los servicios se solicitan guardando los parametros en lugares bien definidos (registros o pilas).

Se ejecuta una instruccion especial de trampa: Llamada al nucleo o llamada al supervisor.3

o La instruccion de la llamada al supervisor cambia la maquina de modo usuario a modo

privilegiado o modo supervisor o modo nucleo.

o La instrucción de la llamada al supervisor le transfiere el control al sistema operativo para

que lleve a cabo uno de sus servicios.

El sistema operativo examina los parámetros de la llamada para determinar cuál de ellas se desea

realizar.

El sistema operativo analiza una tabla que contiene en la entrada "k" un apuntador al procedimiento

que realiza la "k-esima" llamada al sistema: Identifica al procedimiento de servicio llamado.

La llamada al sistema termina y el control reegresa al programa de usuario.

Las Llamadas al supervisor hacen el trabajo más importante en una llamada al sistema: Invocar o comunicarse con el

sistema operativo para solicitarle uno de sus servicios y cambiar el modo de ejecución de modo usuario a modo

privilegiado o núcleo.

Una llamada al supervisor es generalmente una instruccion especializada del hardware dedicada a invocar el sistema

operativo, toda implementacion de esta instruccion tiene al menos un operando que es la identidad del servicio del

sistema operativo que se solicita. La llamada al administrador siempre provee un punto de entrada al sistema

operativo y el servicio solicitado puede ser invocado por medio de un salto a una posicion de memoria del sistema

operativo o por medio de una tabla de indices.

2

Según el libro Sistemas Operativos de David Luis

3

David Luis define las Llamadas al Administrador como interrupciones especiales de trampa porque no se pueden enmascarar

(interrupción por hardware).

Resumen de sistemas operativos Página 10 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Debido a que la instruccion SVC siempre le transfiere el control al supervisor (kernel), la instruccion SVC puede

cambiar el modo de ejecucion a modo privilegiado, en ese momento, un cambio de contexto tambien puede ocurrir

si es necesario o cuya orden de hacer el cambio de contexto se encuentre en el codigo de la instruccion SVC.

Cuando un proceeso hace una llamada al sistema, se salva el contexto del procesador para este proceso para que

con la llamada al administrador el modo de ejecucion pase al modo nucleo. El sistema operativo tiene su propia

region de memoria y su propia pila del sistema oara controlar las llamadas y retornos de procedimientos. El sistema

operativo puede llevar a cabo cualquier funcion deseada y luego restaurar el contexto del proceso interrumpido para

reanudarlo.

Algunos ejemplos de llamadas al sistema pueden ser la solicitud de los siguientes servicios:

Control de procesos:

Terminarlos, abortarlos

Cargarlos, ejecutarlos

Crearlos, terminarlos

Obtener atributos del proceso, definir atributos del proceso

Esperar suceso, señalar suceso

Asignar y liberar memoria.

Administración de archivos:

Crearlos, borrarlos.

Abrirlos, cerrarlos

Leerlos, escribirlos, reposicionarlos.

Obtener atributos del archivo, definir atributos del archivo.

Administración de dispositivos:

Crearlos, borrarlos, liberarlos.

Obtener atributos del dispositivo, definir atributos del dispositivo

Conectarlos, desconectarlos lógicamente.

Mantenimiento de información:

Crearlos, borrarlos, liberarlos.

9 . ¿Qué entiende por normas POSIX?

POSIX es un tipo de API que se utiliza en Linux y Mac OS X, una API es el conjunto de funciones y

procedimientos (o métodos, si se refiere a programación orientada a objetos) que ofrece cierta biblioteca

para ser utilizado por otro software como una capa de abstracción, esto facilita el desarrollo de

aplicaciones multiplataforma. Una API representa una interfaz de comunicación entre componentes

software. Se trata del conjunto de llamadas a ciertas bibliotecas que ofrecen acceso a ciertos servicios

desde los procesos y representa un método para conseguir abstracción en la programación,

generalmente (aunque no necesariamente) entre los niveles o capas inferiores y los superiores del

software. Uno de los principales propósitos de una API consiste en proporcionar un conjunto de

funciones de uso general, por ejemplo, para dibujar ventanas o iconos en la pantalla. De esta forma, los

programadores se benefician de las ventajas de la API haciendo uso de su funcionalidad, evitándose el

trabajo de programar todo desde el principio.

System V tambien es un tipo de Api y se utiliza en UNIX, se diferencia con POSIX en la forma de

implementar la sincronizacion entre procesos, en POSIX los semáforos pueden incrementarse o

decrementarse en 1, mientras que en System V los puede incrementa o diminuye a una cantidad

numerica mayor a 1 y POSIX no permite manipular los permisos de los semáforos.

1 0 . Protecciones en un SO.

Para el correcto funcionamiento de un sistema operativo se requieren medidas de proteccion y seguridad.

Resumen de sistemas operativos Página 11 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Seguridad: Un Sistema Operativo debe ofrecer mecanismos de seguridad para controlar el acceso de

los programas, procesos o usuarios a los recursos definidos por el sistema de computación, estos

mecanismos permiten especificar los controles que se aplicarán y que se deben cumplir.

Proteccion: El sistema operativo debe proveer mecanismos de protección para evitar que un proceso

intervenga en otros, protección de CPU para evitar que un proceso malicioso se acapare de la CPU,

protección de memoria para evitar que las aplicaciones no accedan o modifiquen lo que se encuentra en

el segmento donde esta almacenado el sistema operativo.

Por ejemplo en UNIX Todo archivo está controlado por múltiples niveles de protección, que especifican

los permisos de acceso al mismo.

UNIDAD 3

1 .Definir el concepto de proceso.

Un proceso es un programa de ejecución cargado en memoria principal, que necesita recursos como por

ejemplo tiempo del CPU, archivos y dispositivos de entrada y salida para realizar su tarea. Es una unidad

de trabajo en un sistema.

Proceso monohilo: Proceso que tiene un contador de programa que especifica cual es la siguiente

instrucción a ejecutar, las instrucciones de un proceso se ejecutan secuencialmente, una después de otra,

hasta completar la ejecución del proceso.

Proceso multihilo: Proceso que tiene muchos contadores de programa, apuntando cada uno de ellos a

la siguiente instrucción que haya que ejecutar para una hebra determinada.

Por el tipo de instrucciones que ejecutan, podemos diferenciar a los procesos en dos grupos:

Proceso del Sistema Operativo: Ejecuta codigo de un proceso que forma parte del sistema operativo.

Procecsos de ususario: Es un proceso creado por el sistema operativo como respuesta a una ejecución

que orenó el usuario, los procesos de usuario ejecutan codigo de las aplicaciones de usuario.

Cuando un sistema operativo ejecuta un programa, se carga el código ejecutable en una zona libre de

memoria y el sistema operativo reserva para ese proceso un espacio en el que almacenará las siguientes

partes del proceso que se ejecutará:

Como se puede ver un proceso no es un simple programa cargado en memoria, un programa no es un

proceso, un programa es una entidad pasiva, mientras que un proceso es activo y dinamico al poder

ejecutarse, poseer atributos que cambian y cuyo estado puede cambiar (nuevo, en ejecución, bloqueado,

etc).

Resumen de sistemas operativos Página 12 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

2 . Concepto de bloque de control de proceso.

El Bloque de Control de Proceso es una estructura de datos con campos para registrar información acerca

de un proceso que el Sistema Operativo necesita acerca de un proceso particular para poder conocer el

proceso y para administrar su procesamiento (por ejemplo poder asignarle recursos). Cada vez que se

crea un proceso, el sistema operativo crea el bloque de control de proceso correspondiente para que

sirva como descripción en tiempo de ejecución durante toda la vida del proceso. Este registro contiene

los siguientes elementos básicos:

Identificador del proceso.

Identificador del proceso (PID) Consiste en un número entero asignado por el sistema, tal numero debe

ser unico para poder identificar al proceso.

El identificador del proceso que lo creó (proceso padre).

La identificación del usuario.

Información del estado del microprocesador.

Registros del procesador: Cuáles son los registros quee utilizan para los datos de entrada, calculos o

resultados.

Contador de programa: Indica cual es la proxima direccion a ejecutar.

Registros de control y estado: Cuáles son aquellos registros entre los cuales se encuentran el contador

de programa, los registros con iniciadores de habilitacion o inhabilitación de interrupciones y el modo de

ejecución (modo usuario o modo kernel).

Puntero a la pila del proceso: Hace referencia a las posiciones de la pila del proceso (Snack) que

almacena parámetros y direcciones de retorno.

Información de planificacion y estado: Esta información es necesaria para que el sistema operativo

lleve a cabo sus funciones de planificacion. Los elementos típicos de esta información son los siguientes.

Estado del proceso: Pueden ser estado de ejecución, preparado, etc.

Prioridad de planificación: Se utiliazan algoritmos de planificación que usarán esta planificación.

Información para la planificación: Información que depende del algoritmo de planificación utilizado.

Suceso por el que se encuentre esperando el suceso para reanudar su ejecución.

Información de gestion y control.

Estructuracion de datos: Puede contener un puntero a otro proceso con la finalidad de formar una cola

de procesos u otra estructura de datos en la que se encuentran Bloques de Control de Procesos que

estan en un mismo estado y se encuentran enlazados según el nivel de prioridad de cada uno de ellos

(cola de procesos listos, cola de procesos bloqueados, etc).

Comunicación del proceso: Figuran indicadores, señales y mensajes asociados con la comunicación

entre dos procesos.

Privilegios del proceso: Figuran aquellos privilegios que puede tener un proceso, esos privilegios

pueden consistir en poder acceder a determinadas zonas de memoria, los tipos de instrucciones que

pueden ejecutar, los servicios que puede usar y las utilidades del sistema que puede solicitar.

Gestion de memoria: Incluye punteros a la tabla de pagina y/o segmentos que describen la memoria

asignada al proceso.

Recursos asignados al proceso: Figuran cuáles son los procesos que están siendo asignados al proceso

como por ejemplo los archivos que abre, si está usando la CPU o un dispositivo de E/S. En algunos

sistemas operativos, en los Bloques de Control de Proceso se almacenan historicos donde figura cada

recurso que ocupo el proceso.

3 . Cambio contexto. Cambio de modo.

Cambio de modo es cuando el proceso cambia de modo (de nuevo a listo, de listo a ejecutando, de

ejecutando a bloqueado E/S, etc.).

Resumen de sistemas operativos Página 13 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Cambio de contexto consiste en la ejecución de una rutina del kernel cuyo proposito es el de detener un

proceso (o hilo) en ejecución para enviar a ejecutar otro proceso, la rutina de cambio de contexto trata

una interrupción por hardware ya que un proceso no ordenara dejar de ejecutarse voluntariamente, sino

que, en realidad lo que se quiere es que el proceso sea despojado por motivos ajenos a ese proceso en

particular. Debido a que las interrupciones hacen que el sistema operativo obligue a la cpu a abandonar

su tarea actual, cuando se produce la interrupción, el sistema tiene que suspender el proceso que se

ejecuta actualmente y después reanudarlo, el sistema operativo entonces ejecuta inmediatamente la

rutina de cambio de contexto que consiste en guardar el contexto actual del proceso que se está

ejecutando en la cpu, de modo que pueda restaurar dicho contexto luego de que concluya la ejecución

del proceso por el que fue despojado.

El contexto se almacena en el Bloque de Control de Proceso e incluye:

Los registros del microprocesador que necesita el proceso para ejecutarse correctamente.

Estado del proceso (nuevo, listo, ejecutando, bloqueado, etc).

Información de gestion de memoria.

La información de la pila.

Cuando se reanuda la ejecución de ese proceso, se toma el estado previamente copiado en la memoria

principal, se carga los registros al procesador y se ejecuta la instrucción que estaba pendiente de

ejecutar en el programa previamente despojado (eso tambien figura en el Bloque de Control de Proceso

ya que tambien almacena el contador de programa).

Cuando ocurre un cambio de contexto, el proceso que se encuentra en estado de ejecución es cambiado

a estado listo, pero si no hay mas memoria principal suficiente para albergar al proceso, pasa a estado

de suspendido al ser almacenado en la memoria secundaria por falta de espacio. El tiempo dedicado al

cambio de contexto es tiempo desperdiciado dado que el sistema no realiza ningun trabajo util durante

la conmutación.

4 . Estados activo de un proceso.

En nivel de multiprogramacion, es el proceso cuyo Bloque de Control de Proceso se encuentra en cola de

listo o ejecución:

Se encuentra en la cola de procecsos listos: El proceso se encuentra en la memoria RAM, sólo le falta la

CPU para seguir ejecutándose.

Se encuentra en la cola de procesos en ejecución: Cuando la CPU esta disponible, el proceso la ocupa.

5 . Transiciones de estado.

Modelo de transición de estados:

Resumen de sistemas operativos Página 14 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Nulo Nuevo: Se crea un nuevo proceso para ejecutar un programa.

Nuevo Listo: Cuando el sistema operativo está preparado para recibir un proceso mas, pasara un

proceso de estado Nuevo a estado Listo.

Listo Ejecución: Cuando es momento de enviar a ejecutar un proceso listo, el sistema operativo hace

que un proceso pase de estado listo a ejecución según el criterio de planificación de procesos que tenga.

Ejecución Terminado: El proceso que se está ejecutando es finalizado por el sistema operativo

cuando haya terminado de ejecutarse.

Ejecución Listo: El proceso que está en ejecución ha alcanzado el tiempo maximo permitido de

ejecución ininterrumpida, si el sistema operativo le asigna diferentes niveles de prioridad a los diferentes

procesos, entonces puede darse el caso de que el proceso que se ejecuta tenga menor prioridad que un

proceso en la cola de procesos listos y por ese motivo debe dejar de ejecutarse para que se ejecute el

proceso con mayor prioridad, tambien puede suceder que un proceso deje de ejecutarse voluntariamente.

Ejecución Bloqueado: Un proceso obtiene el estado de bloqueado si realiza una llamada al sistema

solicitando algo por lo que tiene que esperar (un suceso, un dispositivo de e/s, un recurso, que un

proceso termine de ejecutarse o le de una entrada, etc).

Bloqueado Listo: Se produce el suceso que el proceso bloqueado estaba esperando y se le concede

la cpu para que siga ejecutandose.

Listo Terminado: En algunos sistemas un proceso padre puede terminar con un proceso hijo en

cualquier momento, tambien puede ocurrir que el proceso padre se termine, de tal manera que sus

procesos hijos puedan ser terminados tambien.

Bloqueado Terminado: Según William Stallings esto tambien sucede cuando el proceso padre finaliza

al proceso hijo. Cuando se produce un suceso, todos los procesos que estaban en la cola de espera a

que ese suceso ocurra pueden pasar a estado listo o terminado (para un uso mas eficiente del sistema,

se implementa una cola de espera de suceso por cada suceso por el que los procesos puedan esperar).

Bloqueado Bloqueado y suspendido: Si no hay procesos listos por falta de espacio en memoria

principal, un proceso bloqueado puede ser suspendido para que uno o varios procesos puedan pasar al

estado de proceso listo con el objetivo de dejar que otros procesos puedan ejecutarse y asi mantener un

rendimiento adecuado.

Bloqueado y suspendido Listo y suspendido: Ocurre el suceso por el cual ha estado esperando el

proceso suspendido, para que el proceso bloqueado y suspendido pase al estado listo y suspendido el

sistema operativo debe tener acceso a la información acerca de ese proceso.

Bloqueado y suspendido Bloqueado: Esta transición ocurre si un proceso bloqueado y suspendido

posee una prioridad mayor a cualquier otro proceso, de esta menera se supone que el suceso por el que

esta esperando el proceso bloqueado y suspendido ocurra pronto.

Listo y suspendido Listo: Cuando no hay procesos listos, el sistema operativo debe traer un proceso

para que se ejecute, incluso traer aquellos procesos que han sido despojados de la memoria principal

Resumen de sistemas operativos Página 15 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

por falta de espacio. Puede ocurrir también que aunque hayan procesos listos hay un proceso listo que

tenga mas prioridad que ellos y tenga que ejecutarse primero.

Listo Listo y suspendido: Suele suceder menos veces que Bloqueado Bloqueado y suspendido

porque un proceso que está listo puede ejecutarse en cualquier momento, en cambio un proceso

bloqueado ocupa espacio en la memoria principal y no se puede ejecutar, por ese motivo es mas

frecuente esta ultima transición. De todas maneras puede suspenderse un proceso listo si este ocupa

mucha memoria principal o tiene menor prioridad que el resto de los procesos bloqueados y listos.

Nuevo Listo y suspendido, Nuevo Listo: Cuando se crea un nuevo proceso se lo puede agregar a

la cola de procesos listos o la cola de procecsos listos y suspendidos, en aquel momento el sistema

operativo crea el Bloque de Control de Proceso y le asigna el espacio de direcciones que corresponda, en

caso de no hubiese espacio para un nuevo proceso en memoria principal, aun asi el sistema operativo

puede crear el proceso y enviarlo a la cola de procesos listos y suspendidos.

Varios Terminado: Normalmente los procesos terminan cuando se están ejecutando ya sea porque

su ejecución se completo, por alguna terminacion erronea, por haber finalizado el proceso que lo creó o

por finalizar cuando el proceso padre finalizó.

6 . Operaciones sobre un proceso.

Los sistemas que administran procesos deben ser capaces de realizar ciertas operaciones sobre y con los

procesos. Tales operaciones incluyen:

Crearlos y terminarlos

Suspenderlos y reanudarlos

Proporcionar mecanismos para que se comuniquen.

Sincronizarlos

Cambiarles la prioridad

Bloquear y desbloquearlos

Planificar un proceso (asignarle la cpu)

Tratar interbloqueos.

1) Creación de procesos:

En terminos de ejecución, existen dos posibilidades cuando un proceso padre crea un proceso hijo:

Luego de que se creó el proceso hijo, tanto el proceso padre como su hijo se ejecutan

concurrentemente.

El padre termina hasta que uno de sus hijos termine.

Con respecto a los recursos cuando un proceso padre crea a un proceso hijo:

El proceso hijo obtiene recursos directamente del sistema operativo.

Los recursos recibe el proceso hijo está restringido a un subconjunto de los recursos del proceso padre.

Existen dos posibilidades en funcion del espacio de direcciones del proceso hijo:

El proceso hijo es un duplicado del proceso padre (usa el mismo programa y los mismos datos que el

padre).

El proceso hijo carga un nuevo programa.

En un sistema operativo que deriva de UNIX, un proceso puede crear otros procesos nuevos cuando se

ejecuta una llamada al sistema especifica para la creación de procesos. Los procesos se identifican por

un PID (Identificador de proceso).

Resumen de sistemas operativos Página 16 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

El proceso padre al realizar una llamada al sistema Fork( ), solicita clonarse en el espacio de memoria

que ocupará su proceso hijo. El proceso padre Bash solicita clonarse en su hijo y lo define como Ls, de

esta menra el proceso padre puede comunicarse fácilmente con su proceso hijo. Luego, uno de los dos

proceesos utiliza la llamada al sistema Exec( ) con el fin de sustituir el espacio de memoria del clon del

proceso padre por el codigo del proceso hijo, el proceso padre puede realizar la llamada al sistema

Wait( ) para sincronizarse con su hijo para esperar que su proceso hijo termine.

Si el proceso padre no tiene nada que hacer mientras se ejecuta el hijo (no tiene que crear mas hijos,

tampoco tiene que ejecutar), entonces realiza la llamada al sistema Wait( ) para auto-excluirse de la cola

de procesos listos hasta esperar que su hijo termine. La llamada al sistema Exit ( ) la realiza el proceso

hijo cuando termina su ejecución o si se ejecutó la ultima instrucción para que el sistema operativo lo

termine, la llamada al sistema Exit( ) le dice al Wait( ) del proceso padre que la ejecución de su proceso

hijo ha terminado.

Para la creación de procesos, en un sistema operativo Windows, los procesos se crean en la API de Win32

mediante una funcion CreateProcess( ) que es similar a Fork( ) pero con la diferencia de que el hijo no

hereda el espacio de direcciones de su padre sino que requiere cargar un programa especifico en el

espacio de direcciones del proceso hijo durante su creación.

2) Terminacion de procesos:

Un proceso finaliza cuando termina de ejecutar su ultima instrucción y pide al sistema operativo que lo

termine usando la llamada al sistema Exit( ), en ese momento el proceso puede enviarle su bit de estado

al proceso padre a traves de la llamada al sistema Wait( ), luego el sistema operativo libera todos los

recursos que ocupaba el proceso (incluyendo memoria fisica, virtual, archivos abiertos, buffers e/s, etc).

Un proceso padre puede terminar con la ejecución de sus hijos por las siguientes razones:

El proceso hijo ha excedido el uso de algunos recursos que se le han asignado, para determinar si eso

ha ocurrido, el proceso padre debe disponer de mecanismos que le permitan inspeccionar el estado de

sus procesos hijos.

La tarea asignada al proceso hijo ya no es necesaria.

Si su proceso padre deja de existir y el sistema operativo no permite que el proceso hijo se siga

ejecutando cuando su padre ya terminó entonces cuando el padre abandona el sistema el hijo tambien.

Resumen de sistemas operativos Página 17 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

En un sistema UNIX todas las cosas que han sido mencionadas son validas con la caracteristica adicional

que si un proceso padre ha terminado, a todos sus procesos hijos se le asigna el proceso init como su

nuevo padre, de manera que los procesos hijo todavía tengan un padre a quien proporcionarle su estado

y estadisticas de ejecución.

3) Proporcionar mecanismos para que se comuniquen.

Los procesos que se ejecutan concurrentemente pueden ser procesos independientes o procesos

cooperativos:

Proceso independiente: No comparte datos con otros procesos o no puede afectar o ser afectado por

los restantes procesos que se ejecutan en el sistema.

Proceso cooperativo: Puede afectar y ser afectado por los demas procesos que se ejecutan tambien

puede compartir datos con otros procesos.

Las razones por las cuales el sistema operativo debe proporcionar mecanismos para que los procesos se

puedan comunicar son las siguientes:

Compartir información: Si varios usuarios están interesados en la misma información (por ejemplo un

archivo compartido), entonces el sistema operativo debe proporcionar un entorno que permita el acceso

concurrente a dicha información.

Acelerar calculos: En caso de que el sistema sea compatible con multiprocesamiento o posea varios

canales de e/s, si queremos que una tarea se ejecute mas rapido, deberiamos dividirla en subtareas con

tal de que cada una de ellas pueda ejecutarse en paralelo con las demas.

Modularidad: En un sistema operativo con arquitectura jerarquica o en cualquier otra forma de

implementacion en la que el sistema operativo se construya de forma modular, existen modulos que se

comunican entre sí, cada modulo contiene funcionalidades del sistema divididos en hilos y procesos que

deben comunicarse entre si.

Convivencia: Un solo usuario puede trabajar en muchas tareas al mismo tiempo (por ejemplo un

usuario puede estar editando, imprimiendo y compilando en paralelo):

Para que los procesos puedan intercambiar datos e información entre si, el sistema operativo debe

contar con mecanismos de comunicación interprocesos cuyos modelos fundamentales son:

Memoria compartida: Se establece una región de la memoria para que sea los procesos cooperativos

puedan intercambiar información escribiendo o leyendo datos en dicha region compartida. La memoria

compartida permite una velocidad maxima y una mejor comunicación ya que si

los procesos se encuentran en una misma maquina, la comunicación puede

realizarse a velocidades de memoria, esto requiere de llamadas al sistema pero

son pocas ya que son necesarias solo para establecer zonas de memoria

compartida.

Debido a que una region de memoria compartida reside en el espacio de

direcciones del proceso que crea el segmento de memoria compartida, la region

de memoria para que dos procesos puedan comunicarse es creada por uno de

esos dos procesos, que ademas de crearla, define el formato de los datos, su

ubicación y los procesos son responsables de verificar que no escriben en la

misma posición simultáneamente (en estas actividades no interviene el control del

sistema operativo), cualquier otro proceso que desee comunicarse usando este

segmento de memoria, deben conectarse a su espacio de direcciones. Para que

esto suceda, uno o mas procesos deben violar la restricción que existen en los

sistemas operativos de que un proceso no puede acceder a la memoria de otro

proceso.

Dentro del concepto de memoria compartida se distinguen procesos productivos y procesos

consumidores, donde el proceso productor genera información que consume el proceso consumidor (por

ejemplo un compilador genera codigo ensamblado para que el ensamblador lo consuma), esto se

relaciona mucho con el paradigma del cliente y el servidor, por ejemplo un servidor web proporciona

codigo html e imágenes y un explorador web cliente le solicita recursos.

Resumen de sistemas operativos Página 18 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Para permitir que un proceso consumidor y productor se ejecuten de forma concurrente, debemos tener

disponible un buffer que pueda rellenar el productor al escribir y vaciar el consumidor al ir leyendo lo

que escribió el productor, considerando todo lo comentado hasta ahora, es evidente que dicho buffer se

encuentra en la zona de memoria compartida. Pueden implementarse dos tipos de buffers, el buffer no

limitado no pone limites al tamaño de esa memoria compartida, el consumidor puede tener que esperar

para obtener elementos nuevos, pero el productor puede generar nuevos elementos, el buffer limitado

establece un tamaño de bufer fijo, en este caso, el consumidor debe esperar si el buffer está vacio y el

productor tiene que esperar a que el consumidor lo vacie si el buffer está lleno.

Paso de mensajes: El sistema operativo proporciona medios por los cuales los procesos cooperativos

puedan comunicarse entre si a traves de envíos de mensajes. Es util para

intercambiar pequeñas cantidades de datos ya que no existe la posibilidad de que

se genere conflictos, al ser mas simple es mas facil de implementar que el modelo

de memoria compartida, el paso de mensaje se implementa mediante llamadas al

sistema , por lo tanto requiere mas intervención del kernel y mas tiempo.

Un mensaje puede contener datos, ordenes de ejecucion, ncluso codigo a

transmitir entre dos o mas procesos. Aunque, en general, el contenido de un

mensaje quedara

dividido en dos campos bien separados, por un lado, la cabecera (que

habitualmente tiene un formato fijo para cada sistema operativo) y el cuerpo del

mensaje (que contiene el mensaje en sı y cuya longitud puede variar incluso

dentro de un mismo sistema operativo).

El modelo de paso de mensajes se utilizan en sistemas distribuidos debido a que

los procesos que se comunican no se encuentran en una misma computadora, por

lo tanto no comparten el mismo espacio de direcciones para que los procesos se comuniquen y

sincronicen sus acciones.

Para que dos procesos puedan comunicarse entre si debe existir un medio por el cual puedan

reverenciarse entre si, debe existir un enlace de comunicaciones entre ellos, los metodos para

implementar lógicamente un enlace y las operaciones de envio y recepcion son las siguientes:

Comunicación directa o indirecta, comunicación sincronica o asincronica y almacenamiento en buffer

explicito o automatico. En caso de una comunicación directa, cada proceso transmisor o receptor que

desea establecer una comunicación debe nombrar de forma explicita al receptor o transmisor de la

comunicación por ejemplo, donde el mensaje Send (P, mensaje) envia un mensaje al proceso P , mientras

que el mensaje Recibe (Q, mensaje) recibe un mensaje del proceso P.

Un enlace de comunicaciones, según el sistema se puede asociar con exactamente dos procesos o que

entre cada par de procesos exista un enlace o se establecen de forma automatica entre cada par de

procesos que quieran comunicarse. Los procesos solo tienen que conocer la identidad del otro para

comunicarse.

Cuando un intercambio de mensajes es sıncrono, tanto el emisor como el receptor deben proceder

juntos para completar la transferencia. En sistemas sıncronos la operacion de envıo es bloqueante, es

decir, cuando un proceso emisor desea enviar un mensaje para el que no se ha emitido el

correspondiente receive() por parte del proceso receptor. El emisor que dara bloqueado hasta que el

receptor acepte el mensaje. Como consecuencia solo puede haber un mensaje pendiente como m aximo

por cada emisor/receptor.

En el intercambio asıncrono de mensajes, el emisor no queda bloqueado cuando no hay un receive( )

pendiente. El envıo en un sistema asıncrono se implementa haciendo que el SO almacene temporalmente

los mensajes pendientes hasta que se emita el correspondiente receive( ). Como resultado, el proceso

emisor puede continuar su ejecucion despues de enviar un mensaje y no necesita quedar bloqueado.

En modelo de paso de mensajes, los mensajes pueden ser de tamaño fijo o variable.

3) Sincronizacion de procesos

Resumen de sistemas operativos Página 19 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

La sincronizacion entre procesos tiene lugar a traves de las llamadas a las primitivas Send( ) y Recieve( ),

el paso de mensajes entre procesos puede ser:

Envio con bloqueo (sincronico): El proceso se bloquea hasta que el proceso receptor o el buzon de

correo reciben el mensaje.

Envio sin bloqueo (asincrono): El proceso transmisor envia el mensaje y continua operando.

Recepcion con bloqueo (sincronica): El receptor se bloquea hasta que hay un mensaje disponible.

Recepcion sin bloqueo (asincrono): El receptor extrae un mensaje valido o un mensaje nulo.

Si los mensajes intercambiados por los procesos que se están comunicando residen en una cola

temporal. Básicamente, tales colas se pueden implementar de tres maneras:

Cola con capacidad cero: La cola tiene una longitud maxima de 0, no puede haber ningun mensaje

esperando en el enlace, por eso en este caso el transmisor debe bloquearse hasta que el receptor reciba

el mensaje.

Capacidad limitada: La cola tiene una longitud definida, por lo tanto puede haber en ella una cantidad

limitada de mensajes como maximo. Si la cola no se llena cuando se envia un mensaje, el mensaje se

introduce en la cola (se copia el mensaje o se almacena un puntero al mismo), y el transmisor puede

continuar la ejecución sin esperar. Si el enlace esta lleno, el transmisor debe bloquearse hasta que haya

espacio disponible en la cola.

Capacidad ilimitada: La capacidad de la cola no tiene limites, por lo tanto puede haber cualquier

cantidad de mensajes esperando en ella y el proceso transmisor nunca se bloquea.

7 . Interrupciones, excepciones, llamados al supervisor.

Un cambio de proceso puede producirse en cualquier momento en que el sistema operativo haya

cambiado el control a partir del proceso que esta actualmente ejecutandose. Interrupciones o llamadas al

supervisor pueden ser causas por las cuales se cambie un proceso en ejecucion por otro.

Interrupciones: Stallings diferencia dos tipos de interrupciones basicas, las interrupciones ordinarias,

traps y las excepciones.

o Interrupcion: Es originada por un suceso externo asincrono (independiente al proceso que

está ejecutandose) como por ejemplo, se pulsó una tecla, se terminó de realizar una

operacion de e/s. En una interrupcion ordinaria, el control se transfiere primero a un

gestor de interrupciones, quien lleva a cabo las tareas basicas y luego se salta a una rutina

del sistema operativo que se ocupa de la interrupcion para determinar la naturaleza de la

interrupcion para luego definir que subrutina del sistema operativo la atiende.

o Trap: Es originado por un suceso interno, por lo tanto es sincrono (se produce porque el

codigo del programa que se ejecuta presenta una instrucción que solicita un servicio del

sistema operativo). Son las interrupciones por software que hemos estado viendo.

o Excepcion: Las excepciones tienen que ver con una condicion de error o de una condicion

no deseada generada dentro del proceso que está ejecutandose, como por ejemplo, un

intento ilegal de acceso a un archivo, una division por 0, un bucle infinito que busca

acapararse de la CPU. En las excepciones, el sistema operativo determina si el error es

fatal. Si lo es, el proceso que se estaba ejecutando pasa al estado de terminado y se

produce un cambio de proceso, si no es fatal, la accion del sistema operativo dependerá

de la naturaleza del error y del diseño del sistema operativo.

Llamada al supervisor: El sistema operativo es invocado durante una llamada de supervisor ya que

desde el programa llamador se solicitan servicios del sistema operativo. Por ejemplo, un proceso de

usuario se está ejecuntado y se alega a una instruccion que solicita una operacion de e/s, tal como abrir

un archivo. Esta llamada provoca la transferencia a una rutina que forma parte del codigo del sistema

operativo. Por lo general, el uso e una llamada al sistema hace que el proceso de usuario pase al estado

de Bloqueado.

Resumen de sistemas operativos Página 20 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

8 . Conceptos de hilos (threads) funcionalidad, multihilos

Un hilo es una unidad basica de utilización del CPU, es el camino de ejecución en un proceso, aunque al

igual que los procesos, los hilos tambien tienen un estado de ejecución, hilos de un mismo proceso

pueden compartir recursos entre ellos y sincronizarse para que el compartimiento de recursos no genere

problemas entre los hilos, contienen un contador de programa, un conjunto de registros y un espacio de

stack (pila).

Los estados de los hilos pueden ser: Ejecución, listo y bloqueado, no es necesario que exista el estado

suspendido como los que tienen los procesos ya que si un proceso se encuentra en memoria secundaria,

todos sus hilos deberian de estarlo tambien ya que todos comparten el mismo espacio de direcciones.

Refiriendonos a la funcionalidad de un hilo, las operaciones que se realizan con un hilo son las

siguientes:

Creación: Cuando un proceso se crea, un hilo perteneciente a ese proceso es creado. Luego, este hilo

puede crear otros hilos dentro del mismo proceso, proporcionando un puntero de instrucción y los

argumentos del nuevo hilo. El hilo tendrá su propio contexto y su propio espacio de la columna, y pasara

a la final de los listos.

Bloqueo: Cuando un hilo debe esperar por un suceso se bloquea (salvando sus registros de usuario,

contador de programa y punteros de pila). Sin embargo, que un hilo se encuentre bloqueado no quiere

decir que el resto tambien lo esté, por lo tanto el procesador puede pasar a ejecutar otro hilo que se

encuentre en estado listo mientras el anterior se encuentra bloqueado.

Desbloqueo: Cuando el suceso por el que esperaba el hilo se produce, el hilo pasa a estado listo.

Terminacion: Cuando un hilo termina, se libera tanto su contexto como el resto de sus campos.

El uso de hilos comprende muchas ventajas

La ventaja mas evidente que señala Stallings es que la creación de un hilo tarda mucho menos que la

creación de un proceso, por lo tanto tarda menos tiempo en terminarse y tambien menos tiempo para

cambiar entre dos hilos en un mismo proceso.

La comunicación entre hilos es más rapida que la comunicación entre procesos, esto es porque la

comunicación entre procesos independientes requiere la intervención del núcleo para ofrecer proteccion

y para proporcionar los mecanismos necesarios para la comunicación. Sin embargo debido a que los

hilos de un mismo proceso comparten memoria y archivos, pueden comunicarse entre si sin la

intervención del núcleo.

Generalmente, cada hilo tiene una tarea especifica y determinada, como forma de aumentar la eficiencia

del uso del procesador. Al igual que los procesos, los hilos poseen un estado de ejecución y pueden

sincronizarse entre ellos para evitar problemas de compartimiento de recursos ya que cualquier

modificación de un recurso desde un hilo afecta al entorno del resto de los hilos del mismo proceso. Por

lo tanto, es necesario sincronizar la actividad de los distintos hilos para que no interfieran unos con

otros o corrompan estructuras de datos, por eso, es probable que los hilos requieran de operaciones

atómicas para impedir que los datos comunes sean cambiados o leídos mientras estén siendo

modificados, para lo que usualmente se utilizan los semáforos. El descuido de esto puede generar

interbloqueo.

Resumen de sistemas operativos Página 21 de 66

Descargado por Lucas Cardoso (lucas_lp_dxd@hotmail.com)

lOMoARcPSD|3375621

Cristian Reyes – Resumen de sistemas operativos

Se supone que un proceeso es un programa en ejecución con solo un hilo de control, pero en la

actualidad, la mayoria de los sistemas operativos proporcionan caracteristicas que permiten que un

proceso pueda tener multiples hilos:

Proceso tradicional (o proceso pesado): Es un proceso liviano que solo tiene un hilo de control.