Professional Documents

Culture Documents

SVM - 5690-18885-1-PB

Uploaded by

Marco AlmeidaCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

SVM - 5690-18885-1-PB

Uploaded by

Marco AlmeidaCopyright:

Available Formats

Uma Introduo s Support Vector Machines

Ana Carolina Lorena

1

Andr C. P. L. F. de Carvalho

2

Resumo: Neste artigo apresentada uma introduo s Mquinas de Vetores de

Suporte (SVMs, do Ingls Support Vector Machines), tcnica de Aprendizado de

Mquina que vem recebendo crescente ateno nos ltimos anos. As SVMs vm

sendo utilizadas emdiversas tarefas de reconhecimento de padres, obtendo resultados

superiores aos alcanados por outras tcnicas de aprendizado em vrias aplicaes.

Palavras-chave: Aprendizado de Mquina, Classicao, Mquinas de Vetores de

Suporte (Support Vector Machines)

Abstract: This paper presents an introduction to the Support Vector Machines

(SVMs), a Machine Learning technique that has received increasing attention in the

last years. The SVMs have been applied to several pattern recognition tasks, obtaining

results superior to those of other learning techniques in various applications.

Keywords: Machine Learning, Classication, Support Vector Machines

1 Introduo

As Mquinas de Vetores de Suporte (SVMs, do Ingls Support Vector Machines) cons-

tituem uma tcnica de aprendizado que vem recebendo crescente ateno da comunidade de

Aprendizado de Mquina (AM) [27]. Os resultados da aplicao dessa tcnica so com-

parveis e muitas vezes superiores aos obtidos por outros algoritmos de aprendizado, como

as Redes Neurais Articiais (RNAs) [4, 14]. Exemplos de aplicaes de sucesso podem ser

encontrados em diversos domnios, como na categorizao de textos [19], na anlise de ima-

gens [20, 33] e em Bioinformtica [30, 34].

As SVMs so embasadas pela teoria de aprendizado estatstico, desenvolvida por Vap-

nik [41] a partir de estudos iniciados em [43]. Essa teoria estabelece uma srie de princpios

que devem ser seguidos na obteno de classicadores com boa generalizao, denida como

a sua capacidade de prever corretamente a classe de novos dados do mesmo domnio em que

o aprendizado ocorreu.

1

Centro de Matemtica, Computao e Cognio, Universidade Federal do ABC, Rua Catequese, 242, CEP 09090-

400, Santo Andr, SP

ana.lorena@ufabc.edu.br

2

Departamento de Cincias de Computao, Instituto de Cincias Matemticas e de Computao, Universidade de

So Paulo, Caixa Postal 668, CEP 13560-970, So Carlos, SP

andre@icmc.usp.br

Uma Introduo s Support Vector Machines

Iniciando este artigo, na Seo 2 so apresentados alguns conceitos bsicos de AM.

Uma breve introduo aos principais conceitos da teoria de aprendizado estatstico ento

apresentada na Seo 3. A partir deles, na Seo 4 as SVMs so formuladas para a denio

de fronteiras lineares para a separao de conjuntos de dados binrios. A seguir, na Seo 5

as SVMs da Seo 4 so estendidas de forma a denir fronteiras no lineares. Concluindo, na

Seo 6 so apresentadas algumas discusses dos conceitos vistos e as consideraes nais

deste artigo.

2 Conceitos Bsicos de Aprendizado de Mquina

As tcnicas de AM empregam um princpio de inferncia denominado induo, no

qual obtm-se concluses genricas a partir de um conjunto particular de exemplos. O apren-

dizado indutivo pode ser dividido em dois tipos principais: supervisionado e no- supervi-

sionado.

No aprendizado supervisionado tem-se a gura de um professor externo, o qual apre-

senta o conhecimento do ambiente por conjuntos de exemplos na forma: entrada, sada de-

sejada [14]. O algoritmo de AM extrai a representao do conhecimento a partir desses

exemplos. O objetivo que a representao gerada seja capaz de produzir sadas corretas

para novas entradas no apresentadas previamente.

No aprendizado no-supervisionado no h a presena de um professor, ou seja, no

existem exemplos rotulados. O algoritmo de AM aprende a representar (ou agrupar) as en-

tradas submetidas segundo uma medida de qualidade. Essas tcnicas so utilizadas principal-

mente quando o objetivo for encontrar padres ou tendncias que auxiliem no entendimento

dos dados [39].

O tipo de aprendizado abordado neste trabalho o supervisionado. Neste caso, dado

um conjunto de exemplos rotulados na forma (x

i

, y

i

), em que x

i

representa um exemplo

e y

i

denota o seu rtulo, deve-se produzir um classicador, tambm denominado modelo,

preditor ou hiptese, capaz de predizer precisamente o rtulo de novos dados. Esse processo

de induo de um classicador a partir de uma amostra de dados denominado treinamento.

O classicador obtido tambm pode ser visto como uma funo f, a qual recebe um dado x

e fornece uma predio y.

Os rtulos ou classes representam o fenmeno de interesse sobre o qual se deseja

fazer previses. Neste trabalho, considera-se o caso em que os rtulos assumem valores

discretos 1, . . . , k. Tem-se ento um problema de classicao. Caso os rtulos possuam

valores contnuos, tem-se uma regresso [27]. Um problema de classicao no qual k = 2

denominado binrio. Para k > 2, congura-se um problema multiclasses.

Cada exemplo, tambm referenciado por dado ou caso, tipicamente representado

44 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

por um vetor de caractersticas. Cada caracterstica, tambm denominada atributo, expressa

um determinado aspecto do exemplo [29]. Normalmente, h dois tipos bsicos de atributos:

nominal e contnuo. Um atributo denido como nominal (ou categrico) quando no existe

uma ordem entre os valores que ele pode assumir (por exemplo, entre cores). No caso de

atributos contnuos, possvel denir uma ordem linear nos valores assumidos (por exemplo,

entre pesos ).

Um requisito importante para as tcnicas de AM que elas sejam capazes de lidar com

dados imperfeitos, denominados rudos. Muitos conjuntos de dados apresentam esse tipo de

caso, sendo alguns erros comuns a presena de dados com rtulos e/ou atributos incorretos.

A tcnica de AM deve idealmente ser robusta a rudos presentes nos dados, procurando no

xar a obteno dos classicadores sobre esse tipo de caso. Deve-se tambm minimizar

a inuncia de outliers no processo de induo. Os outliers so exemplos muito distintos

dos demais presentes no conjunto de dados. Esses dados podem ser rudos ou casos muito

particulares, raramente presentes no domnio.

Os conceitos referentes gerao de um classicador a partir do aprendizado super-

visionado so representados de forma simplicada na Figura 1. Tem-se nessa gura um

conjunto com n dados. Cada dado x

i

possui m atributos, ou seja, x

i

= (x

i1

, . . . , x

im

). As

variveis y

i

representam as classes. A partir dos exemplos e as suas respectivas classes, o

algoritmo de AM extrai um classicador. Pode-se considerar que o modelo gerado fornece

uma descrio compacta dos dados fornecidos [1].

Figura 1. Induo de classicador em aprendizado supervisionado

A obteno de um classicador por um algoritmo de AM a partir de uma amostra de

dados tambm pode ser considerada um processo de busca [27]. Procura-se, entre todas as

hipteses que o algoritmo capaz de gerar a partir dos dados, aquela com melhor capacidade

de descrever o domnio em que ocorre o aprendizado.

Para estimar a taxa de predies corretas ou incorretas (tambm denominadas taxa de

acerto e taxa de erro, respectivamente) obtidas por um classicador sobre novos dados, o con-

RITA Volume XIV Nmero 2 2007 45

Uma Introduo s Support Vector Machines

junto de exemplos , em geral, dividido em dois subconjuntos disjuntos: de treinamento e de

teste. O subconjunto de treinamento utilizado no aprendizado do conceito e o subconjunto

de teste utilizado para medir o grau de efetividade do conceito aprendido na predio da

classe de novos dados.

Um conceito comumente empregado em AM o de generalizao de um classicador,

denida como a sua capacidade de prever corretamente a classe de novos dados. No caso em

que o modelo se especializa nos dados utilizados em seu treinamento, apresentando uma

baixa taxa de acerto quando confrontado com novos dados, tem-se a ocorrncia de um super-

ajustamento (overtting). tambm possvel induzir hipteses que apresentem uma baixa

taxa de acerto mesmo no subconjunto de treinamento, congurando uma condio de sub-

ajustamento (undertting). Essa situao pode ocorrer, por exemplo, quando os exemplos

de treinamento disponveis so pouco representativos ou quando o modelo obtido muito

simples [29]. Na Seo 3, esses conceitos so ilustrados e discutidos novamente. So feitas

ento consideraes e motivaes sobre a escolha de classicadores com boa capacidade de

generalizao.

3 A Teoria de Aprendizado Estatstico

Seja f umclassicador e F o conjunto de todos os classicadores que umdeterminado

algoritmo de AM pode gerar. Esse algoritmo, durante o processo de aprendizado, utiliza

um conjunto de treinamento T, composto de n pares (x

i

, y

i

), para gerar um classicador

particular

f F.

Considere, por exemplo, o conjunto de treinamento da Figura 2 [38]. O objetivo

do processo de aprendizado encontrar um classicador que separe os dados das classes

crculo e tringulo. As funes ou hipteses consideradas so ilustradas na gura por

meio das bordas, tambm denominadas fronteiras de deciso, traadas entre as classes.

Figura 2. Conjunto de treinamento binrio e trs diferentes hipteses

46 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

Na imagem da Figura 2a, tem-se uma hiptese que classica corretamente todos os

exemplos do conjunto de treinamento, incluindo dois possveis rudos. Por ser muito espec-

ca para o conjunto de treinamento, essa funo apresenta elevada sucetibilidade a cometer

erros quando confrontada com novos dados. Esse caso representa a ocorrncia de um super-

ajustamento do modelo aos dados de treinamento.

Um outro classicador poderia desconsiderar pontos pertencentes a classes opostas

que estejam muito prximos entre si. A ilustrao da Figura 2c representa essa alternativa.

A nova hiptese considerada, porm, comete muitos erros, mesmo para casos que podem ser

considerados simples. Tem-se assim a ocorrncia de um sub-ajustamento, pois o classicador

no capaz de se ajustar mesmo aos exemplos de treinamento.

Um meio termo entre as duas funes descritas representado na Figura 2b. Esse

preditor tem complexidade intermediria e classica corretamente grande parte dos dados,

sem se xar demasiadamente em qualquer ponto individual.

A Teoria de Aprendizado Estatstico (TAE) estabelece condies matemticas que

auxiliam na escolha de um classicador particular

f a partir de um conjunto de dados de

treinamento. Essas condies levam em conta o desempenho do classicador no conjunto

de treinamento e a sua complexidade, com o objetivo de obter um bom desempenho tambm

para novos dados do mesmo domnio.

3.1 Consideraes sobre a Escolha do Classicador

Na aplicao da TAE, assume-se inicialmente que os dados do domnio em que o

aprendizado est ocorrendo so gerados de forma independente e identicamente distribuda

(i.i.d.) de acordo com uma distribuio de probabilidade P(x, y), que descreve a relao

entre os dados e os seus rtulos [5, 38]. O erro (tambm denominado risco) esperado de um

classicador f para dados de teste pode ento ser quanticado pela Equao 1 [28]. O risco

esperado mede ento a capacidade de generalizao de f [31]. Na Equao 1, c(f(x), y)

uma funo de custo relacionando a previso f(x) quando a sada desejada y. Um tipo de

funo de custo comumente empregada em problemas de classicao a 0/1, denida por

c(f(x), y) =

1

2

|y f (x)| [38]. Essa funo retorna o valor 0 se x classicado correta-

mente e 1 caso contrrio.

R(f) =

_

c(f (x) , y)dP (x, y) (1)

Infelizmente, no possvel minimizar o risco esperado apresentado na Equao 1

diretamente, uma vez que em geral a distribuio de probabilidade P(x, y) desconhecida

[28]. Tem-se unicamente a informao dos dados de treinamento, tambm amostrados de

P(x, y). Normalmente utiliza-se o princpio da induo para inferir uma funo

f que mi-

RITA Volume XIV Nmero 2 2007 47

Uma Introduo s Support Vector Machines

nimize o erro sobre esses dados e espera-se que esse procedimento leve tambm a um menor

erro sobre os dados de teste [38]. O risco emprico de f, fornecido pela Equao 2, mede

o desempenho do classicador nos dados de treinamento, por meio da taxa de classicaes

incorretas obtidas em T [28].

R

emp

(f) =

1

n

n

i=1

c(f (x

i

) , y

i

) (2)

Esse processo de induo com base nos dados de treinamento conhecidos constitui o

princpio de minimizao do risco emprico [38]. Assintoticamente, com n , pos-

svel estabelecer condies para o algoritmo de aprendizado que garantam a obteno de

classicadores cujos valores de risco emprico convergem para o risco esperado [28]. Para

conjuntos de dados menores, porm, geralmente no possvel determinar esse tipo de garan-

tia. Embora a minimizao do risco emprico possa levar a um menor risco esperado, nem

sempre isso ocorre. Considere, por exemplo, um classicador que memoriza todos os dados

de treinamento e gera classicaes aleatrias para outros exemplos [37]. Embora seu risco

emprico seja nulo, seu risco esperado 0,5.

A noo expressa nesses argumentos a de que, permitindo que

f seja escolhida a

partir de um conjunto de funes amplo F, sempre possvel encontrar uma f com pequeno

risco emprico. Porm, nesse caso os exemplos de treinamento podem se tornar pouco in-

formativos para a tarefa de aprendizado, pois o classicador induzido pode se super-ajustar

a eles. Deve-se ento restringir a classe de funes da qual

f extrada. Existem diversas

abordagens para tal. A TAE lida com essa questo considerando a complexidade (tambm

referenciada por capacidade) da classe de funes que o algoritmo de aprendizado capaz de

obter [38]. Nessa direo, a TAE prov diversos limites no risco esperado de uma funo de

classicao, os quais podem ser empregados na escolha do classicador. A prxima seo

relaciona alguns dos principais limites sobre os quais as SVMs se baseiam.

3.2 Limites no Risco Esperado

Um limite importante fornecido pela TAE relaciona o risco esperado de uma funo

ao seu risco emprico e a um termo de capacidade. Esse limite, apresentado na Equao 3,

garantido com probabilidade 1 , em que [0, 1] [5].

R(f) R

emp

(f) +

_

h

_

ln

_

2n

/

h

_

+ 1

_

ln

_

/

4

_

n

(3)

Nessa equao, h denota a dimenso Vapnik-Chervonenkis (VC) [41] da classe de

48 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

funes F qual f pertence, n representa a quantidade de exemplos no conjunto de treina-

mento T e a parcela de raiz na soma referenciada como termo de capacidade.

A dimenso VC h mede a capacidade do conjunto de funes F [5]. Quanto maior o

seu valor, mais complexas so as funes de classicao que podem ser induzidas a partir

de F. Dado um problema de classicao binrio, essa dimenso denida como o nmero

mximo de exemplos que podem ser particionados em duas classes pelas funes contidas

em F, para todas as possveis combinaes binrias desses dados.

Para ilustrar esse conceito, considere os trs dados apresentados na Figura 3 [38].

Pode-se vericar que, para qualquer conformao arbitrria dos rtulos crculo e trin-

gulo que esses dados possam assumir, possvel determinar retas capazes de separ-los.

Porm, para os quatro pontos em

2

ilustrados na Figura 4, existem rtulos para os dados

que podem ser separados por uma reta (Figura 4a), mas tambm possvel denir rtulos

tal que uma s reta seja incapaz de realizar a separao em classes (Figura 4b) [14]. Para

uma diviso binria arbitrria desses quatro pontos em

2

, deve-se ento recorrer a funes

de complexidade superior das retas. Essa observao se aplica a quaisquer quatro pontos

no espao bidimensional. Portanto, a dimenso VC do conjunto de funes lineares no es-

pao bidimensional 3, uma vez que existe (pelo menos) uma congurao de trs pontos

nesse espao que pode ser particionada por retas em todas as 2

3

= 8 combinaes binrias

de rtulos.

Figura 3. Separaes de trs dados em

2

por meio de retas

A contribuio principal da Inequao 3 est em armar a importncia de se controlar

a capacidade do conjunto de funes F do qual o classicador extrado. Interpretando-a

em termos prticos, tem-se que o risco esperado pode ser minimizado pela escolha adequada,

RITA Volume XIV Nmero 2 2007 49

Uma Introduo s Support Vector Machines

Figura 4. Separaes de quatro dados em

2

por meio de retas

por parte do algoritmo de aprendizado, de um classicador

f que minimize o risco emprico

e que pertena a uma classe de funes F com baixa dimenso VC h. Com esses objetivos,

deniu-se um princpio de induo denominado minimizao do risco estrutural [42].

Como no limite apresentado o termo de capacidade diz respeito classe de funes F

e o risco emprico refere-se a um classicador particular f, para minimizar ambas as parce-

las divide-se inicialmente F em subconjuntos de funes com dimenso VC crescente [42].

comum referir-se a esse processo como introduzir uma estrutura em F, sendo os subcon-

juntos denidos tambm denominados estruturas [38]. Minimiza-se ento o limite sobre as

estruturas introduzidas.

Considera-se subconjuntos F

i

da seguinte forma: F

0

F

1

. . . F

q

F. Como

cada F

i

maior com o crescimento do ndice i, a capacidade do conjunto de funes que

ele representa tambm maior medida que i cresce, ou seja, h

0

< h

1

< . . . < h

q

< h.

Para um subconjunto particular F

k

, seja

f

k

o classicador com o menor risco emprico.

A medida que k cresce, o risco emprico de

f

k

diminui, uma vez que a complexidade do

conjunto de classicadores maior. Porm, o termo de capacidade aumenta com k. Como

resultado, deve haver um valor timo

k em que se obtm uma soma mnima do risco emprico

e do termo de capacidade, minimizando assim o limite sobre o risco esperado. A escolha da

funo

f

k

constitui o princpio da minimizao do risco estrutural. Os conceitos discutidos

so ilustrados na Figura 5.

Embora o limite representado na Equao 3 tenha sido til na denio do procedi-

mento de minimizao do risco estrutural, na prtica surgem alguns problemas. Em primeiro

lugar, computar a dimenso VC de uma classe de funes geralmente no uma tarefa trivial.

Soma-se a isso o fato de que o valor de h poder ser desconhecido ou innito [28].

Para funes de deciso lineares do tipo f(x) = w x, entretando, existem resultados

50 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

Figura 5. Princpio de minimizao do risco estrutural [38]

alternativos que relacionam o risco esperado ao conceito de margem [37]. A margem de um

exemplo tem relao com sua distncia fronteira de deciso induzida, sendo uma medida

da conana da previso do classicador. Para um problema binrio, em que y

i

{1, +1},

dada uma funo f e um exemplo x

i

, a margem(f(x

i

), y

i

) com que esse dado classicado

por f pode ser calculada pela Equao 4 [37]. Logo, um valor negativo de (x

i

, y

i

) denota

uma classicao incorreta.

(f(x

i

), y

i

) = y

i

f (x

i

) (4)

Para obter a margem geomtrica de um dado x

i

em relao a uma fronteira linear

f(x) = w x+b, a qual mede efetivamente a distncia de x

i

fronteira de deciso, divide-se

o termo direita da Equao 4 pela norma de w, ou seja, por w [38]. Para exemplos incor-

retamente classicados, o valor obtido equivale distncia com sinal negativo. Para realizar

uma diferenciao, a margem da Equao 4 ser referenciada como margem de conana.

A partir do conceito introduzido, possvel denir o erro marginal de uma funo

f (R

(f)) sobre um conjunto de treinamento. Esse erro fornece a proporo de exemplos

de treinamento cuja margem de conana inferior a uma determinada constante > 0

(Equao 5) [37].

RITA Volume XIV Nmero 2 2007 51

Uma Introduo s Support Vector Machines

R

(f) =

1

n

n

i=1

I (y

i

f (x

i

) < ) (5)

Na Equao 5, I(q) = 1 se q verdadeiro e I(q) = 0 se q falso.

Existe uma constante c tal que, com probabilidade 1 [0, 1], para todo > 0 e

F correspondendo classe de funes lineares f(x) = w x com x R e w 1, o

seguinte limite se aplica [37]:

R(f) R

(f) +

c

n

_

R

2

2

log

2

_

n

_

+ log

_

1

__

(6)

Como na Equao 3, tem-se na Expresso 6 novamente o erro esperado limitado pela

soma de uma medida de erro no conjunto de treinamento, neste caso o erro marginal, a

um termo de capacidade. A interpretao do presente limite de que uma maior margem

implica emummenor termo de capacidade. Entretanto, a maximizao da margempode levar

a umaumento na taxa de erro marginal, pois torna-se mais difcil obedecer restrio de todos

os dados de treinamento estarem distantes de uma margem maior em relao ao hiperplano

separador. Um baixo valor de , em contrapartida, leva a um erro marginal menor, porm

aumenta o termo de capacidade. Deve-se ento buscar um compromisso entre a maximizao

da margem e a obteno de um erro marginal baixo.

Como concluso tem-se que, na gerao de um classicador linear, deve-se buscar

um hiperplano que tenha margem elevada e cometa poucos erros marginais, minimizando

assim o erro sobre os dados de teste e de treinamento, respectivamente. Esse hiperplano

denominado timo [38].

Existem diversos outros limites reportados na literatura, assim como outros tipos de

medida de complexidade de uma classe de funes [28]. Um exemplo a dimenso fat-

shattering, que caracteriza o poder de um conjunto de funes em separar os dados com uma

margem [35]. Os limites apresentados anteriormente, embora possam ser considerados

simplicados, provm uma base terica suciente compreeno das SVMs.

4 SVMs Lineares

As SVMs surgiram pelo emprego direto dos resultados fornecidos pela TAE. Nesta

seo apresentado o uso de SVMs na obteno de fronteiras lineares para a separao de

dados pertencentes a duas classes. A primeira formulao, mais simples, lida com problemas

linearmente separveis, denidos adiante [3]. Essa formulao foi posteriormente estendida

52 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

para denir fronteiras lineares sobre conjuntos de dados mais gerais [10]. A partir desses

conceitos iniciais, na Seo 5 descreve-se a obteno de fronteiras no lineares com SVMs,

por meio de uma extenso das SVMs lineares.

4.1 SVMs com Margens Rgidas

As SVMs lineares com margens rgidas denem fronteiras lineares a partir de dados

linearmente separveis. Seja T um conjunto de treinamento com n dados x

i

X e seus

respectivos rtulos y

i

Y, em que X constitui o espao dos dados e Y = {1, +1}. T

linearmente separvel se possvel separar os dados das classes +1 e 1 por um hiperplano

[38].

Classicadores que separam os dados por meio de um hiperplano so denominados

lineares [6]. A equao de um hiperplano apresentada na Equao 7, em que w x o

produto escalar entre os vetores w e x, w X o vetor normal ao hiperplano descrito e

b

w

corresponde distncia do hiperplano em relao origem, com b .

f (x) = w x + b = 0 (7)

Essa equao divide o espao dos dados X em duas regies: w x + b > 0 e w

x + b < 0. Uma funo sinal g(x) = sgn(f(x)) pode ento ser empregada na obteno das

classicaes, conforme ilustrado na Equao 8 [37].

g (x) = sgn(f (x)) =

_

+1 se w x + b > 0

1 se w x + b < 0

(8)

A partir de f(x), possvel obter um nmero innito de hiperplanos equivalentes,

pela multiplicao de w e b por uma mesma constante [31]. Dene-se o hiperplano cannico

em relao ao conjunto T como aquele em que we b so escalados de forma que os exemplos

mais prximos ao hiperplano w x + b = 0 satisfaam a Equao 9 [28].

|w x

i

+ b| = 1 (9)

Essa forma implica nas inequaes 10, resumidas na Expresso 11.

_

w x

i

+ b +1 se y

i

= +1

w x

i

+ b 1 se y

i

= 1

(10)

y

i

(w x

i

+ b) 1 0, (x

i

, y

i

) T (11)

RITA Volume XIV Nmero 2 2007 53

Uma Introduo s Support Vector Machines

Seja x

1

um ponto no hiperplano H

1

:w x + b = +1 e x

2

um ponto no hiperplano

H

2

:w x + b = 1, conforme ilustrado na Figura 6. Projetando x

1

x

2

na direo de w,

perpendicular ao hiperplano separador w x + b = 0, possvel obter a distncia entre os

hiperplanos H

1

e H

2

[6]. Essa projeo apresentada na Equao 12.

(x

1

x

2

)

_

w

w

(x

1

x

2

)

x

1

x

2

_

(12)

Figura 6. Clculo da distncia d entre os hiperplanos H

1

e H

2

[15]

Tem-se que w x

1

+ b = +1 e w x

2

+ b = 1. A diferena entre essas equaes

fornece w (x

1

x

2

) = 2 [15]. Substituindo esse resultado na Equao 12, tem-se:

2 (x

1

x

2

)

w x

1

x

2

(13)

Como deseja-se obter o comprimento do vetor projetado, toma-se a norma da Equao

13, obtendo:

2

w

(14)

Essa a distncia d, ilustrada na Figura 6, entre os hiperplanos H

1

e H

2

, paralelos ao

hiperplano separador. Como w e b foram escalados de forma a no haver exemplos entre H

1

54 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

e H

2

,

1

w

a distncia mnima entre o hiperplano separador e os dados de treinamento. Essa

distncia denida como a margem geomtrica do classicador linear [6].

A partir das consideraes anteriores, verica-se que a maximizao da margem de

separao dos dados em relao a w x + b = 0 pode ser obtida pela minimizao de w

[5]. Dessa forma, recorre-se ao seguinte problema de otimizao [38]:

Minimizar

w,b

1

2

w

2

(15)

Com as restries: y

i

(w x

i

+ b) 1 0, i = 1, . . . , n (16)

As restries so impostas de maneira a assegurar que no haja dados de treinamento

entre as margens de separao das classes. Por esse motivo, a SVM obtida possui tambm a

nomenclatura de SVM com margens rgidas.

O problema de otimizao obtido quadrtico, cuja soluo possui uma ampla e es-

tabelecida teoria matemtica [38]. Como a funo objetivo sendo minimizada convexa e

os pontos que satisfazem as restries formam um conjunto convexo, esse problema possui

um nico mnimo global [31]. Problemas desse tipo podem ser solucionados com a intro-

duo de uma funo Lagrangiana, que engloba as restries funo objetivo, associadas a

parmetros denominados multiplicadores de Lagrange

i

(Equao 17) [38].

L(w, b, ) =

1

2

w

2

i=1

i

(y

i

(w x

i

+ b) 1) (17)

A funo Lagrangiana deve ser minimizada, o que implica em maximizar as variveis

i

e minimizar w e b [28]. Tem-se ento um ponto de sela, no qual:

L

b

= 0 e

L

w

= 0 (18)

A resoluo dessas equaes leva aos resultados representados nas expresses 19 e

20.

n

i=1

i

y

i

= 0 (19)

w =

n

i=1

i

y

i

x

i

(20)

RITA Volume XIV Nmero 2 2007 55

Uma Introduo s Support Vector Machines

Substituindo as equaes 19 e 20 na Equao 17, obtm-se o seguinte problema de

otimizao:

Maximizar

i=1

i

1

2

n

i,j=1

j

y

i

y

j

(x

i

x

j

) (21)

Com as restries:

_

_

_

i

0, i = 1, . . . , n

n

i=1

i

y

i

= 0

(22)

Essa formulao denominada forma dual, enquanto o problema original referen-

ciado como forma primal. A forma dual possui os atrativos de apresentar restries mais

simples e permitir a representao do problema de otimizao em termos de produtos internos

entre dados, o que ser til na posterior no-linearizao das SVMs (Seo 5). interessante

observar tambm que o problema dual formulado utilizando apenas os dados de treinamento

e os seus rtulos.

Seja

a soluo do problema dual e w

e b

as solues da forma primal. Obtido o

valor de

, w

pode ser determinado pela Equao 20. O parmetro b

denido por

e por condies de Khn-Tucker, provenientes da teoria de otimizao com restries e que

devem ser satisfeitas no ponto timo. Para o problema dual formulado, tem-se [33]:

i

(y

i

(w

x

i

+ b

) 1) = 0, i = 1, . . . , n (23)

Observa-se nessa equao que

i

pode ser diferente de 0 somente para os dados que se

encontramsobre os hiperplanos H

1

e H

2

. Estes so os exemplos que se situammais prximos

ao hiperplano separador, exatamente sobre as margens. Para os outros casos, a condio

apresentada na Equao 23 obedecida apenas com

i

= 0. Esses pontos no participam

ento do clculo de w

(Equao 20). Os dados que possuem

i

> 0 so denominados

vetores de suporte (SVs, do Ingls Support Vectors) e podem ser considerados os dados mais

informativos do conjunto de treinamento, pois somente eles participam na determinao da

equao do hiperplano separador (Equao 26) [5].

O valor de b

calculado a partir dos SVs e das condies representadas na Equao

23 [38]. Computa-se a mdia apresentada na Equao 24 sobre todos x

j

tal que

j

> 0, ou

seja, todos os SVs. Nessa equao, n

SV

denota o nmero de SVs e SV representa o conjunto

dos SVs.

b

=

1

n

SV

x

j

SV

1

y

j

w

x

j

(24)

56 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

Substituindo w

pela expresso na Equao 20, tem-se:

b

=

1

n

SV

x

j

SV

_

1

y

j

x

i

SV

i

y

i

x

i

x

j

_

(25)

Como resultado nal, tem-se o classicador g(x) apresentado na Equao 26, em que

sgn representa a funo sinal, w

fornecido pela Equao 20 e b

pela Equao 25.

g (x) = sgn(f (x)) = sgn

_

x

i

SV

y

i

i

x

i

x + b

_

(26)

Esta funo linear representa o hiperplano que separa os dados com maior margem,

considerado aquele com melhor capacidade de generalizao de acordo com a TAE. Essa

caracterstica difere as SVMs lineares de margens rgidas das Redes Neurais Perceptron, em

que o hiperplano obtido na separao dos dados pode no corresponder ao de maior margem

de separao.

4.2 SVMs com Margens Suaves

Em situaes reais, difcil encontrar aplicaes cujos dados sejam linearmente se-

parveis. Isso se deve a diversos fatores, entre eles a presena de rudos e outliers nos dados

ou prpria natureza do problema, que pode ser no linear. Nesta seo as SVMs lineares

de margens rgidas so estendidas para lidar com conjuntos de treinamento mais gerais. Para

realizar essa tarefa, permite-se que alguns dados possam violar a restrio da Equao 16.

Isso feito com a introduo de variveis de folga

i

, para todo i = 1, . . . , n [37]. Essas

variveis relaxam as restries impostas ao problema de otimizao primal, que se tornam

[38]:

y

i

(w x

i

+ b) 1

i

,

i

0, i = 1, . . . , n (27)

Aaplicao desse procedimento suaviza as margens do classicador linear, permitindo

que alguns dados permaneam entre os hiperplanos H

1

e H

2

e tambm a ocorrncia de alguns

erros de classicao. Por esse motivo, as SVMs obtidas neste caso tambm podem ser

referenciadas como SVMs com margens suaves.

Um erro no conjunto de treinamento indicado por um valor de

i

maior que 1. Logo,

a soma dos

i

representa um limite no nmero de erros de treinamento [5]. Para levar em

RITA Volume XIV Nmero 2 2007 57

Uma Introduo s Support Vector Machines

considerao esse termo, minimizando assim o erro sobre os dados de treinamento, a funo

objetivo da Equao 15 reformulada como [5]:

Minimizar

w,b,

1

2

w

2

+ C

_

n

i=1

i

_

(28)

A constante C um termo de regularizao que impe um peso minimizao dos

erros no conjunto de treinamento em relao minimizao da complexidade do modelo

[31]. A presena do termo

n

i=1

i

no problema de otimizao tambm pode ser vista como

uma minimizao de erros marginais, pois um valor de

i

(0, 1] indica um dado entre as

margens. Tem-se ento uma formulao de acordo com os princpios da TAE discutidos na

Seo 3.

Novamente o problema de otimizao gerado quadrtico, com as restries lineares

apresentadas na Equao 27. A sua soluo envolve passos matemticos semelhantes aos

apresentados anteriormente, com a introduo de uma funo Lagrangiana e tornando suas

derivadas parciais nulas. Tem-se como resultado o seguinte problema dual:

Maximizar

i=1

i

1

2

n

i,j=1

j

y

i

y

j

(x

i

x

j

) (29)

Com as restries:

_

_

_

0

i

C, i = 1, . . . , n

n

i=1

i

y

i

= 0

(30)

Pode-se observar que essa formulao igual apresentada para as SVMs de margens

rgidas, a no ser pela restrio nos

i

, que agora so limitados pelo valor de C.

Seja

a soluo do problema dual, enquanto w

, b

denotam as solues da

forma primal. O vetor w

continua sendo determinado pela Equao 20. As variveis

i

podem ser calculadas pela Equao 31 [11].

i

= max

_

_

_

0, 1 y

i

n

j=1

y

j

j

x

j

x

i

+ b

_

_

_

(31)

A varivel b

provm novamente de

e de condies de Khn-Tucker, que neste

caso so [33]:

58 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

i

(y

i

(w

x

i

+ b

) 1 +

i

) = 0 (32)

(C

i

)

i

= 0 (33)

Como nas SVMs de margens rgidas, os pontos x

i

para os quais

i

> 0 so denomi-

nados vetores de suporte (SVs), sendo os dados que participam da formao do hiperplano

separador. Porm, neste caso, pode-se distinguir tipos distintos de SVs [33]. Se

i

< C,

pela Equao 33,

i

= 0 e ento, da Equao 32, estes SVs encontram-se sobre as margens

e tambm so denominados livres. Os SVs para os quais

i

= C podem representar trs

casos [33]: erros, se

i

> 1; pontos corretamente classicados, porm entre as margens, se

0 <

i

1; ou pontos sobre as margens, se

i

= 0. O ltimo caso ocorre raramente e os SVs

anteriores so denominados limitados. Na Figura 7 so ilustrados os possveis tipos de SVs.

Pontos na cor cinza representam SVs livres. SVs limitados so ilustrados em preto. Pontos

pretos com bordas extras correspondem a SVs limitados que so erros de treinamento. Todos

os outros dados, em branco, so corretamente classicados e encontram-se fora das margens,

possuindo

i

= 0 e

i

= 0.

Figura 7. Tipos de SVs: livres (cor cinza) e limitados (cor preta) [31]

Para calcular b

, computa-se a mdia da Equao 24 sobre todos SVs x

j

entre as

margens, ou seja, com

i

< C [38].

Tem-se como resultado nal a mesma funo de classicao representada na Equao

26, porm neste caso as variveis

i

so determinadas pela soluo da Expresso 29 com as

restries da Equao 30.

RITA Volume XIV Nmero 2 2007 59

Uma Introduo s Support Vector Machines

5 SVMs No Lineares

As SVMs lineares so ecazes na classicao de conjuntos de dados linearmente se-

parveis ou que possuam uma distribuio aproximadamente linear, sendo que a verso de

margens suaves tolera a presena de alguns rudos e outliers. Porm, h muitos casos em

que no possvel dividir satisfatoriamente os dados de treinamento por um hiperplano. Um

exemplo apresentado na Figura 8a, emque o uso de uma fronteira curva seria mais adequada

na separao das classes.

Figura 8. (a) Conjunto de dados no linear; (b) Fronteira no linear no espao de entradas; (c)

Fronteira linear no espao de caractersticas [28]

As SVMs lidam com problemas no lineares mapeando o conjunto de treinamento de

seu espao original, referenciado como de entradas, para um novo espao de maior dimenso,

denominado espao de caractersticas (feature space) [15]. Seja : X ummapeamento,

em que X o espao de entradas e denota o espao de caractersticas. A escolha apropriada

de faz com que o conjunto de treinamento mapeado empossa ser separado por uma SVM

linear.

O uso desse procedimento motivado pelo teorema de Cover [14]. Dado um conjunto

de dados no linear no espao de entradas X, esse teorema arma que X pode ser trans-

formado em um espao de caractersticas no qual com alta probabilidade os dados so

linearmente separveis. Para isso duas condies devem ser satisfeitas. A primeira que a

transformao seja no linear, enquanto a segunda que a dimenso do espao de caracters-

ticas seja sucientemente alta.

60 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

Para ilustrar esses conceitos, considere o conjunto de dados apresentado na Figura 8a

[28]. Transformando os dados de

2

para

3

com o mapeamento representado na Equao

34, o conjunto de dados no linear em

2

torna-se linearmente separvel em

3

(Figura 8c).

possvel ento encontrar um hiperplano capaz de separar esses dados, descrito na Equao

35. Pode-se vericar que a funo apresentada, embora linear em

3

(Figura 8c), corresponde

a uma fronteira no linear em

2

(Figura 8b).

(x) = (x

1

, x

2

) =

_

x

2

1

,

2x

1

x

2

, x

2

2

_

(34)

f (x) = w (x) + b = w

1

x

2

1

+ w

2

2x

1

x

2

+ w

3

x

2

2

+ b = 0 (35)

Logo, mapea-se inicialmente os dados para um espao de maior dimenso utilizando

e aplica-se a SVM linear sobre este espao. Essa encontra o hiperplano com maior margem

de separao, garantindo assim uma boa generalizao. Utiliza-se a verso de SVM linear

com margens suaves, que permite lidar com rudos e outliers presentes nos dados. Para

realizar o mapeamento, aplica-se aos exemplos presentes no problema de otimizao re-

presentado na Equao 29, conforme ilustrado a seguir:

Maximizar

i=1

i

1

2

n

i,j=1

j

y

i

y

j

((x

i

) (x

j

)) (36)

Sob as restries da Equao 30. De forma semelhante, o classicador extrado se

torna:

g (x) = sgn(f (x)) = sgn

_

x

i

SV

i

y

i

(x

i

) (x) + b

_

(37)

Em que b

adaptado da Equao 24 tambm aplicando o mapeamento aos dados:

b

=

1

n

SV:

<C

x

j

SV :

j

<C

_

1

y

j

x

i

SV

i

y

i

(x

i

) (x

j

)

_

(38)

Como pode ter dimenso muito alta (at mesmo innita), a computao de pode

ser extremamente custosa ou invivel. Porm, percebe-se pelas equaes 36, 37 e 38 que a

nica informao necessria sobre o mapeamento de como realizar o clculo de produtos

RITA Volume XIV Nmero 2 2007 61

Uma Introduo s Support Vector Machines

escalares entre os dados no espao de caractersticas, pois tem-se sempre (x

i

) (x

j

), para

dois dados x

i

e x

j

, em conjunto. Isso obtido com o uso de funes denominadas Kernels.

Um Kernel K uma funo que recebe dois pontos x

i

e x

j

do espao de entradas e

computa o produto escalar desses dados no espao de caractersticas [16]. Tem-se ento:

K (x

i

, x

j

) = (x

i

) (x

j

) (39)

Para o mapeamento apresentado na Equao 34 e dois dados x

i

= (x

1i

, x

2i

) e x

j

=

(x

1j

, x

2j

) em

2

, por exemplo, o Kernel dado por [15]:

K (x

i

, x

j

) =

_

x

2

1i

,

2 x

1i

x

2i

, x

2

2i

_

_

x

2

1j

,

2 x

1j

x

2j

, x

2

2j

_

= (x

i

x

j

)

2

(40)

comum empregar a funo Kernel sem conhecer o mapeamento , que gerado

implicitamente. A utilidade dos Kernels est, portanto, na simplicidade de seu clculo e em

sua capacidade de representar espaos abstratos.

Para garantir a convexidade do problema de otimizao formulado na Equao 36 e

tambm que o Kernel represente mapeamentos nos quais seja possvel o clculo de produtos

escalares conforme a Equao 39, utiliza-se funes Kernel que seguem as condies estabe-

lecidas pelo teorema de Mercer [26, 37]. De forma simplicada, um Kernel que satisfaz as

condies de Mercer caracterizado por dar origem a matrizes positivas semi-denidas K,

em que cada elemento K

ij

denido por K

ij

= K(x

i

, x

j

), para todo i, j = 1, . . . , n [16].

Alguns dos Kernels mais utilizados na prtica so os Polinomiais, os Gaussianos ou

RBF (Radial-Basis Function) e os Sigmoidais, listados na Tabela 1. Cada um deles apresenta

parmetros que devem ser determinados pelo usurio, indicados tambm na tabela. O Kernel

Sigmoidal, em particular, satisfaz as condies de Mercer apenas para alguns valores de e

. Os Kernels Polinomiais com d = 1 tambm so denominados lineares.

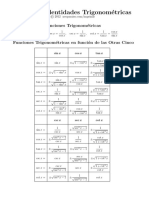

Tipo de Kernel Funo K(x

i

, x

j

) Parmetros

Polinomial ( (x

i

x

j

) +)

d

, e d

Gaussiano exp

x

i

x

j

Sigmoidal tanh( (x

i

x

j

) +) e

Tabela 1. Funes Kernel mais comuns [8]

62 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

6 Consideraes Finais

Neste texto foram descritos os conceitos bsicos a respeito das SVMs para problemas

de classicao, os quais tambm podem ser consultados em [21, 22]. Com princpios em-

basados na teoria de aprendizado estatstico, essa tcnica de AM se caracteriza por apresentar

uma boa capacidade de generalizao.

As SVMs tambm so robustas diante de dados de grande dimenso, sobre os quais

outras tcnicas de aprendizado comumente obtm classicadores super ou sub ajustados.

Outra caracterstica atrativa a convexidade do problema de otimizao formulado em seu

treinamento, que implica na existncia de um nico mnimo global. Essa uma vantagem das

SVMs sobre, por exemplo, as Redes Neurais Articiais (RNAs) Perceptron Multicamadas

(Multilayer Perceptron) [4, 14], em que h mnimos locais na funo objetivo minimiza-

da. Alm disso, o uso de funes Kernel na no-linearizao das SVMs torna o algoritmo

eciente, pois permite a construo de simples hiperplanos em um espao de alta dimenso

de forma tratvel do ponto de vista computacional [5].

Entre as principais limitaes das SVMs encontram-se a sua sensibilidade a escolhas

de valores de parmetros e a diculdade de interpretao do modelo gerado por essa tcnica,

problemas que tm sido abordados em diversos trabalhos recentes, como [9, 12, 32, 18, 24,

40] e [13, 7, 44], respectivamente.

Observou-se no decorrer deste tutorial que o raciocnio empregado pelas SVMs na

obteno do classicador nal leva a um problema de otimizao dual em termos dos dados

de treinamento. Porm, a forma de soluo desse problema no foi apresentada. Existem

diversos pacotes matemticos capazes de solucionar problemas quadrticos com restries.

Contudo, eles geralmente no so adequados a aplicaes de AM, que em geral se caracteri-

zam pela necessidade de lidar com um grande volume de dados. Diversas tcnicas e estrat-

gias foram ento propostas para adaptar a soluo do problema de otimizao das SVMs a

aplicaes de larga escala. Em geral, recorre-se a alguma estratgia decomposicional, em

que subproblemas menores so otimizados a cada passo do algoritmo. Uma discusso mais

detalhada a respeito dos mtodos e algoritmos comumente empregados nesse processo pode

ser encontrada em [11].

O presente artigo tambm se limitou a apresentar a formulao original das SVMs,

a qual capaz de lidar apenas com problemas de classicao binrios. Existe uma srie

de tcnicas que podem ser empregadas na generalizao das SVMs para a soluo de pro-

blemas multiclasses. Pode-se recorrer decomposio do problema multiclasses em vrios

subproblemas binrios ou reformular o algoritmo de treinamento das SVMs em verses mul-

ticlasses. Em geral, esse ltimo procedimento leva a algoritmos computacionalmente cus-

tosos [17]. Por esse motivo, a estratgia decomposicional empregada mais frequentemente.

Revises a respeito da obteno de previses multiclasses com SVMs podem ser consultadas

RITA Volume XIV Nmero 2 2007 63

Uma Introduo s Support Vector Machines

em [22, 23, 25].

As SVMs tambm podem ser aplicadas na soluo de problemas de regresso e no

agrupamento de dados (aprendizado no supervisionado). Contudo, o problema de otimiza-

o para o seu treinamento deve ser reformulado para lidar com as caractersticas e objetivos

desses problemas. Mais detalhes podem ser consultados em [2, 36].

7 Agradecimentos

FAPESP e ao CNPq pelo apoio nanceiro.

8 Referncias

[1] J. A. Baranauskas and M. C. Monard. Reviewing some machine learning concepts and

methods. Technical Report 102, Instituto de Cincias Matemticas e de Computao,

Universidade de So Paulo, So Carlos. Disponvel em: ftp://ftp.icmc.usp.

br/pub/BIBLIOTECA/rel_tec/RT_102.ps.zip, Fevereiro 2000.

[2] A. Ben-Hur, D. Horn, H. T. Siegelmann, and V. N. Vapnik. A support vector cluster-

ing method. In Proceedings of the International Conference on Pattern Recognition

(ICPR00), volume 2, pages 724727, 2000.

[3] B. E. Boser, I. L. Guyon, and V. N. Vapnik. A training algorithm for optimal margin

classiers. In Proceedings of the 5th Annual Workshop on Computational Learning

Theory, pages 144152, Pittsburg, Pennsylvania, US, 1992.

[4] A. Braga, A. C. P. L. F. Carvalho, and T. B. Ludermir. Redes Neurais Articiais: Teoria

e Aplicaes. Editora LTC, 2000.

[5] C. J. C. Burges. A tutorial on support vector machines for pattern recognition. Know-

ledge Discovery and Data Mining, 2(2):143, 1998.

[6] C. Campbell. An introduction to kernel methods. In R. J. Howlett and L. C. Jain,

editors, Radial Basis Function Networks: Design and Applications, pages 155192,

Berlin, 2000. Springer Verlag.

[7] J. L. Castro, L. D. Flores-Hidalgo, C. J. Mantas, and J. M. Puche. Extraction of fuzzy

rules from support vector machines. Fuzzy Sets and Systems archive, 158(18):2057

2077, 2007.

[8] C.-C. Chang and C.-J. Lin. LIBSVM: a library for support vector machines.

Disponvel em: http://www.csie.ntu.edu.tw/~cjlin/libsvm/. Aces-

sado em: 09/2003, 2004.

64 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

[9] O. Chapelle, V. Vapnik, O. Bousquet, and S. Mukherjee. Choosing multiple parameters

for support vector machines. Machine Learning, 46(1-3):131159, 2002.

[10] C. Cortes and V. N. Vapnik. Support vector networks. Machine Learning, 20(3):273

296, 1995.

[11] N. Cristianini and J. Shawe-Taylor. An Introduction to Support Vector Machines and

other kernel-based learning methods. Cambridge University Press, 2000.

[12] K. Duan, S. S. Keerthi, and A. N. Poo. Evaluation of simple performance measures for

tuning SVM hyperparameters. Neurocomputing, 51:4159, 2003.

[13] Xiuju Fu, ChongJin Ong, S. Keerthi, Gih Guang Hung, and Liping Goh. Extracting the

knowledge embedded in support vector machines. In Proceedings IEEE International

Joint Conference on Neural Networks, volume 1, page 296, 2004.

[14] S. Haykin. Neural Networks - A Compreensive Foundation. Prentice-Hall, New Jersey,

2nd edition, 1999.

[15] M. A. Hearst, B. Schlkopf, S. Dumais, E. Osuna, and J. Platt. Trends and controversies

- support vector machines. IEEE Intelligent Systems, 13(4):1828, 1998.

[16] R. Herbrich. Learning Kernel Classiers: Theory and Algorithms. MIT Press, 2001.

[17] C.-W. Hsu and C.-J. Lin. A comparison of methods for multi-class support vector

machines. IEEE Transactions on Neural Networks, 13(2):415425, March 2002.

[18] F. Imbault and K. Lebart. A stochastic optimization approach for parameter tuning

of support vector machines. In Proceedings of the 17th International Conference on

Pattern Recognition, volume 4, pages 597600, 2004.

[19] T. Joachims. Learning to classify texts using support vector machines: methods, theory

and algorithms. Kluwer Academic Publishers, 2002.

[20] K. I. Kim, K. Jung, S. H. Park, and H. J. Kim. Support vector machines for tex-

ture classication. IEEE Transactions on Pattern Analysis and Machine Intelligence,

24(11):15421550, 2002.

[21] A. C. Lorena and A. C. P. L. F. Carvalho. Classicadores de margens largas (Large

Margin Classiers). Technical Report 195, Instituto de Cincias Matemticas e de Com-

putao, Universidade de So Paulo, So Carlos. Disponvel em: ftp://ftp.icmc.

usp.br/pub/BIBLIOTECA/rel_tec/RT_195.ps.zip, 2003.

RITA Volume XIV Nmero 2 2007 65

Uma Introduo s Support Vector Machines

[22] A. C. Lorena and A. C. P. L. F. Carvalho. Introduo s mquinas de vetores suporte

(Support Vector Machines). Technical Report 192, Instituto de Cincias Matemticas e

de Computao, Universidade de So Paulo, So Carlos. Disponvel em: ftp://ftp.

icmc.usp.br/pub/BIBLIOTECA/rel_tec/RT_192.ps.zip, Abril 2003.

[23] A. C. Lorena and A. C. P. L. F. Carvalho. Reviso de tcnicas para gerao de classi-

cadores de margens largas multiclasses. Technical Report 221, Instituto de Cincias

Matemticas e de Computao, Universidade de So Paulo, So Carlos. Disponvel

em: ftp://ftp.icmc.usp.br/pub/BIBLIOTECA/rel_tec/RT_221.ps,

Novembro 2003.

[24] A. C. Lorena and A. C. P. L. F. Carvalho. Multiclass SVM design and parameter selec-

tion with genetic algorithms. In IEEE Proceedings of the IX Brazilian Symposium on

Neural Networks (SBRN), 2006.

[25] Ana Carolina Lorena. Investigao de estratgias para a gerao de mquinas

de vetores de suporte multiclasses. PhD thesis, Instituto de Cincias Matemti-

cas e de Computao, Universidade de So Paulo, So Carlos. Disponvel

em: http://www.teses.usp.br/teses/disponiveis/55/55134/

tde-26052006-111406/, 2006.

[26] J. Mercer. Functions of positive and negative type and their connection with the theory

of integral equations. Philosophical Transactions of the Royal Society, A 209:415446,

1909.

[27] T. Mitchell. Machine Learning. McGraw Hill, 1997.

[28] K. R. Mller, S. Mika, G. Rtsch, K. Tsuda, and B. Schlkopf. An introduction to

kernel-based learning algorithms. IEEE Transactions on Neural Networks, 12(2):181

201, Maro 2001.

[29] M. C. Monard and J. A. Baranauskas. Conceitos de aprendizado de mquina. In S. O.

Rezende, editor, Sistemas Inteligentes - Fundamentos e Aplicaes, pages 89114. Ed-

itora Manole, 2003.

[30] W. S. Noble. Support vector machine applications in computational biology. In

B. Schlkopf, K. Tsuda, and J.-P. Vert, editors, Kernel Methods in computational bi-

ology, pages 7192. MIT Press, 2004.

[31] A. Passerini. Kernel Methods, multiclass classication and applications to computa-

tional molecular biology. PhD thesis, Universit Degli Studi di Firenze, 2004.

[32] A. Passerini, M. Pontil, and P. Frasconi. On tuning hyper-parameters of multi-

class margin classiers. In Proceedings of 8th Congress of Associazione Italiana per

66 RITA Volume XIV Nmero 2 2007

Uma Introduo s Support Vector Machines

lIntelligenza Articiale (AIIA). Disponvel em: http://www-dii.ing.unisi.

it/aiia2002/paper/APAUT/passerini-aiia02.pdf, 2002.

[33] M. Pontil and A. Verri. Support vector machines for 3-D object recognition. IEEE

Transactions on Pattern Analysis and Machine Intelligence, 20(6):637646, 1998.

[34] B. Schlkopf, I. Guyon, and J. Weston. Statistical learning and kernel methods in bioin-

formatics. In P. Frasconi and R. Shamir, editors, Articial Intelligence and Heuristic

Methods in Bioinformatics, pages 121. IOS Press, 2003.

[35] J. Shawe-Taylor, P. L. Barlett, R. C. Williamson, and M. Anthony. Structural risk min-

imization over data-dependent hierarquies. IEEE Transactions on Information Theory,

44(5):19261940, 1998.

[36] A. Smola and B. Schlkopf. A tutorial on support vector regression. Technical Report

NC2-TR-1998-030, NeuroCOLT2, 1998.

[37] A. J. Smola, P. Barlett, B. Schlkopf, and D. Schuurmans. Introduction to large mar-

gin classiers. In A. J. Smola, P. Barlett, B. Schlkopf, and D. Schuurmans, editors,

Advances in Large Margin Classiers, pages 128. MIT Press, 1999.

[38] A. J. Smola and B. Schlkopf. Learning with Kernels. The MIT Press, Cambridge, MA,

2002.

[39] M. C. P. Souto, A. C. Lorena, A. C. B. Delbem, and A. C. P. L. F. Carvalho. Tcnicas

de Aprendizado de Mquina para problemas de Biologia Molecular, pages 103152.

Minicursos de Inteligncia Articial, Jornada de Atualizao Cientca em Inteligncia

Articial, XXIII Congresso da Sociedade Brasileira de Computao, 2003.

[40] B. F. Souza, A. C. P. L. F. Carvalho, R. Calvo, and R. P. Ishii. Multiclass svm model

selection using particle swarm optimization. In Proceedings of 6th HIS, pages 3136,

2006.

[41] V. N. Vapnik. The nature of Statistical learning theory. Springer-Verlag, New York,

1995.

[42] V. N. Vapnik. Statistical Learning Theory. John Wiley and Sons, 1998.

[43] V. N. Vapnik and A. Y. Chervonenkis. On the uniform convergence of relative fre-

quencies of events to their probabilities. Theory of Probability and its Applications,

16(2):283305, 1971.

[44] Dexian Zhang, Zhixiao Yang, Yanfeng Fan, and Ziqiang Wang. Extracting symbolic

rules from trained support vector machines based on the derivative heuristic informa-

tion. In Fourth International Conference on Fuzzy Systems and Knowledge Discovery

(FSKD 2007), volume 1, pages 592597, 2007.

RITA Volume XIV Nmero 2 2007 67

You might also like

- Cap 7 Conceitos e DefiniçõesDocument15 pagesCap 7 Conceitos e DefiniçõesARISTOTE DIVIOCA ArilsonNo ratings yet

- TVM ConsequenciasDocument5 pagesTVM ConsequenciasArthur DaherNo ratings yet

- Lista de Exercicios Matrizes e DeterminantesDocument9 pagesLista de Exercicios Matrizes e DeterminantesLuiz Marcel L NunesNo ratings yet

- Atividades Lúdicas No Ensino E Aprendizagem Das Quatro Operações MatemáticasDocument6 pagesAtividades Lúdicas No Ensino E Aprendizagem Das Quatro Operações MatemáticasRubia Cristina GuedesNo ratings yet

- Uma Disciplina Uma Historia (Google Academico Dia 10 de 03 de 2020)Document196 pagesUma Disciplina Uma Historia (Google Academico Dia 10 de 03 de 2020)manoel cristiano marreiro sampaioNo ratings yet

- Yamamoto Geoestatistica AplicadaDocument84 pagesYamamoto Geoestatistica AplicadaBarbara Moutinho50% (2)

- Aula 14 - Conjuntos Numéricos (Questões)Document46 pagesAula 14 - Conjuntos Numéricos (Questões)adrielsonNo ratings yet

- Lista Exercicios Superficies 2017Document4 pagesLista Exercicios Superficies 2017Gabriel Tweedie MüllerNo ratings yet

- Raquel Recuero - TEORIA DAS REDES E REDES SOCIAIS NA INTERNET - Considerações Sobre o Orkut Os Weblogs e Os FotologsDocument15 pagesRaquel Recuero - TEORIA DAS REDES E REDES SOCIAIS NA INTERNET - Considerações Sobre o Orkut Os Weblogs e Os FotologsFelipe SantosNo ratings yet

- HM 02Document2 pagesHM 02Hugo LimaNo ratings yet

- Fundamentos Da Matemática AP Parte 1Document31 pagesFundamentos Da Matemática AP Parte 1RodrigoNuriNo ratings yet

- Razões EquivalentesDocument5 pagesRazões Equivalentesdhyana666No ratings yet

- Saeb 2015Document9 pagesSaeb 2015Roberto Correa100% (1)

- Tabla de Identidades TrigonometricasDocument4 pagesTabla de Identidades TrigonometricasLiis RiincónNo ratings yet

- Teoria Da Relatividade RestritaDocument62 pagesTeoria Da Relatividade RestritaMarvyn IngaNo ratings yet

- Aula 7 Propag CanaisDocument4 pagesAula 7 Propag CanaisGuilherme AmorimNo ratings yet

- PolinomiosDocument6 pagesPolinomiosEmanuel SantosNo ratings yet

- Eletromagnetismo - Parte IiDocument10 pagesEletromagnetismo - Parte IiAntonio Tavares Franca JuniorNo ratings yet

- Tensores 2020Document46 pagesTensores 2020Jhonnes ToledoNo ratings yet

- Livro MatemáticaDocument164 pagesLivro MatemáticaErone Hemann LanesNo ratings yet

- Atividade1 (InstMatematica)Document1 pageAtividade1 (InstMatematica)Jadson EvertonNo ratings yet

- Prova 1aFASE OPiM Nível 3Document5 pagesProva 1aFASE OPiM Nível 3Werton BastosNo ratings yet

- 02 A-Aula 18.1 Estudo Do PontoDocument33 pages02 A-Aula 18.1 Estudo Do PontoLaiana TrindadeNo ratings yet

- 8a - Aula CMSP - Problemas de ContagemDocument12 pages8a - Aula CMSP - Problemas de ContagemRosana RodriguesNo ratings yet

- Exercicio Resolvidos InformaticaDocument39 pagesExercicio Resolvidos InformaticaVíctor André MacandzaNo ratings yet

- Agrupamento de Escolas de Diogo Cão, Vila Real: 2021/2022 Ficha de Trabalho 3 NovembroDocument3 pagesAgrupamento de Escolas de Diogo Cão, Vila Real: 2021/2022 Ficha de Trabalho 3 NovembroIolanda SantosNo ratings yet

- Repensando A MatematicaDocument2 pagesRepensando A MatematicaRosi WhindsonNo ratings yet

- A Historia e Evolução Dos ComputadoresDocument4 pagesA Historia e Evolução Dos ComputadoresCharles BeatzNo ratings yet

- Cilindro Cone+Esfera2 o ExperimentoDocument11 pagesCilindro Cone+Esfera2 o ExperimentoCleberson RamonNo ratings yet

- Básicas A) : Aula 1 - Operações Multiplicação DivisãoDocument12 pagesBásicas A) : Aula 1 - Operações Multiplicação DivisãoVitor BotelhoNo ratings yet