Professional Documents

Culture Documents

Clase1 - TxDatos DEBER PDF

Uploaded by

Carlos CarpioOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Clase1 - TxDatos DEBER PDF

Uploaded by

Carlos CarpioCopyright:

Available Formats

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Transmisin de Datos

Katty Rohoden Jaramillo

23 de septiembre 2013

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Contenidos

El modelo de comunicaciones digitales

Preguntas

Antecedentes

Teora de la Informacin segn Shannon

Informacin

Fuente de Informacin

Entropa

Propiedades de la Entropa

Fuente de Informacin Continua

Katty Rohoden Jaramillo Transmisin de Datos

Teora de la Informacin

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

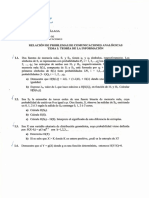

Figure : Modelo de Comunicaciones Digitales

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

El modelo de comunicaciones digitales

Fuente: fuente de datos (digitales).

Codificador de fuente: remueve redundancia de los datos.

Esta es la parte de compresin de datos.

Codificador de Canal: Introduce redundancia nuevamente

a los datos, para deteccin o correccin de errores.

Decodificador de Canal: Ejecuta correcin o deteccin de

errores.

Decodificador de Fuente: Aade la informacin que se

quit a los datos en el Codificador de la Fuente.

Katty Rohoden Jaramillo Transmisin de Datos

Teora de la Informacin

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Preguntas

Cmo podemos medir la cantidad de informacin?

Hasta cunto podemos comprimir?

Cmo comprimimos?

Cmo evitamos errores que afecten el rendimiento?

Qu tan rpido pueden ser enviados los datos por un

canal de comunicaciones?

Qu pasa si la velocidad de los datos excede la capacidad

del canal?

Katty Rohoden Jaramillo Transmisin de Datos

Teora de la Informacin

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Antecedentes

Orgenes de la teora de la informacin datan de la

publicacin, por Claude E. Shannon, de un artculo en el

Bell System Technical Journal en 1948.

Shannon titul a su artculo: Una teora matemtica de la

comunicacin.

Shannon trata de los smbolos, y no de la informacin

misma.

Estudia la comunicacin y los medios de comunicacin,

antes que el producto final de la informacin (Shannon,

1948).

Shannon sugiri algunos lmites fundamentales para la

representacin y transmisin de informacin.

Katty Rohoden Jaramillo Transmisin de Datos

Teora de la Informacin

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Teora de la Informacin segn Shannon

Esta teora responde a dos peguntas fundamentales:

Cul es el umbral por debajo del cual una seal no puede

ser comprimida?

Cul es la tasa de transmisin mxima para una

comunicacin fiable a lo largo de un canal ruidoso?

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Teoremas de Shannon

Teoremas Shannon

Teorema de Codificacin de la Fuente (Primer Teorema de

Shannon).

Teorema de Codificacin del Canal (Segundo Teorema de

Shannon).

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Informacin

Definicin Sea E un suceso que puede presentarse con

probabilidad P(E). Cuando E tiene lugar, decimos que hemos

recibido:

1

I(E) = logr

P (E)

En donde:

I(E) es la cantidad de informacin.

E es el suceso.

P(E) es la probabilidad de ocurrencia del suceso.

r es la unidad de informacin.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Unidades de Informacin

La eleccin de la base del logaritmo que interviene en la

definicin equivale a elegir una determinada unidad, ya que,

1

loga (x) = logb (x)

logb (a)

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Unidad de Informacin: bit

Si se introduce el logaritmo de base 2, la unidad

correspondiente se denomina bit,

1

I(E) = log2 bits

P (E)

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Unidad de Informacin: nat

Cuando se emplean logaritmos naturales, la unidad

correspondiente se denomina nat,

1

I(E) = ln nats

P (E)

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Unidad de Informacin: hartley

Para los logaritmos de base 10, la unidad de informacin es el

Hartley,

1

I(E) = log10 Hartleys

P (E)

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Unidad de Informacin: Logaritmos de base r

Empleando logaritmos de base r,

1

I(E) = logr unidades de orden r

P (E)

1 Hartley = 3,32 bits

1 nat = 1,44 bits

Katty Rohoden Jaramillo Transmisin de Datos

Teora de la Informacin

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Fuente de Informacin

Una fuente de informacin es un modelo matemtico que

produce de forma aleatoria una sucesin de smbolos

llamados salidas.

Los smbolos producidos pueden ser nmeros reales como

mediciones de voltaje de un transductor, nmeros

binarios, formas de onda continua o discontinua, etc.

El espacio que contiene todos los posibles smbolos de

salida se conoce como alfabeto de la fuente.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Fuente de Informacin de Memoria Nula

Es una fuente emitiendo una secuencia de smbolos

pertenecientes a un alfabeto finito y fjo,

S = s1 , s2 , ..., sq

Los smbolos emitidos sucesivamente se eligen de acuerdo

con una ley fija de probabilidad.

Los smbolos emitidos son estadsticamente

independientes.

La fuente de memoria nula puede describirse mediante el

alfabeto fuente S y las probabilidades con que los smbolos

se presentan:

P (s1 ), P (s2 ), ..., P (sq )

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Informacin media

Informacin media suministrada por una fuente de

informacin de memoria nula.

La presencia de un smbolo Si corresponde a una cantidad

1

de informacin igual a I(si ) = log P (s i)

bits.

La probabilidad de que aparezca es precisamente P (si ).

Katty Rohoden Jaramillo Transmisin de Datos

Teora de la Informacin

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Entropa

Es la cantidad media de informacin por smbolo de la

fuente: X 1

H(S) = P (si ) log bits

P (si )

S

P

S , indica la suma extendida a q smbolos de la fuente S.

H(S) es el valor medio de la incertidumbre de un

observador antes de conocer la salida de la fuente.

La unidad de medida de la entropa es bits por smbolo.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Entropa: Ejemplo 1

Consideremos la fuente S = (s1 , s2 , s3 ) con P (s1 ) = 1/2 y

P (s2 ) = P (s3 ) = 1/4. Entonces:

H(S) = 1/2 log(2)+1/4 log(4)+1/4 log(4) = 3/2bits/smbolo

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Propiedades de la Entropa

H(S) = 0, si y solo si la probabilidad P (si ) = 1 para

i = 1, 2, ... y las probabilidades restantes en el conjunto son

todas cero (ninguna incertidumbre).

H(S) = log(q), si y solo si P (si ) = 1q para todo q. Todos los

smbolos son igualmente probables (incertidumbre

mxima).

El valor mximo de la entropa es precisamente log(q),

alcanzndose solamente si todos lo smbolos de la fuente

son equiprobables,

log(q) H(S) 0

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Velocidad de la Entropa

R = n.H(S)bits/segundo, en donde: n es la velocidad de

la fuente (velocidad del smbolo) (smbolo/segundo).

La unidad de la velocidad de la entropa es bits de

informacin/segundo.

R indica el promedio de informacin entregada por una

fuente en un segundo.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Redundancia de la Entropa

H(S)

R=1 Hmax , en donde:

H(S) y Hmax estn expresadas en la misma unidad (con la

misma base de algoritmo).

Para fuentes sin memoria con valores igualmente

probables, R = 0.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Entropa: Ejemplo 2

Una fuente de 3 smbolos S = (0, 1, 2) cuyas

probabilidades son P (0) = 0.3, P (1) = 0.5 y P (2) = 0.2.

Genera los smbolos a razn de 3 smbolos/segundo.

Calcular:

(a) La informacin que genera el smbolo 1.

(b) Si la fuente emite en un segundo la secuencia de smbolos

112, calcular la cantidad de informacin generada por la

fuente en ese segundo.

(c) La cantidad de informacin generada por smbolo en ese

segundo.

(d) La cantidad de informacin promedio generada por la

fuente.

(e) La tasa de informacin promedio generada por la fuente.

(f) La cantidad de informacin generada en 10 segundos.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Entropa: Respestas ejemplo 2

(a) La informacin que genera el smbolo 1.

1

= 1bit de informacin

I(1) = log

0.5

(b) Si la fuente emite en un segundo la secuencia de smbolos

112, calcular la cantidad de informacin generada por la

fuente en ese segundo.

1 1 1

+ log

I = log + log = 4.32bits de informacin

0.5 0.5 0.2

(c) La cantidad de informacin generada por smbolo en ese

segundo.

4.32

I/3 = = 1.44bits de informacin/smbolo

3

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Entropa: Respestas ejemplo 2

(a) La cantidad de informacin promedio generada por la

fuente.

1 1 1

H(S) = 0.3 log +0.5 log +0.2 log = 1.48bits/smbolo

0.3 0.5 0.2

(b) La tasa de informacin promedio generada por la fuente.

R = r.H(S) = 3(1.48) = 4.45bits de informacin/segundo

(c) La cantidad de informacin generada en 10 segundos.

bits de informacin

I10seg = 4.45 10segundos = 44.5bits de inf.

segundo

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Entropa: H(p)

La entropa es 0

cuando p = 0

p = 1. No existe

incertidumbre.

La entropa es

mxima cuando

p = 1/2. Cuando

p = 1/2 la

incertidumbre es Figure : H(p), funcin entropa

mxima.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Deber

Demostrar que:

H(S)

Hr (S) =

logr

En el lanzamiento de una moneda, qu pasa con la

cantidad de informacin promedio si:

1 Ambos lados de la moneda tienen igual probabilidad de

ocurrir?

2 Un lado de la moneda tiene el 90% de probabilidad de

ocurrir?

Propiedades de la Informacin.

Katty Rohoden Jaramillo Transmisin de Datos

UNIVERSIDAD TCNICA PARTICULAR DE LOJA

La Universidad Catlica de Loja

Bibliografa

Abramson, Norman. Teora de la Informacin y

Codificacin. Quinta edicin. Madrid, 1981.

Robert M. Gray. Entropy and Information Theory.

Springer-Verlang. Nueva York, 1990.

Katty Rohoden Jaramillo Transmisin de Datos

You might also like

- Fundamentos de Matemática DiscretaDocument130 pagesFundamentos de Matemática DiscretaBrayan FernandezNo ratings yet

- Ingenieria de Control Moderna Ogata 5ed Páginas 347 393Document47 pagesIngenieria de Control Moderna Ogata 5ed Páginas 347 393Carlos CarpioNo ratings yet

- Series de FourierDocument17 pagesSeries de FourierPaoFerNo ratings yet

- Ejercicios sobre teoría de la información y codificaciónDocument54 pagesEjercicios sobre teoría de la información y codificaciónCarlos CarpioNo ratings yet

- Preguntas de TelecomunicacionesDocument62 pagesPreguntas de TelecomunicacionesLuis Lopez100% (1)

- Ley Organica de Telecomunicaciones LOT 18-Feb-2015Document40 pagesLey Organica de Telecomunicaciones LOT 18-Feb-2015Estalin FuentesNo ratings yet

- Ascii Con IntegralDocument7 pagesAscii Con IntegralErix Manz LeNo ratings yet

- T Rec G.612 198811 I!!pdf SDocument6 pagesT Rec G.612 198811 I!!pdf SCarlos CarpioNo ratings yet

- LABORATORIO GUÍA 1 - 2020 RadiantesDocument5 pagesLABORATORIO GUÍA 1 - 2020 RadiantesCarlos CarpioNo ratings yet

- PDHDocument32 pagesPDHaiwariNo ratings yet

- Proec Psi2017 TecnologiaDocument12 pagesProec Psi2017 TecnologiaCarlos CarpioNo ratings yet

- Criptografía y Seguridad en ComputadoresDocument307 pagesCriptografía y Seguridad en ComputadoresDESCUDERO10% (1)

- Propagacion ElectromagneticaDocument0 pagesPropagacion ElectromagneticaAntonio NuñezNo ratings yet

- Modulación PSK de desplazamiento de faseDocument73 pagesModulación PSK de desplazamiento de faseCarlos CarpioNo ratings yet

- Ley Organica de Telecomunicaciones LOT 18-Feb-2015Document40 pagesLey Organica de Telecomunicaciones LOT 18-Feb-2015Estalin FuentesNo ratings yet

- Ingenieria de Control Moderna Ogata 5ed Páginas 392 405Document14 pagesIngenieria de Control Moderna Ogata 5ed Páginas 392 405Carlos CarpioNo ratings yet

- Dialnet AnalisisComparativoDeLasPropiedadesFisicomecanicas 4061089 PDFDocument7 pagesDialnet AnalisisComparativoDeLasPropiedadesFisicomecanicas 4061089 PDFCarlos CarpioNo ratings yet

- 1 9 joComAna-Tema1-Transparencias ProblemasDocument8 pages1 9 joComAna-Tema1-Transparencias ProblemasCarlos CarpioNo ratings yet

- Diseño de Antena BiquadDocument10 pagesDiseño de Antena BiquaddanielNo ratings yet

- Informe de Preparatorio 7 Radiantes G4 2020Document10 pagesInforme de Preparatorio 7 Radiantes G4 2020Carlos CarpioNo ratings yet

- PDFs TraficoDocument32 pagesPDFs TraficoCarlos CarpioNo ratings yet

- Teorema de NisquisDocument73 pagesTeorema de NisquisPaulo CamposNo ratings yet

- Trafico Erlang B C 2013Document14 pagesTrafico Erlang B C 2013gjaftelecomNo ratings yet

- Caracteristicas de La Red de Telecomunicaciones en Cobre PDFDocument76 pagesCaracteristicas de La Red de Telecomunicaciones en Cobre PDFCarlos Carpio0% (1)

- Problemas RuidoDocument17 pagesProblemas Ruidoelienai1No ratings yet

- Guia de Practica Back Up 6Document3 pagesGuia de Practica Back Up 6Carlos CarpioNo ratings yet

- Teorema de NisquisDocument73 pagesTeorema de NisquisPaulo CamposNo ratings yet

- T Espe 025270 PDFDocument148 pagesT Espe 025270 PDFenriquecastillo_106876No ratings yet

- pr06 Teo Info SLN PDFDocument8 pagespr06 Teo Info SLN PDFCarlos CarpioNo ratings yet

- Trafico Erlang B C 2013Document14 pagesTrafico Erlang B C 2013gjaftelecomNo ratings yet

- Trafico Erlang B C 2013Document14 pagesTrafico Erlang B C 2013gjaftelecomNo ratings yet

- 1Document2 pages1InahoAZNo ratings yet

- Reduccion CaracteristicasDocument51 pagesReduccion Caracteristicassanty90% (1)

- Cap 5 Fisico-Matematicas yDocument402 pagesCap 5 Fisico-Matematicas yalonsoNo ratings yet

- INF-TEORÍA CODIFICACIÓNDocument2 pagesINF-TEORÍA CODIFICACIÓNpsyduckzeroNo ratings yet

- Taller - de - Repaso EntropiaDocument7 pagesTaller - de - Repaso EntropiaEdin Son AlvaRa100% (1)

- Teoría de La Información - Wikipedia, La Enciclopedia LibreDocument40 pagesTeoría de La Información - Wikipedia, La Enciclopedia LibreteturkingtonNo ratings yet

- Corrección Al Solucionario Del Primer Examen ParcialDocument6 pagesCorrección Al Solucionario Del Primer Examen ParcialColque NinelNo ratings yet

- Qué Es Un Sistema ComplejoDocument56 pagesQué Es Un Sistema Complejomaggies_rv2695No ratings yet

- Que Es InformaciónDocument15 pagesQue Es InformaciónMelany Espejo ChavezNo ratings yet

- Practica Auxiliatura 164Document2 pagesPractica Auxiliatura 164leonelNo ratings yet

- Teoria - de - La - Informacion. Ezequiel FriasDocument16 pagesTeoria - de - La - Informacion. Ezequiel FriasJhoswer DelgadoNo ratings yet

- Entropía Y SinergiaDocument24 pagesEntropía Y SinergiaSallyk PacgNo ratings yet

- EntropíaDocument6 pagesEntropíaDaniel FerrariNo ratings yet

- Teoría de La Información - InternetDocument5 pagesTeoría de La Información - Internetraven recklessNo ratings yet

- EntropiaDocument11 pagesEntropiaJorge A. AvilésNo ratings yet

- dm4 PDFDocument36 pagesdm4 PDFPablo Esau Mejia MedinaNo ratings yet

- Clase 6 - Longitud Media de Un Codigo y Primer Teorema de ShannonDocument11 pagesClase 6 - Longitud Media de Un Codigo y Primer Teorema de ShannonRodrigo XNo ratings yet

- Introducción A Las Matemáticas - Semana - 2 - PDocument4 pagesIntroducción A Las Matemáticas - Semana - 2 - PG'eorge Alberto DorantesNo ratings yet

- Teoría de La InformaciónDocument8 pagesTeoría de La InformaciónKry RivadeneiraNo ratings yet

- Notas - Teoría de Codificación y Manejo de InformaciónDocument74 pagesNotas - Teoría de Codificación y Manejo de InformaciónCarlos Eduardo Zorrilla BucioNo ratings yet

- Métodos de Umbralización de ImágenesDocument21 pagesMétodos de Umbralización de ImágenesVictorHugoAguilarNo ratings yet

- Curso Criptografia Aplicada 2018Document134 pagesCurso Criptografia Aplicada 2018FernandoNo ratings yet

- Arboles Decision - TeoriaDocument16 pagesArboles Decision - TeoriaDiego Juan Alarcon SanchezNo ratings yet

- Ilovepdf MergedDocument52 pagesIlovepdf MergedJimmyJoelMillaMartinezNo ratings yet

- Prob Com Dig Parte 1Document3 pagesProb Com Dig Parte 1Ivan Verde HernándezNo ratings yet

- Teoria de La Informacion y La CodificacionDocument9 pagesTeoria de La Informacion y La Codificacionthato69No ratings yet

- Informe - Proyecto de T.InformaciónDocument23 pagesInforme - Proyecto de T.InformaciónIvan PintaNo ratings yet