Professional Documents

Culture Documents

Clase 6

Clase 6

Uploaded by

julio0 ratings0% found this document useful (0 votes)

3 views19 pagesOriginal Title

clase 6

Copyright

© © All Rights Reserved

Available Formats

PDF or read online from Scribd

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

© All Rights Reserved

Available Formats

Download as PDF or read online from Scribd

0 ratings0% found this document useful (0 votes)

3 views19 pagesClase 6

Clase 6

Uploaded by

julioCopyright:

© All Rights Reserved

Available Formats

Download as PDF or read online from Scribd

You are on page 1of 19

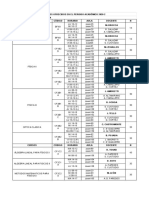

Estadistica Inferencial

J. UGARTE

Facultad de Ciencias - UNI (Clase 6)

October 2, 2019

Introducci6n

v

Intervalos de confianza para 07.

v

Propiedades de los estimadores puntuales y métodos de esti-

maci6n. Eficiencia relativa.

Consistencia y suficiencia.

Teorema de Rao-Blackwell.

Método de momentos.

vvvyv

Método de maxima verosimilitud.

Intervalos de confianza para o”

> Sabemos que la varianza poblacional o? mide la variabilidad

de la poblacidn, con lo cual es un pardmetro importante en

la poblacién.

> Para v.a.i.id normales Y1,..., Yn con media ju y varianza o?

sabemos que S$? = my LA(¥% — Y)* es un estimador

2

insesgado para a

» Para la construccién de intervalos de confianza para jz hemos

usado la aproximacién o = S, cuando o era desconocida.

> Cuando tenemos una muestra dada un pardmetro importante

es la variabilidad de la caracteristica que estamos midiendo.

Por ejemplo: En la estatura de una poblacién dada, ademas

de saber la talla media de la poblacién es necesario saber que

tanto varia de una observaci6n a otra, esto se cuantifica

con la varianza o?.

Intervalos de confianza para o*

Teniendo en cuenta que :

Dia(%i - VP _ (n= 1)?

2

a2 o

tiene una distribucién x? con (n — 1) grados de libertad.

Por el método del pivote tenemos que :

(n-1)S?

vee

P(Xj_a/2 S € X32) = 1-0,

Finalmente, reordenando tenemos:

(n — 1)S?

xa/0

(n—1)S?

<0 La diferencia de las varianzas V(61) — V(62).

> La razén de las varianzas V(02)/V(61)

> Debemos de tener en cuenta el significado de la varianza para

ambos pardmetros.

Eficiencia relativa

Definicién

Dado dos estimadores puntuales insesgados 6, y 6 de un mismo

parametro objetivo 0, con varianzas V(61) y V(62)

respectivamente. Entonces definimos la eficiencia de 0; con

respecto a 0 como :

on Vv

eff.) = 7 2

)

> Si eff(H1, 62) <1 entonces debemos de dar preferencia al

parametro 6.

> Si eff(61, 62) > 1 entonces debemos de dar preferencia al

parametro 6}.

> Si eff(61, 62) = 1 entonces no hay preferencia.

Eficiencia relativa

Ejemplo

Dado el parametro objetivo @ como Ia media poblacional, de una

poblacion normal. Consideramos dos estimadores 6, la mediana, y

by como la media muestral. Entonces tenemos que :

~ x, V(b) o2/n

fb, by) = 4 = __ 2 T*’ __,

eft, b2) VG) > CIBRFSTa 0.6366

De esta manera damos preferencia como estimador a 2 que es la

media muestral.

Aplicacién

Ejercicio

Sean Y;,..., Yn denotan una muestra aleatoria de una poblacién

con media 1 y con varianza 0”. Consideremos los siguientes

estimadores de la media 1:

1 Yo +-2-+Yp-1 1 G

~_1 a —

m= 3(+Y2); fig = quit 2n=2) a Hg = Y

» Demuestre que cada estimador es insesgado.

> Encuentre la eficiencia de ji3 con respecto a fiz y fir,

respectivamente

Aplicacion

Ejercicio

Sean Y1,..., Yn denotan una muestra aleatoria de distribucién

uniforme en el intervalo [0,0 + 1]. Sean:

n

> il s

L=V-5, y 62 = max(Y1,.. Yn) a

>» Demuestre que cada estimador es insesgado.

> Encuentre la eficiencia de 6, con respecto a 02

Consistencia

Denominemos Experiencia (n) : E, al lanzamiento de una

moneda n veces, cuya probabilidad de salir cara es p, considerando

los tiros independientes. Denotamos por Y, como el numero de

caras obtenidas en la experiencia E,. Sabemos que la proporcion

muestral %* es un estimador de p.

Las siguientes preguntas son fundamentales

>» Y/n se acerca al valor de p cuando n tiende al infinito ?

Para responder hacemos dos experiencias tomando p = 0.5

1. Realizamos una vez la experiencia E000.

2. Realizamos 50 veces la experiencia Eioo0.

Consistencia

En este caso obtenemos,

03

ot 11 1 4 4

on) 200 400 600 3001000 o 20 400 60080100

Consistencia

Vemos que en cada experiencia dada arriba tenemos que nuestro

estimador se acerca a nuestro pardmetro objetivo, con lo cual

tenemos que:

|(Y/n) — p| se hace cada vez mas pequefio aleatoriamente

Esto se puede expresar de forma probabilista, de esta manera

tenemos la definicién de consistencia que en teoria de

probabilidades es lo que se llama convergencia en probabilidad.

Definicién

Decimos que un estimador 6, es un estimador consistente de @ si,

para cualquier numero «,

lim P(\6, — |<) =1

n-900

o de forma equivalente,

lim P(\G, — 4] >) =0

300

Consistencia: Teoremas

Teorema

Un estimador insesgado 0, para 0 es un estimador consistente de 0

si:

lim V(6,) =0

slim, V (Gn)

Ejemplo

Sea Y1,..., Yn una muestra aleatoria de una distribucién con

media jt y varianza 0? < 00. Demuestre que Yn = ty Yj es

un estimador consistente de ju.

Consistencia: Teoremas

Teorema . a

Supongamos que 6, converge en probabilidad hacia 6 y que 6,

converge en probabilidad hacia 0’.

. 6n +m, converge hacia 0 + 0!

a

b. 6, x On’ converge hacia 6 x 0"

f

Si 6’ £0, entonces 6n/6n, converge hacia 0/6’.

- Si g(.) es una funcion de valor real que es continua en 6,

entonces g(6,) converge en probabilidad hacia g(8).

a

Consistencia: Teoremas

Ejemplo

Sea Y1,..., Y, una muestra aleatoria el cual posee hasta el cuarto

momento finito. Demostrar que :

i=l

Es un estimador consistente de a”

Realizar en clase

Consistencia: Teoremas

Teorema

Sea Un una sucesi6n de v.a.i.i.d cuya funcidn de distribucion

converge en hacia una funcion de distribucion estaéndar cuando

n—> oo. Si W, > 1 en probabilidad, entonces Ia funcién de

distribucion de a converge en una funcion de distribucion normal

estandar.

Ejemplo

Sea Y1,..., Y, una muestra aleatoria el cual posee hasta el cuarto

momento finito, con S? definido anteriormente. Demostrar que la

funcion de distribucion de :

Yn — Me

vale

)

converge hacia una funcidn de distribucion normal estandar.

Consistencia: Teoremas

Con el ejemplo anterior tenemos dos casos:

Yp, eS una muestra cualquiera con n grande

En este caso tenemos que :

se puede aproximar con una distribucion normal estdndar .

Consistencia : Teoremas

Y, eS normal para cualquier n

En este caso tenemos que :

Yn =e

vale

)

sigue una distribucion t de Student con n— 1 grados de libertad .

Observacién

De lo anterior podemos concluir que para n suficientemente grande

podemos tomar a vn(“e#) como una distribucion normal.

Suficiencia

En términos matematicos, dada una sucesién de v.a.i.i.d (X;,)y con

un pardmetro desconocido 9. Consideramos un estadistico U.

> Los datos proporcionados por U = g(X1,---,Xn) son mas que

suficientes para conocer 6?

> Dicho de otra manera no es necesario otra funcién de

(X%,..., Xp) nos dard mas informacién para 0.

Como ejemplo tenemos:

> (Xn)n una binomial cuya probabilidad de exito es p.

> Estadistico U = )77_, X; y pardmetro 0 = p.

> Si conocemos el valor U, entonces cualquier otra funcion de

X1,...Xq no proporcionara mas informacion esto lo vemos

con la probabilidad condicional:

1 i ye —

amiyanatoy Sean y

0, otro caso.

P(X = »,-

Suficiencia

> (Xn)n una binomial cuya probabilidad de exito es p.

> Estadistico U = >>?_, Xj y pardmetro 0 = p.

» Si conocemos el valor U, entonces cualquier otra funcion de

X1,...Xp no proporcionara mas informacion esto lo vemos

con la probabilidad condicional:

oO si Drax =y,

P(X = x1,---,Xn = Xl Y= y) =

0, otro caso.

Tenemos que esta probabilidad no depende del parametro

objetivo el cual es @ = p. Esto quiere decir que la informacion de

6 esta dentro del estadistico U = )7?_, Xj

Definicién

Sea Y,,..., Yn una muestra aleatoria de una distribucion de

probabilidad con parametro desconocido 0. Entonces se dice que el

estadistico U = g(Yi,..., Yn) es suficiente para 0 cuando la

distribucion condicional de Y1,..., Yn dado U no depende de 0

Suficiencia

Para indicar que la distribucion de la muestra Y1,..., Yn depende

de un pardmetro @ lo indicaremos como sigue:

> Si Y es discreta, su funcién de masa de probabilidad se

denotara p(y|@).

> Si Y es continua, su funcién de densidad se denotara por

F(y/8).

> Sila muestra Yi,..., Yn es discreta, entonces la funcién de

probabilidad conjunta se denotara por p(y, .- - Yn|0).

> Sila muestra Y1,..., Yn es continua, entonces la funcién de

densidad conjunta se denotara por f(y1,.-- Ynl@).

Observacién

En cualquier caso, tenemos que la distribucion cambia

dependiendo del valor del pardmetro 0.

Suficiencia

Definicién

Sean y1,...,Yn observaciones de una muestra Y1,..., Yn cuya

distribucion depende de un pardmetro 0. Llamamos verosimilitud

de la muestra a /a probabilidad conjunta de y1,..., Yn denotada

por L(y1,.--; ¥n|9)-

> Caso discreto L(y1,...,¥n|9) = p(yil9) x ply2|8) x --. P(Ynl9).

» Caso continuo

L(yis--,YnlO) = (yl) x F(y2|8) x... F(ynl4).

En ciertos casos para simplificar denotaremos L(y1, ... , ¥n|#) como

L(0).

Suficiencia

Teorema

Sea U un estadistico de la muestra Yi,..., Yn. Entonces U es un

estadistico suficiente para /a estimacion del parametro @ si y solo

si la verosimilitud L(y1,..., Yn|) se puede factorizar en dos

funciones :

L(ya,---+¥nl@) = g(u,) x h(n, --- 5 Yn)

Donde g(u, 0) es una funcion solamente de u y 0, y h(y1,---;¥n)

no es una funcion de 0.

Suficiencia

Ejemplo

Sea Y,,..., Yn) una muestra aleatoria con :

(1/d)e¥", O< yj; < 00,

F(yl0) = {

0, otro caso ,

donde 0 > 0, i =1,...,n. Demuestre que Y es un estadistico

suficiente para el pardmetro 0.

Suficiencia

Tenemos que existen otros estadisticos suficientes:

>» La misma muestra Yj,..., Yn

> Los estadisticos de orden Yay < Y(2) < Y(3y Sed Yn)

Ejemplo

Dada la muestra Y1,..., Y, con funcion de densidad, para

a>0,0>0:

a-1/97, O Encontrar U estadistico suficiente el cual mejor resume los

datos(Determinado en general por el criterio de factorizacion).

> Si encontramos alguna funcion de U pongamos h(U) tal que

E(h(U)|U) = 0

> Entonces h(U) es el MVUE de nuestro parametro 0

Teorema de Rao-Blackwell

Ejemplo

Dada la muestra Y1,..., Yn binomial con parametro p

desconocido.

> Enunciar el criterio de factorizacion. Solucién:

Lyi... ¥nlP) = P(Ya|p)P(Yalp) ---P(Yalp) =

p2Hyi(1— pyr Ly x1

> Determinar un estadistico suficiente. Solucién: U = 0 y;

> Determinar h(U) tal que E(h(U)|U) = p. Solucidn:

Tenemos que E(U) = np entonces E(U/n|U) = p por lo

tanto h(U) = U/n.

> Enunciar el teorema de Rao-Balckwell. Solucién:

0 insesgado y U suficiente entonces E(0|U) es insesgado con

varianza menor.

> Concluir Solucién:

Aplicamos el TRB a U/n y a U entonces tenemos que U/n es

un MVUE.

Teorema de Rao-Blackwell

Ejemplo

Dada la muestra Y;,..., Yn cuya funcion de densidad exponencial

esta dada por:

F(y|0) = {oem y>0,

0, en otro caso .

Encuentre un MVUE de V(Y;)..

Teorema de Rao-Blackwell

Ejercicio

Sea Y1,..., Yn una mestra de Bernoulli con :

pile) = pp)”, y= 0,1

Esto es, P(Y; = 1) = p y P(Y; = 0) =1—p. Encuentre el MVUE

de p(1— p) siguiendo los siguientes pasos:

a. Sea

r={t si ¥j=1y Yo =0,

0, otro caso

Mostrar que E(T) = p(1— p).

b. Mostrar que

w(n—w)

P(T = |W = w) = 0

c. Mostrar que :

Metodo de momentos

En esta seccion deseamos dar metodos para obtener metodos para

obtener estimadores puntuales.

Recordamos que el k — esimo momento de una variable aleatoria,

tambien llamado k — esimo momento poblacional, es:

s_ k

Hy = E(Y*).

El k — esimo momento muestral es el proemdio:

k

dia NY) .

,

mi, =

k n

Teorema

Metodo de los momentos Los estimadores puntuales se escogen de

la resolucion del sistema de ecuaciones :

Hi, =m, donde t es el numero de parametros por estimar.

Metodo de momentos

Ejemplo

Sea Yi, Y, una muestra cuya funcion de densidad es uniforme

dentro del intervalo [0,6] con @ desconocida. Estimar el parametro

0 por el metodo de los momentos.

a. Determinar el momento poblacional.

. Determinar el momento muestral.

. Resolver en la variable 0 la ecuacion: j= mi,

. Determinar un estimador puntual de 0.

eons

. Demostrar que dicho estimador es consistente.

Metodo de momentos

Ejercicio

Sea Y1,..., Yq, una muestra cuya funcion de densidad de

probabilidad esta dada por:

(@)O-y), OSy¥

You might also like

- Her Body and Other Parties: StoriesFrom EverandHer Body and Other Parties: StoriesRating: 4 out of 5 stars4/5 (821)

- The Sympathizer: A Novel (Pulitzer Prize for Fiction)From EverandThe Sympathizer: A Novel (Pulitzer Prize for Fiction)Rating: 4.5 out of 5 stars4.5/5 (122)

- Devil in the Grove: Thurgood Marshall, the Groveland Boys, and the Dawn of a New AmericaFrom EverandDevil in the Grove: Thurgood Marshall, the Groveland Boys, and the Dawn of a New AmericaRating: 4.5 out of 5 stars4.5/5 (266)

- Team of Rivals: The Political Genius of Abraham LincolnFrom EverandTeam of Rivals: The Political Genius of Abraham LincolnRating: 4.5 out of 5 stars4.5/5 (234)

- A Heartbreaking Work Of Staggering Genius: A Memoir Based on a True StoryFrom EverandA Heartbreaking Work Of Staggering Genius: A Memoir Based on a True StoryRating: 3.5 out of 5 stars3.5/5 (231)

- Hidden Figures: The American Dream and the Untold Story of the Black Women Mathematicians Who Helped Win the Space RaceFrom EverandHidden Figures: The American Dream and the Untold Story of the Black Women Mathematicians Who Helped Win the Space RaceRating: 4 out of 5 stars4/5 (897)

- The Unwinding: An Inner History of the New AmericaFrom EverandThe Unwinding: An Inner History of the New AmericaRating: 4 out of 5 stars4/5 (45)

- The Yellow House: A Memoir (2019 National Book Award Winner)From EverandThe Yellow House: A Memoir (2019 National Book Award Winner)Rating: 4 out of 5 stars4/5 (98)

- The Emperor of All Maladies: A Biography of CancerFrom EverandThe Emperor of All Maladies: A Biography of CancerRating: 4.5 out of 5 stars4.5/5 (271)

- The World Is Flat 3.0: A Brief History of the Twenty-first CenturyFrom EverandThe World Is Flat 3.0: A Brief History of the Twenty-first CenturyRating: 3.5 out of 5 stars3.5/5 (2259)

- Shoe Dog: A Memoir by the Creator of NikeFrom EverandShoe Dog: A Memoir by the Creator of NikeRating: 4.5 out of 5 stars4.5/5 (537)

- The Little Book of Hygge: Danish Secrets to Happy LivingFrom EverandThe Little Book of Hygge: Danish Secrets to Happy LivingRating: 3.5 out of 5 stars3.5/5 (401)

- Grit: The Power of Passion and PerseveranceFrom EverandGrit: The Power of Passion and PerseveranceRating: 4 out of 5 stars4/5 (590)

- Elon Musk: Tesla, SpaceX, and the Quest for a Fantastic FutureFrom EverandElon Musk: Tesla, SpaceX, and the Quest for a Fantastic FutureRating: 4.5 out of 5 stars4.5/5 (474)

- On Fire: The (Burning) Case for a Green New DealFrom EverandOn Fire: The (Burning) Case for a Green New DealRating: 4 out of 5 stars4/5 (74)

- The Subtle Art of Not Giving a F*ck: A Counterintuitive Approach to Living a Good LifeFrom EverandThe Subtle Art of Not Giving a F*ck: A Counterintuitive Approach to Living a Good LifeRating: 4 out of 5 stars4/5 (5807)

- The Hard Thing About Hard Things: Building a Business When There Are No Easy AnswersFrom EverandThe Hard Thing About Hard Things: Building a Business When There Are No Easy AnswersRating: 4.5 out of 5 stars4.5/5 (346)

- The Gifts of Imperfection: Let Go of Who You Think You're Supposed to Be and Embrace Who You AreFrom EverandThe Gifts of Imperfection: Let Go of Who You Think You're Supposed to Be and Embrace Who You AreRating: 4 out of 5 stars4/5 (1091)

- Never Split the Difference: Negotiating As If Your Life Depended On ItFrom EverandNever Split the Difference: Negotiating As If Your Life Depended On ItRating: 4.5 out of 5 stars4.5/5 (842)

- Guía de Matrícula FC 2020 - IIDocument14 pagesGuía de Matrícula FC 2020 - IIjulioNo ratings yet

- Tarea02 BD20202Document1 pageTarea02 BD20202julioNo ratings yet

- Proyecto ICPNA ALP BASIC 10Document6 pagesProyecto ICPNA ALP BASIC 10julioNo ratings yet

- Clase 02 AEDDocument22 pagesClase 02 AEDjulioNo ratings yet

- Cálculo AvanzadoDirig1 PDFDocument227 pagesCálculo AvanzadoDirig1 PDFjulioNo ratings yet

- Activity 02 - English - JuneDocument1 pageActivity 02 - English - JunejulioNo ratings yet

- COM23Document2 pagesCOM23julioNo ratings yet

- Estadistica InferencialDocument8 pagesEstadistica InferencialjulioNo ratings yet

- Tecnica de La Vertical Invertida 1er Y 2do Grado PrimariaDocument4 pagesTecnica de La Vertical Invertida 1er Y 2do Grado PrimariajulioNo ratings yet

- PD 01-02 Calculo AvanzadoDocument2 pagesPD 01-02 Calculo AvanzadojulioNo ratings yet

- Poda Alpha-BetaDocument11 pagesPoda Alpha-BetajulioNo ratings yet

- Universidad Nacional de Ingenier Ia Facultad de Ciencias Escuela Profesional de Matem Atica Ciclo 2017-IDocument2 pagesUniversidad Nacional de Ingenier Ia Facultad de Ciencias Escuela Profesional de Matem Atica Ciclo 2017-Inelson sanabioNo ratings yet