Professional Documents

Culture Documents

IA - Casanovas - Vista de INTELIGENCIA ARTIFICIAL Y DERECHO - A VUELAPLUMA

IA - Casanovas - Vista de INTELIGENCIA ARTIFICIAL Y DERECHO - A VUELAPLUMA

Uploaded by

Eugenio Adán Voltarel0 ratings0% found this document useful (0 votes)

10 views20 pagesOriginal Title

IA - Casanovas - Vista de INTELIGENCIA ARTIFICIAL Y DERECHO_ A VUELAPLUMA

Copyright

© © All Rights Reserved

Available Formats

PDF or read online from Scribd

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

© All Rights Reserved

Available Formats

Download as PDF or read online from Scribd

0 ratings0% found this document useful (0 votes)

10 views20 pagesIA - Casanovas - Vista de INTELIGENCIA ARTIFICIAL Y DERECHO - A VUELAPLUMA

IA - Casanovas - Vista de INTELIGENCIA ARTIFICIAL Y DERECHO - A VUELAPLUMA

Uploaded by

Eugenio Adán VoltarelCopyright:

© All Rights Reserved

Available Formats

Download as PDF or read online from Scribd

You are on page 1of 20

INTELIGENCIA

ARTIFICIAL Y

DERECHO: A

Pompeu Casanovas

Instituto de Derecho y Tecnologia

Universitat Autonoma de Barcelona

‘Sumario: |, Intligencia artificial: De palomas ydngles 2. Intligencia artificial y derecho: replica lo

insensato. 3 Web semntica y ontologis jurdicas el arte de pedi lo imposible

1, INTELIGENCIA ARTIFICIAL:

DE PALOMAS Y ANGELES

Cada ver que se me ocurre pensar lo inteli-

gentes que somos los humanos, recuerdo que

atin no poseemos una definicién aceptable de

inteligencia. ;Qué es una conducta “inteligen-

te"? zCon qué base podemos delimitar la linea

que separa una conducta inteligente de otra

que no lo sea?

Depende de la tarea que deba realizarse, Y

esto vale también para el uso de la abstraccién,

que hasta hace poco crefamos patrimonio ex-

clusivo de nuestra especie. Pero no es asi: en

la tarea de reconocimiento del espacio, por

ejemplo, circunscrito por figuras geométricas

en tres dimensiones, cualquier paloma es mu-

cho més ripida y precisa que un ser humano

(McFarland y Basser, 1993). Desde el aire, en

un vuelo ripido, éta es una condicién esen-

cial para la orientaciGn y el sorteo de posibles

obstéculos. Desde este punto de vista, el ce-

rebro de la paloma tiene un comportamiento

cognitive mucho més inteligente que el de los

humanos. La paloma y su capacidad de vuelo,

mds su capacidad de procesamiento de los in-

puts provenientes del exterior, conforman un

sistema.

Esta perspectiva empirica, atenta al contex-

toy alas condiciones en que se realiza el pro-

cesamiento de informacion, es la que dio lugar

al nacimiento de fa denominada inteligencia

attificial. Obsérvese que es en la perspectiva de

las ciencias formales y en las ingenierfas, tan-

to como en el de la filosoffa, donde se sitiia

su origen'. No hay ningtin “giro lingiistico”

en este campo, donde las nociones de sistema,

complejidad, inferencia y algoritmo tienen un

carcter matemético més amplio.

Esta es, en el fondo, la respuesta que Simon

y Einsenstadt dieron a la critica de John Sear-

le sobre el hecho de que los ordenadores sean

ciegos al significado de sus propias operacio-

nes*. La pregunta de si los ordenadores pueden

pensar presenta el mismo problema que el de

la definicién de inteligencia. Plantea un pro-

blema que sélo tiene sentido en el terreno de

Ia filosofia del lenguaje o de la ciencia, pero no

en el de la ciencia como lenguaje. Interesante,

pero fuera del objetivo cientifico o técnico de

las ciencias del disefto o de la computacién.

‘Comparte el nivel del estatuto epistemolégico

del test de Turing’.

Visto desde el sistema resultante de compo-

nentes externos ¢ internos —y no como un ce-

rebro— es claro que la habitacién china ima-

EI

8

rs

2

g

§

g

ginada por Searle puede “pensar”, en el sentido

de tansformar la informaci6n a partir de

tadios sucesivos. Pero plantearse la pregunta

como un problema de la propia LA, implica

cometer una variante de la denominada falacia

de la morfologia de primer orden: la comple-

jidad del sistema es el reflejo del contexto, no

reside en las propiedades de sus mecanismos

internos de computacién’. El producto de la

computacién no es isomorfo con los mecanis

mos que lo han generado’.

No se trata, pues, de mimetizar o replicar

las operaciones mentales tal y como el cere-

bro humano de hecho las realiza. Se trata mas

bien de identificar y dejarse sorprender por las

operaciones que éste posibilita —informacién,

memoria, comprensién, entendimiento, len-

guaje, expresién y razonamiento— e intentar

comprender su estructura y funcionamiento

en tanto que operaciones abstractas. Y, si es

posible, mejorarlas en maquina para volverlas

a insertar luego en contextos reales. Aunque

parezca una paradoja, la inteligencia artificial

ha tenido desde sus inicios un fuerte compo-

hente empitico y una marcada orientacién

prictica

El modelo, pues, es lo importante aqui, no

elobjeto analdgico del que parte. “Para aleanzar

el nivel de la inteligencia humana, se requ

la propiedad de la autoconciencia” —declara-

ba recientemente John McCarthy (2006) re-

flexionando sobre el camino recortido desde

o de verano de Dartmouth (1956)

donde nacié el término inteligencia artificial’.

Este no es su objetivo. Al menos para Simon

y Newell, la LA se basé desde el principio en

cadenas simbélicas recursivas expresables alge-

braicamente’.

el seminai

‘Modelos bisicos basados en a “inteligencia

sin representacidn” (Brooks, 1991) 0 en la “in-

teligencia de enjambre” [swarm intel

(Bonabeau et al. 1999, Dorigo 2004) o “inteli-

gencia cambriana” (Brooks, 1999) de los insee-

tos, sin médulo central de representaci6n, son

también posibles y han sido desarrollados en

robética. Incluso han sido propuestos nuevos

modelos de computacién més allé de las mé-

quinas de ‘Turing (Wegner y Eberbach, 2004;

Goldin y Wegner, 2008). Pero Ia idea basica

de representar el conocimiento mediante la

aplicacién de lenguajes artificiales permanece

incdlume’,

En afios sucesivos, fueron aparecien-

do nuevas nociones —como las de esquema

[schemal, red semdntica [semantic network],

discurso [discourse], contexto [context], 0

marco [frame]— para capturar la dinémica y

1a complejidad del procesamiento de informa-

Gidn en situaciones reales. Uno de losarticulos

mis citados es “A Framework for Representing

Knowledge” (MIT 1974), donde Marvin Min-

sky anticipa en gran medida el trabajo poste-

rior en légica no-monot6nica, los argumentos

caneelables (o “derrotables”) y las redes socia-

les’. El trabajo seminal de H. S. Simon sobre

la byisqueda de un nivel de actuacién aceprable

de la red como un conjunto, en lugar de la op-

timalidad de un nodo particular, ha sido im-

portante también aqui. Se denomina el crite-

rio de satisficcién [satisficing] ”. La satisficeion

constituye la base para la resolucién colectiva

distribuida de problemas.

Esta perspectiva muestra el impacto de las

ciencias cognitivas emergentes en los modelos

originalmente propuestos por la IA. De hecho,

lahistoria de la LA,y la de las ciencias cognitivas

se desarrolla en paralelo y en estrecho contacto

entre si. La convergencia, incluso en fechas, es

sorprendente"’. La relacién interdisciplinar era

muy estrecha al principio, tal y como muestra

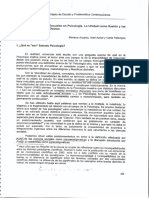

la figura que Georges Miller dibujé en 1978:

Fiosofia

Pricalogia Linatista

Cen Arfrepologia

Computacional

Neurociencia

TREROS Cape Same

Figura 1. G. A. Miller (2008: 143).

Mapa de ls ciencias cognitivas. Cada linea representa investigaciones interdisciplinarias existentes en 1978,

Uno de los desarrollos més prometedores,

efectuados por la sepunda generacién de in-

vestigadores, deudores del trabajo de Simon

y Newell, es el de los denominados “sistemas

expertos’. Es decit, programas que abundan

en el contenido del conocimiento, antes que

en su forma, y en una pluralidad de tareas. A

partir de un conocimiento base, un sistema ex-

perto es capaz de responder de forma répida y

fectiva a los problemas planteados desde un

dominio determinado.

Esto no es ficil, porque implica dotar, ade-

mis de su potencia de cileulo y de deduccién,

de inferencia inductiva a los ordenadores. Ed-

ward Feigenbaum, en su memoria personal,

califica los afios que vieron el desarrollo de

DENDRAL y MYCIN —

You might also like

- Pedagogía General - U3 - TP - Pilares de La EducacionDocument7 pagesPedagogía General - U3 - TP - Pilares de La EducacionEugenio Adán VoltarelNo ratings yet

- Jurisprudencia - Schooner ExchangeDocument10 pagesJurisprudencia - Schooner ExchangeEugenio Adán VoltarelNo ratings yet

- Pedagogía General - U3 - Guía Módulo 3Document8 pagesPedagogía General - U3 - Guía Módulo 3Eugenio Adán VoltarelNo ratings yet

- PEDAGOGÍA GENERAL - U3 - Presentaciones de La Clase - PPT UNIDAD 3 IIDocument11 pagesPEDAGOGÍA GENERAL - U3 - Presentaciones de La Clase - PPT UNIDAD 3 IIEugenio Adán VoltarelNo ratings yet

- Ley Colombia - Código de Comercio - Decreto-410-de-1971-Gestor-NormativoDocument220 pagesLey Colombia - Código de Comercio - Decreto-410-de-1971-Gestor-NormativoEugenio Adán VoltarelNo ratings yet

- Pedagogía General - U3 - TP - Entrevistas A ProfesoresDocument3 pagesPedagogía General - U3 - TP - Entrevistas A ProfesoresEugenio Adán VoltarelNo ratings yet

- Manual de Derecho de La Navegacion Gonzalez-LebreroDocument853 pagesManual de Derecho de La Navegacion Gonzalez-LebreroEugenio Adán Voltarel100% (1)

- Heading For Automated Maritime Navigation Law - SpanishDocument15 pagesHeading For Automated Maritime Navigation Law - SpanishEugenio Adán VoltarelNo ratings yet

- TFM - InteligenciaArtificialEnAmbitoMartimo - Universidad de Cantabria-82-88Document7 pagesTFM - InteligenciaArtificialEnAmbitoMartimo - Universidad de Cantabria-82-88Eugenio Adán VoltarelNo ratings yet

- Ley Chile - LEY-18680 - 11-ENE-1988Document81 pagesLey Chile - LEY-18680 - 11-ENE-1988Eugenio Adán VoltarelNo ratings yet

- Ley Chile - 001 - Ultima - Revision - Mayo - 2020 - Actualizado - Al - 08 - de - Noviembre - de - 2022Document43 pagesLey Chile - 001 - Ultima - Revision - Mayo - 2020 - Actualizado - Al - 08 - de - Noviembre - de - 2022Eugenio Adán Voltarel100% (1)

- Manual de Derecho Marítimo (Nuevo) - Romero BasaldúaDocument336 pagesManual de Derecho Marítimo (Nuevo) - Romero BasaldúaEugenio Adán VoltarelNo ratings yet

- Arcanio, Aybar, Falavigna - Multiplicidad de Escuelas en PsicologíaDocument8 pagesArcanio, Aybar, Falavigna - Multiplicidad de Escuelas en PsicologíaEugenio Adán VoltarelNo ratings yet