0% found this document useful (0 votes)

1K views3 pagesPrompt Engineering Cheat Sheet

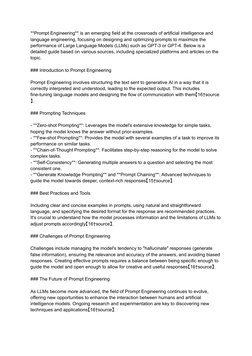

Prompt engineering is a field focused on designing prompts to maximize the performance of large language models. It involves structuring prompts so the AI understands and provides the expected output. Techniques include zero-shot prompting using the model's knowledge, few-shot prompting with examples, and chain-of-thought prompting for complex tasks. Best practices are clear examples, natural language, and specifying response formats. Challenges are avoiding hallucinations, ensuring relevance and accuracy, and mitigating bias. As models advance, new techniques and applications continue emerging in this evolving field.

Uploaded by

Juan Pablo Dell'OroCopyright

© © All Rights Reserved

We take content rights seriously. If you suspect this is your content, claim it here.

Available Formats

Download as PDF, TXT or read online on Scribd

0% found this document useful (0 votes)

1K views3 pagesPrompt Engineering Cheat Sheet

Prompt engineering is a field focused on designing prompts to maximize the performance of large language models. It involves structuring prompts so the AI understands and provides the expected output. Techniques include zero-shot prompting using the model's knowledge, few-shot prompting with examples, and chain-of-thought prompting for complex tasks. Best practices are clear examples, natural language, and specifying response formats. Challenges are avoiding hallucinations, ensuring relevance and accuracy, and mitigating bias. As models advance, new techniques and applications continue emerging in this evolving field.

Uploaded by

Juan Pablo Dell'OroCopyright

© © All Rights Reserved

We take content rights seriously. If you suspect this is your content, claim it here.

Available Formats

Download as PDF, TXT or read online on Scribd

- Introduction to Prompt Engineering: Introduces the field of Prompt Engineering, outlining its significance in enhancing AI models like GPT-3 through effective prompt designs.

- Prompting Techniques: Discusses various techniques for designing prompts, such as zero-shot and few-shot prompting, tailored to improve AI model responses.

- Resources: Provides information on where to find further resources, guides, and online courses for deeper learning in Prompt Engineering.

- Desafíos del Prompt Engineering: Highlights the challenges in Prompt Engineering, such as managing hallucination and enhancing response accuracy, presented in Spanish.

- El Futuro del Prompt Engineering: Explores the future directions of Prompt Engineering, focusing on the advancement of language models and the importance of ongoing research, presented in Spanish.