Professional Documents

Culture Documents

Scikit Learn CheatSheet BFCS0011

Scikit Learn CheatSheet BFCS0011

Uploaded by

alialiye33333Original Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Scikit Learn CheatSheet BFCS0011

Scikit Learn CheatSheet BFCS0011

Uploaded by

alialiye33333Copyright:

Available Formats

blog.faradars.

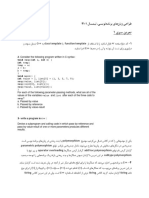

org مجله فرادرس – تقلبنامه پایتون برای علم دادهBFCS0011

Scikit-Learn کتابخانه

Scikit-Learn معرفی کتابخانه

) برای زبان پایتون است که طیفی ازOpen Source( » یک کتابخانه «متنباز،)Scikit-learn( »«سایکیتلِرن

«اعتبارسنجی،)Data Pre-Processing( » «پیشپردازش دادهها،)Machine Learning( »الگوریتمهای «یادگیری ماشین

.) را با استفاده از یک رابط یکپارچه پیادهسازی یمکندVisualization( ») و «بصریسازیCross Validation( »متقابل

یک مثال پایهای

>>> from sklearn import neighbors, datasets, preprocessing

>>> from sklearn.model_selection import train_test_split

>>> from sklearn.metrics import accuracy_score

>>> iris = datasets.load_iris()

>>> X, y = iris.data[:, :2], iris.target

>>> X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=33)

>>> scaler = preprocessing.StandardScaler().fit(X_train)

>>> X_train = scaler.transform(X_train)

>>> X_test = scaler.transform(X_test)

>>> knn = neighbors.KNeighborsClassifier(n_neighbors=5)

>>> knn.fit(X_train, y_train)

>>> y_pred = knn.predict(X_test)

>>> accuracy_score(y_test, y_pred)

)Loading The Data( بارگذاری دادهها

دیگر انواعی. ذخیره شده باشندSciPy یا ماتریس خلوتNumPy دادهها باید به صورت عددی و آرایههای

. نیز قابل پذیرش هستندPandas مانند دیتافریم،که قابل تبدیل به آرایههای عددی هستند

>>> import numpy as np

>>> X = np.random.random((10,5))

>>> y = np.array(['M','M','F','F','M','F','M','M','F','F','F'])

>>> X[X < 0.7] = 0

)Training And Test Data( دادههای آموزش و آزمون

>>> from sklearn.model_selection import train_test_split

>>> X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=0)

. به این لینک مراجعه فرمایید،برای مشاهده دیگر «تقلبنامههای» مجله فرادرس

blog.faradars.org مجله فرادرس – تقلبنامه پایتون برای علم دادهBFCS0011

)Preprocessing The Data( پیشپردازش دادهها

)Encoding Categorical Features( رمزنگاری ویژیگهای طبقهای )Standardization( استانداردسازی

>>> from sklearn.preprocessing import LabelEncoder >>> from sklearn.preprocessing import StandardScaler

>>> enc = LabelEncoder() >>> scaler = StandardScaler().fit(X_train)

>>> y = enc.fit_transform(y) >>> standardized_X = scaler.transform(X_train)

>>> standardized_X_test = scaler.transform(X_test)

)Missing Values( جایگذاری مقادیر ناموجود )Normalization( نرمالسازی

>>> from sklearn.preprocessing import Imputer >>> from sklearn.preprocessing import Normalizer

>>> imp = Imputer(missing_values=0, strategy='mean', axis=0) >>> scaler = Normalizer().fit(X_train)

>>> imp.fit_transform(X_train) >>> normalized_X = scaler.transform(X_train)

>>> normalized_X_test = scaler.transform(X_test)

)Polynomial Features( ساخت ویژیگهای چند جملهای )Binarization( دودوییسازی

>>>from sklearn.preprocessing import PolynomialFeatures >>> from sklearn.preprocessing import Binarizer

>>> poly = PolynomialFeatures(5) >>> binarizer = Binarizer(threshold=0.0).fit(X)

>>> poly.fit_transform(X) >>> binary_X = binarizer.transform(X)

ساخت مدل

)Supervised Learning Estimators( برآوردگرهای یادگیری نظارت شده

)Linear Regression( رگرسیون خطی

>>> from sklearn.linear_model import LinearRegression

>>> lr = LinearRegression(normalize=True)

)Support Vector Machines | SVM( ماشین بردار پشتیبان

>>> from sklearn.svm import SVC

>>> svc = SVC(kernel='linear')

)Naive Bayes( نایو بیز

>>> from sklearn.naive_bayes import GaussianNB

>>> gnb = GaussianNB()

)K-Nearest Neighbors | KNN( نزدیکترین همساییگK

>>> from sklearn import neighbors

>>> knn = neighbors.KNeighborsClassifier(n_neighbors=5)

)Unsupervised Learning Estimators( برآوردگرهای یادگیری نظارت نشده

)K Means( میانگینK )Principal Component Analysis ( تحلیل مولفه اسایس

>>> from sklearn.cluster import KMeans >>> from sklearn.decomposition import PCA

>>> k_means = KMeans(n_clusters=3, random_state=0) >>> pca = PCA(n_components=0.95)

. به این لینک مراجعه فرمایید،برای مشاهده دیگر «تقلبنامههای» مجله فرادرس

blog.faradars.org مجله فرادرس – تقلبنامه پایتون برای علم دادهBFCS0011

)Model Fitting( برازش مدل

)Supervised Learning( یادگیری نظارت شده

>>> برازش مدل برای دادههاlr.fit(X, y)

>>> knn.fit(X_train, y_train)

)Unsupervised Learning( یادگیری نظارت نشده

>>> برازش مدل برای دادههاk_means.fit(X_train)

>>> برازش برای دادهها و سپس تبدیل آنpca_model = pca.fit_transform(X_train)

)Prediction( پیشبیین

برآوردگرهای نظارت شده

>>> پیشبیین برچسبهاy_pred = svc.predict(np.random.random((2,5)))

>>> پیشبیین برچسبهاy_pred = lr.predict(X_test)

>>> تخمین احتمال یک برچسبy_pred = knn.predict_proba(X_test)

برآوردگرهای نظارت نشده

>>> پیشبیین برچسبها در الگوریتمهای خوشهبندیy_pred = k_means.predict(X_test)

)Model Performance Evaluation( ارزیایب کارایی مدل

)Classification Metrics( سنجههای دستهبندی

)Accuracy Score( امتیاز صحت

>>> روش امتیاز برآوردگرknn.score(X_test, y_test)

>>> توابع امتیازدهی متریکfrom sklearn.metrics import accuracy_score

>>> accuracy_score(y_test, y_pred)

)Classification Report( گزارش دستهبندی

وf1-Score ،)Recall( » «دقت،)Precision( » >>> «صحتfrom sklearn.metrics import classification_report

)Support( » >>> «پشتیبانprint(classification_report(y_test, y_pred))

)Confusion Matrix( ماتریس درهمریختیگ

>>> from sklearn.metrics import confusion_matrix

>>> print(confusion_matrix(y_test, y_pred))

)Regression Metrics( سنجههای رگرسیون

)R² Score( R2 امتیاز

>>> from sklearn.metrics import r2_score

>>> r2_score(y_true, y_pred)

. به این لینک مراجعه فرمایید،برای مشاهده دیگر «تقلبنامههای» مجله فرادرس

blog.faradars.org مجله فرادرس – تقلبنامه پایتون برای علم دادهBFCS0011

)Mean Absolute Error( میانگین قدر مطلق خطا

>>> from sklearn.metrics import mean_absolute_error

>>> y_true = [3, -0.5, 2]

>>> mean_absolute_error(y_true, y_pred)

)Mean Squared Error( میانگین خطای مربعات

>>> from sklearn.metrics import mean_squared_error

>>> mean_squared_error(y_test, y_pred)

)Clustering Metrics( سنجههای خوشهبندی

)Adjusted Rand Index( Rand اندیس تصادفی شده

>>> from sklearn.metrics import adjusted_rand_score

>>> adjusted_rand_score(y_true, y_pred)

)Homogeneity( همگن بودن

>>> from sklearn.metrics import homogeneity_score

>>> homogeneity_score(y_true, y_pred)

)V-measure( V اندازه

>>> from sklearn.metrics import v_measure_score

>>> metrics.v_measure_score(y_true, y_pred)

)Cross-Validation( اعتبارسنجی متقابل

>>> from sklearn.cross_validation import cross_val_score

>>> print(cross_val_score(knn, X_train, y_train, cv=4))

>>> print(cross_val_score(lr, X, y, cv=2))

)Model Tuning( تنظیم مدل

)Grid Search( جستوجوی شبکهای

>>> from sklearn.grid_search import GridSearchCV

>>> params = {"n_neighbors": np.arange(1,3),

"metric": ["euclidean", "cityblock"]}

>>> grid = GridSearchCV(estimator=knn,

param_grid=params)

>>> grid.fit(X_train, y_train)

>>> print(grid.best_score_)

>>> print(grid.best_estimator_.n_neighbors)

. به این لینک مراجعه فرمایید،برای مشاهده دیگر «تقلبنامههای» مجله فرادرس

blog.faradars.org مجله فرادرس – BFCS0011تقلبنامه پایتون برای علم داده

بهینهسازی پارامتر تصادفی شده ()Randomized Parameter Optimization

>>> from sklearn.grid_search import RandomizedSearchCV

>>> params = {"n_neighbors": range(1,5),

}]""weights": ["uniform", "distance

>>> rsearch = RandomizedSearchCV(estimator=knn,

param_distributions=params,

cv=4,

n_iter=8,

)random_state=5

)>>> rsearch.fit(X_train, y_train

)_>>> print(rsearch.best_score

مجموعه آموزشهای دادهکاوی فرادرس (+کلیک کنید)

برای مشاهده دیگر «تقلبنامههای» مجله فرادرس ،به این لینک مراجعه فرمایید.

جهت آگاهی از آخرین تقلبنامههای منتشر شده ،در کانال تلگرام مجله فرادرس عضو شوید.

تهیه و تنظیم :مجله فرادرس

منبع

برای مشاهده دیگر «تقلبنامههای» مجله فرادرس ،به این لینک مراجعه فرمایید.

You might also like

- تمرین آخر شبکه عصبیDocument9 pagesتمرین آخر شبکه عصبیArmin AqelpoorNo ratings yet

- Week2a Chap4 MarixDocument42 pagesWeek2a Chap4 MarixAliNo ratings yet

- 3 انتخابDocument12 pages3 انتخابghazaleh hamzehNo ratings yet

- Deep Learning in MATLAB BFCS0029Document4 pagesDeep Learning in MATLAB BFCS0029Noor MohamadNo ratings yet

- CA3 Report 40103904Document3 pagesCA3 Report 40103904mohammad13744731No ratings yet

- HW2 401129051Document9 pagesHW2 401129051Erfan ZohrehvandNo ratings yet

- 5 توابعDocument11 pages5 توابعghazaleh hamzehNo ratings yet

- HW1 401129051Document22 pagesHW1 401129051Erfan ZohrehvandNo ratings yet

- Ca2 40103904Document4 pagesCa2 40103904mohammad13744731No ratings yet

- 2regression2018 1Document90 pages2regression2018 1hii i am adninNo ratings yet

- MATLAB Optimization ToolboxDocument4 pagesMATLAB Optimization ToolboxFarsima RanjbarNo ratings yet

- آزمون میان - ترمDocument2 pagesآزمون میان - ترمbaran.cozyNo ratings yet

- Digital Magazi CH6 96Document17 pagesDigital Magazi CH6 96arez brotNo ratings yet

- وسایل توزین دو کفه ای مکانیکیDocument1 pageوسایل توزین دو کفه ای مکانیکیsahelNo ratings yet

- پهگردDocument5 pagesپهگرد2014.abbasalamdarNo ratings yet

- Gozaresh 1Document6 pagesGozaresh 1Aliasghar AbbasiNo ratings yet

- تابع در پایتونDocument22 pagesتابع در پایتونRare DorsaNo ratings yet

- Financial Modelling - 1Document13 pagesFinancial Modelling - 1Hemo BoghosianNo ratings yet

- اندازه گیریDocument73 pagesاندازه گیریrozhinhatami4No ratings yet

- 2moshtagh TamrinatDocument2 pages2moshtagh TamrinatMohammad Sina SaffarNo ratings yet

- Assessment Sample QuestionsDocument22 pagesAssessment Sample QuestionsMasoud DastgerdiNo ratings yet

- AP Mirkhan Ch01Document22 pagesAP Mirkhan Ch01rwin.shamsaeeNo ratings yet

- کنترل مدرن PDFDocument122 pagesکنترل مدرن PDFMohammad hosein mahdaviNo ratings yet

- Excel FunctionDocument31 pagesExcel FunctionsetakNo ratings yet

- سلسة 2 مع الحل (الحل البياني للبرمجة الخطية)Document6 pagesسلسة 2 مع الحل (الحل البياني للبرمجة الخطية)AMir AlLelNo ratings yet

- CA4 Report 40103904Document3 pagesCA4 Report 40103904mohammad13744731No ratings yet

- HW#5Document3 pagesHW#5Mahbod SinakiNo ratings yet

- @SHARIF - IE امتحان برنامه نویسDocument9 pages@SHARIF - IE امتحان برنامه نویسyiher73253No ratings yet

- @konurbanks10TپاسخDocument14 pages@konurbanks10Tپاسخpenina penhaniNo ratings yet

- الگوریتم های مرتب سازیDocument14 pagesالگوریتم های مرتب سازیPejman RezaeiNo ratings yet

- برنامه سازی بخش توابعDocument20 pagesبرنامه سازی بخش توابعalireza.kgmNo ratings yet

- فصل پنجمDocument56 pagesفصل پنجمapi-3766154100% (4)

- ACT-SUPDCS (Supcon DCS)Document4 pagesACT-SUPDCS (Supcon DCS)Sadegh AkbariNo ratings yet

- Pamphlet (Session06)Document12 pagesPamphlet (Session06)paya ghaffarianNo ratings yet

- تمرین سری اول PDFDocument2 pagesتمرین سری اول PDFamir hsnnjdNo ratings yet

- Flask 1643457812Document69 pagesFlask 1643457812Navid NaeimiNo ratings yet

- ControlbodenyqDocument1 pageControlbodenyqMohamad DashteNo ratings yet

- ACT-SUPDCS (Supcon DCS)Document4 pagesACT-SUPDCS (Supcon DCS)Sadegh AkbariNo ratings yet

- ES Ch04 PrintDocument16 pagesES Ch04 Printnaval.sh03No ratings yet

- Lecture 14 - Conditional DistributionsDocument15 pagesLecture 14 - Conditional DistributionsE Hkdi7No ratings yet

- CFD IntroDocument20 pagesCFD Introsajjadf954No ratings yet

- Jozve HCIDocument6 pagesJozve HCIwww.hosseinimaede14No ratings yet

- HCI Farsi - MergedDocument52 pagesHCI Farsi - Mergedwww.hosseinimaede14No ratings yet

- Drug Trial - IV BolusDocument73 pagesDrug Trial - IV BoluspundalikNo ratings yet

- PDF Created With Pdffactory Pro Trial VersionDocument10 pagesPDF Created With Pdffactory Pro Trial Versionati scafieldNo ratings yet

- WeishauptDocument64 pagesWeishauptmostafa mahmoodiNo ratings yet

- بررسی توانمندی اولیه در شرکت رنوDocument26 pagesبررسی توانمندی اولیه در شرکت رنوEhsan ArbabtaftiNo ratings yet

- Print: "Helloworld!"Document6 pagesPrint: "Helloworld!"reza amjadiNo ratings yet

- Python Libraries CheatSheet BFCS0004Document2 pagesPython Libraries CheatSheet BFCS0004alialiye33333No ratings yet

- Hw1-ریاضی مهندسیDocument1 pageHw1-ریاضی مهندسیniloofarNo ratings yet

- Exercise 1Document2 pagesExercise 1jam35jam.mehNo ratings yet

- Matlab FarsiDocument35 pagesMatlab FarsiRuhollah norouzi dehnashiNo ratings yet

- گزارش کارDocument3 pagesگزارش کارMOH derNo ratings yet

- Slide 4 BehavioralDocument115 pagesSlide 4 BehavioralsadramgkNo ratings yet

- تمرین سری پنجمDocument3 pagesتمرین سری پنجمmorteza karimiNo ratings yet

- File 29Document3 pagesFile 29fhasanzade1995No ratings yet

- Final Exam (Malek - 942) & AnsDocument7 pagesFinal Exam (Malek - 942) & Anserfan roshandelNo ratings yet

- A5 Num 021Document13 pagesA5 Num 021hasan hasaniNo ratings yet

- Az 33Document27 pagesAz 33Sanaz GerameifarNo ratings yet