Professional Documents

Culture Documents

TD1MDBS

Uploaded by

Roland Oscar Mondesir KonanOriginal Description:

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

TD1MDBS

Uploaded by

Roland Oscar Mondesir KonanCopyright:

Available Formats

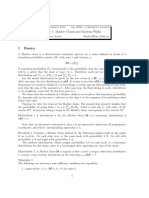

ESATIC Année Académique

Master 1 2020/2021

TRAVAUX DIRIGES

FICHE 1

CHAINES DE MARKOV ET FILES D’ATTENTE

Exercice 1 (Transforming a Process into a Markov chain) Suppose that wether or not it rains

today depends on previous weather conditions through the last two days. That is, suppose that

if it has rained for the past two days, then it will rain tomorrow with probability .7; if it rained

today but not yesterday, it will rain tomorrow with probability .5; if it rained yesterday but not

today, then it will rain tomorrow with probability .4; if it has not rained the past two days, then

it will rain tomorrow with probability .2.

1) Why if we let the state at time n depend only on wether or not it is raining at time n,

then the above model is not a Markov chain?

2) Now we set

state 0: it rained both today and yesterday;

state 1: it rained today but not yesterday;

state 2: it rained yesterday but not today;

state 3: it did not rain either yesterday or today.

Prove that by using these states the model becomes a Markov chain with space of states

S = {0, 1, 2, 3} and transition matrix

.7 0 .3 0

.5 0 .5 0

P =

0 .4 0 .6

0 .2 0 .8

3 Draw the graph of transitions and make the classification of states.

4) Given that it rained on Monday and Tuesday, what is the probability that it will rain on

Thursday?

5) We denote by α = (α0 , α1 , α2 , α3 ) the initial distribution of the Process that is

αj = P(X0 = j)

Suppose that α0 = .4, α1 = .6. Find the probability that it will rain four days after we

begin keeping weather records. Remember that if µ(n) denote the distribution probability

(n)

of the random variable Xn then we have µ(n) = αP n where µj = P(Xn = j) So you must

calculate P(X4 = 0) (Explain why)

Exercice 2 Ruine du joueur

Un joueur partant d’un capital initial de k euros fait une série de paris à 1 euro. On suppose que

1

ESATIC 2020/2021

les paris sont indépendants, la probabilité de gagner est p ∈]0, 1[. Si au cours des paris, le capital

du joueur atteint 0, il est ruiné et ne peut plus jouer : son capital reste nul après. On désigne par

Xn le capital du joueur à l’instant n.

1) Montrer que la suite (Xn )n≥0 est une chaîne de Markov d’espace d’états E = N , préciser

sa matrice de transition.

2) Supposons maintenant que si son capital atteint un seuil d ∈ N∗ , le joueur s’arrête de jouer.

Écrire la nouvelle matrice de transition. Etudier cette chaîne de Markov.

Exercice 3 (Gambler’s ruin) A gambler plays a game in which on each play he wins one dollar

with probability 1/2 and loses one dollar with probability 1/2. He plays until he gets a fortune of

4 dollars or is ruined.

1) Modelize this random phenomena by a Markov chain

2) Give the probability of ruin of the gambler if he starts with a fortune of 2 dollars and also

the probability that he reachs his goal of 4 dollars.

3) Calculate the average duration of this game.

4) Without any calculation, compare the probability of ruin of the gambler starting from

initial fortune 1 dollar and the probability of reaching his goal starting from initial fortune

3 dollars.

Exercice 4

Soit une chaine de Markov (Xn , n ∈ N) à valeurs dans E = {1, 2, 3, 4}, de matrice de transition

1 0 0 0

p p

2 1−p−q q 2

Q= 0

, (p, q > 0, p + q < 1)

0 1 0

q 0 p 1−p−q

et d’état initial 2

(1) Construire le graphe de la chaine. En déduire les différentes classes et leur nature.

(2) Soit T instant de rentré dans C = {1, 3}.

(a) Ecrire T en fonction de la suite (Xn )n≥0 . En déduire les valeur prise par T .

(b) Déterminer l’espétance de T . Pour quelle valeur de p et q elle est maximale.

(3) Montrer que XT est une variable aléatoire et que Xt = XT si t ≥ T .

Exercice 5 La richesse d’un joueur de casino est décrite par une marche aléatoire {Sn : n ≥ 0}.

Sn désigne la fortune du joueur à la date n. On suppose que S0 = 1 et qu’il y a des barières

absorbantes en 0 et 3. (Les états sont numérotés de 0 à 3). A chaque coup, la probabilité de

gagner un franc est notée p et la probabilité de perdre un franc est q = 1 − p. Le jeu se termine

donc lorsque Sn = 0 ou Sn = 3 pour un certain n.

(1) Donner la matrice de transition de la chaîne de Markov {Sn : n ≥ 0}. Faire la classification

des états.

(2) Trouver les probabilités que le joueur fasse faillite ou sorte gagnant du jeu.

2

ESATIC 2018/2019

(3) Trouver le temps moyen que le joueur mettra pour faire faillite.

BON COURAGE

You might also like

- SolutionsDocument8 pagesSolutionsSanjeev BaghoriyaNo ratings yet

- Sol A6 MarkovChainDocument24 pagesSol A6 MarkovChainHaydenChadwickNo ratings yet

- Tutorial 1Document3 pagesTutorial 1ayan.av0010No ratings yet

- Chapter 2Document24 pagesChapter 2ching chauNo ratings yet

- Homework 4 SolutionsDocument16 pagesHomework 4 SolutionsAE ENo ratings yet

- Markov Decission Process. Unit 3Document37 pagesMarkov Decission Process. Unit 3AlexanderNo ratings yet

- hw3 Stat521spring2019Document1 pagehw3 Stat521spring2019Prof. Madya Dr. Umar Yusuf MadakiNo ratings yet

- Rabbits vs Sheep Phase Plane AnalysisDocument4 pagesRabbits vs Sheep Phase Plane AnalysisJohn MateusNo ratings yet

- HW 3 SolutionDocument10 pagesHW 3 SolutionEddie Martinez Jr.100% (1)

- Cadenas de MarkovDocument53 pagesCadenas de MarkovolsolerNo ratings yet

- Solutions To NotesDocument8 pagesSolutions To Noteskevinp888No ratings yet

- Stochastic HWDocument3 pagesStochastic HWHaniyaAngelNo ratings yet

- Assignment 1Document2 pagesAssignment 1sankaNo ratings yet

- 1 Discrete-Time Markov ChainsDocument7 pages1 Discrete-Time Markov ChainsbobmezzNo ratings yet

- IE 325 Fall 2020 HW4 Solutions PDFDocument10 pagesIE 325 Fall 2020 HW4 Solutions PDFOsman ŞentürkNo ratings yet

- QF204 Additional Examples Week 10: Random Walk: 1 QuestionsDocument3 pagesQF204 Additional Examples Week 10: Random Walk: 1 QuestionsKhoaNamNguyenNo ratings yet

- Classproblem3 PDFDocument2 pagesClassproblem3 PDFankiosaNo ratings yet

- Summer 2016Document4 pagesSummer 2016mihaela.vlad27No ratings yet

- Markov Chains: 1.1 Specifying and Simulating A Markov ChainDocument38 pagesMarkov Chains: 1.1 Specifying and Simulating A Markov ChainRudi JuliantoNo ratings yet

- Markov ChainsDocument13 pagesMarkov Chainsmittalnipun2009No ratings yet

- Isye 6761 - Fall 2012Document11 pagesIsye 6761 - Fall 2012Kirby NgNo ratings yet

- Markov Chain - Math - 380 - F - s1 - 41corrDocument11 pagesMarkov Chain - Math - 380 - F - s1 - 41corrDiego SalazarNo ratings yet

- HW 2 SolutionDocument10 pagesHW 2 SolutionSarahBNo ratings yet

- A Comparison of Solving The Poisson Equation Using Several Numerical Methods in Matlab and Octave On The Cluster MayaDocument18 pagesA Comparison of Solving The Poisson Equation Using Several Numerical Methods in Matlab and Octave On The Cluster MayaGiovanny FelipNo ratings yet

- Question Paper Code: X10663: ×2 20 Marks)Document3 pagesQuestion Paper Code: X10663: ×2 20 Marks)GOPINATH 189No ratings yet

- Writing Your PHD Thesis in L Tex2E: A Using The Cued TemplateDocument18 pagesWriting Your PHD Thesis in L Tex2E: A Using The Cued TemplateAlessandro CataldiNo ratings yet

- Assignment 2Document2 pagesAssignment 2RAHUL DHANOLANo ratings yet

- Chapter 4 - Discrete Time Markov ChainsDocument37 pagesChapter 4 - Discrete Time Markov ChainsMinh QuânNo ratings yet

- Tutsheet 7 NewDocument4 pagesTutsheet 7 NewVishal PatelNo ratings yet

- Tutorial Chapter 1 and 2 Memo-1Document13 pagesTutorial Chapter 1 and 2 Memo-1u20417242No ratings yet

- Math Work 12345Document14 pagesMath Work 12345afiabaloch6792No ratings yet

- Math 108 LE2 Samplex SolutionsDocument5 pagesMath 108 LE2 Samplex SolutionsSamuel SalacupNo ratings yet

- Trigonometric Fourier Series: ECE 350 - Linear Systems I MATLAB Tutorial #6Document7 pagesTrigonometric Fourier Series: ECE 350 - Linear Systems I MATLAB Tutorial #6CatNo ratings yet

- Putnam problems and solutions A1 solutionsDocument19 pagesPutnam problems and solutions A1 solutionsHaidar KasemNo ratings yet

- TestDocument6 pagesTest1269657434No ratings yet

- Problems SolutionDocument6 pagesProblems SolutionUp ToyouNo ratings yet

- Markov Chains ErgodicityDocument8 pagesMarkov Chains ErgodicitypiotrpieniazekNo ratings yet

- UI 2014 Freshman Math Contest SolutionsDocument3 pagesUI 2014 Freshman Math Contest SolutionsGag PafNo ratings yet

- Apsp1 PDFDocument22 pagesApsp1 PDFJingwei ChenNo ratings yet

- Classproblem1 PDFDocument3 pagesClassproblem1 PDFankiosaNo ratings yet

- lec6meanTimeInTransientStatesDocument17 pageslec6meanTimeInTransientStatesreach.harithagbNo ratings yet

- 13.5 Curl and DivergenceDocument11 pages13.5 Curl and DivergenceDaniel Gaytan-JenkinsNo ratings yet

- STAT 6100 - MATH 6180 Lecture 18 - Mean Time Spent in Transient StatesDocument7 pagesSTAT 6100 - MATH 6180 Lecture 18 - Mean Time Spent in Transient StatesRamana NimaiNo ratings yet

- IOE516 - Stochastic Processes II Homework Set 2 - Suggested SolutionsDocument6 pagesIOE516 - Stochastic Processes II Homework Set 2 - Suggested SolutionsAloke ChatterjeeNo ratings yet

- Notes No. 3 Solvinmg For Mean Variance Standard DeviationDocument7 pagesNotes No. 3 Solvinmg For Mean Variance Standard Deviationnikkigabanto.24No ratings yet

- Markov Chains: 4.1 Stochastic ProcessesDocument42 pagesMarkov Chains: 4.1 Stochastic ProcessesDimas AdipNo ratings yet

- Assignment 3 - (Theory) Markov Chains: T T 0 T T T 0Document4 pagesAssignment 3 - (Theory) Markov Chains: T T 0 T T T 0Assan AchibatNo ratings yet

- Volatility Swap Under The SABR Model: Simon Bossoney March 26, 2013Document10 pagesVolatility Swap Under The SABR Model: Simon Bossoney March 26, 2013Melissa AyquipaNo ratings yet

- XPL 2.0 Module Exam 18 SolutionsDocument11 pagesXPL 2.0 Module Exam 18 Solutionsjustinakmanoj22No ratings yet

- hmwk4 Sol PDFDocument7 pageshmwk4 Sol PDFSandra CelisNo ratings yet

- MTHS2007 Formula SheetwithtablescorrectedDocument3 pagesMTHS2007 Formula SheetwithtablescorrectedBenjamin OpokuNo ratings yet

- MarkovDocument46 pagesMarkovAdnan KhanNo ratings yet

- M.tech Question Paper 2021-2022Document9 pagesM.tech Question Paper 2021-2022Prabhakar DubeyNo ratings yet

- Wave scattering by small bodies of arbitrary shapesDocument11 pagesWave scattering by small bodies of arbitrary shapesMohammad Imran ShafiNo ratings yet

- تحليل حقيقىDocument103 pagesتحليل حقيقىsayedhamdi335No ratings yet

- Parametric EquationsDocument12 pagesParametric EquationsvitinhocalcarasgadaNo ratings yet

- Statistics and Econometrics II Problem Set 1: Exercise 1 Law of Iterated ExpectationsDocument7 pagesStatistics and Econometrics II Problem Set 1: Exercise 1 Law of Iterated ExpectationsDaniel MatosNo ratings yet

- Solutions Assign 3 2022 AutumnDocument4 pagesSolutions Assign 3 2022 AutumnEvan JoshyNo ratings yet

- TD1MDBSDocument3 pagesTD1MDBSRoland Oscar Mondesir Konan100% (1)

- Markov Chains and Processes OverviewDocument23 pagesMarkov Chains and Processes OverviewWesam WesamNo ratings yet

- HMM BioinformaticsDocument30 pagesHMM BioinformaticsClub MusicNo ratings yet

- IS 7118 Unit-6 HMMDocument78 pagesIS 7118 Unit-6 HMMJmpol JohnNo ratings yet

- Discrete-Time Markov Chains: He ShuangchiDocument61 pagesDiscrete-Time Markov Chains: He ShuangchiZhengYang ChinNo ratings yet

- Markov Models: Current Next Transition Probabilities CurrentDocument53 pagesMarkov Models: Current Next Transition Probabilities Currentpranati putrevu100% (1)

- Cs229 HMM - PsDocument13 pagesCs229 HMM - PsClarken TranNo ratings yet

- End of Studies InternshipDocument52 pagesEnd of Studies InternshipHichem SaghrouniNo ratings yet

- Using HTKDocument36 pagesUsing HTKngocthelongNo ratings yet

- Tutorial 05Document16 pagesTutorial 05eragornNo ratings yet

- Markov Chain - HW4Document3 pagesMarkov Chain - HW4Diego SalazarNo ratings yet

- Inv OP2Document12 pagesInv OP2NicoNo ratings yet

- Hidden Markov ModelsDocument20 pagesHidden Markov ModelsRachnaNo ratings yet

- Universidad Nacional Abierta Y A Distancia Teoria de Las DecisionesDocument19 pagesUniversidad Nacional Abierta Y A Distancia Teoria de Las DecisionesAlfredo Jose Pertuz VegaNo ratings yet

- Noori Farhan Al-Mayahi: University of Al-QadisiyahDocument47 pagesNoori Farhan Al-Mayahi: University of Al-QadisiyahMohamed Fawzy ShrifNo ratings yet

- Machine Learning 2: Exercise Sheet 6Document1 pageMachine Learning 2: Exercise Sheet 6Surya IyerNo ratings yet

- Tugas 1 - PPSDocument3 pagesTugas 1 - PPSDani RamadhanNo ratings yet

- Simulasi Model Antrian Optimal Loket Pembayaran ParkirDocument14 pagesSimulasi Model Antrian Optimal Loket Pembayaran ParkirAdit MangolNo ratings yet

- Queuing Theory P4Document10 pagesQueuing Theory P4Akash DubeyNo ratings yet

- 2.9. Items Arrive at A Machine Shop in A Deterministic Fashion at A Rate of One Per Minute. EachDocument4 pages2.9. Items Arrive at A Machine Shop in A Deterministic Fashion at A Rate of One Per Minute. EachAlbert GeraldiNo ratings yet

- Hidden Markov Models (HMMS) : Prabhleen Juneja Thapar Institute of Engineering & TechnologyDocument36 pagesHidden Markov Models (HMMS) : Prabhleen Juneja Thapar Institute of Engineering & TechnologyRohan SharmaNo ratings yet

- A Tutorial On Hidden Markov Models PDFDocument22 pagesA Tutorial On Hidden Markov Models PDFNicky MuscatNo ratings yet

- HMM-40Document41 pagesHMM-40sachin vermaNo ratings yet

- Hierarchical Hidden Markov ModelDocument3 pagesHierarchical Hidden Markov Modelemma698No ratings yet

- Kunci Jawaban PMS Asis 9 (Markov)Document13 pagesKunci Jawaban PMS Asis 9 (Markov)Anida LalaNo ratings yet

- Hidden Markov Model in Automatic Speech RecognitionDocument29 pagesHidden Markov Model in Automatic Speech Recognitionvipkute0901No ratings yet

- Model Hidden Markov Pada Prediksi Harga Beras Dan Perpindahan Konsumen Beras Di Kota Solok Provinsi Sumatera Barat Melsi Diansa PutriDocument10 pagesModel Hidden Markov Pada Prediksi Harga Beras Dan Perpindahan Konsumen Beras Di Kota Solok Provinsi Sumatera Barat Melsi Diansa PutriBudi PurnomoNo ratings yet

- Lecture 14Document18 pagesLecture 14guoyanpNo ratings yet

- Analytical Simulation of Water System Capacity ReliabilityDocument14 pagesAnalytical Simulation of Water System Capacity ReliabilityJoel AlvesNo ratings yet

- done-ANALISIS DAN OPTIMASI SISTEM ANTRIAN DI GERAI MINUMAN TEKO BOBADocument16 pagesdone-ANALISIS DAN OPTIMASI SISTEM ANTRIAN DI GERAI MINUMAN TEKO BOBAHeni Damayanti EniNo ratings yet