Professional Documents

Culture Documents

3

Uploaded by

Diggmeister /AnimeEdits0 ratings0% found this document useful (0 votes)

5 views2 pagesCopyright

© © All Rights Reserved

Available Formats

DOCX, PDF, TXT or read online from Scribd

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

© All Rights Reserved

Available Formats

Download as DOCX, PDF, TXT or read online from Scribd

0 ratings0% found this document useful (0 votes)

5 views2 pages3

Uploaded by

Diggmeister /AnimeEditsCopyright:

© All Rights Reserved

Available Formats

Download as DOCX, PDF, TXT or read online from Scribd

You are on page 1of 2

1.

Поняття субградієнту

Нехай f : R n → R – функція на евклідовому просторі Rn. Вектор g ∈ Rn

називається субградієнтом функції f (x) в точці x ¿ ∈ R n, якщо справджується

нерівність:

f ( x )−f ( x ) ≥ g ( x −x ) ∀ x ∈ R

¿ T ¿ n

Множина всіх субградієнтів називається субдиференціалом функції f (x) в

точці x ¿ і позначається ∂ f ( x ¿ ).

Приклад.

Для функції f : R → R : x ⟼|x| маємо:

{

{−1 } , x ¿ <0

∂ f ( x )= [−1 , 1 ] , x ¿ =0

¿

{1 } , x ¿ >0

Поняття субдиференціалу та субградієнту є узагальненнями відповідних

понять диференціалу та градієнту класичного аналізу.

2. Простий субградієнтний метод опуклої оптимізації

Для реалізації субградієнтної оптимізації в випадку задачі без обмежень

процес може починатися з будь-якої точки x 0. Зсув чергової точки x i до

наступної точки x i+1 здійснюється на відстань hi в напрямку будь-якого

узагальненого градієнта функції f (x) в точці x i в випадку задачі максимізації

вгнутої функції і в зворотному напрямку – у випадку задачі мінімізації опуклої

функції. Якщо кроки hi зсувів обираються таким чином, що h → 0 при i→ ∞ , а

ряд h 0+ h1+ h2 +h3 +… розбігається, то послідовність x 0 + x 1+ …+ x m ++… збігається до

множини екстремуму заданої функції f (x) за умови, що множина обмежена.

Для обчислення субградієнтів застосовуються різні способи. Одним з них

є зведення задачі обчислення субградієнта функції, що задана складним

виразом, до обчислення субградієнтів окремих компонентів цього виразу. Для

подібного зведення особливо часто застосовуються такі властивості опуклих

функцій.

Властивість 1. Якщо функції f 1 ( x ) , … , f m (x ) опуклі, то опуклою буде і

m

будь-яка їх лінійна комбінація f ( x )=∑ ai f i (x ) з невід’ємними

i=1

коефіцієнтами a i ≥ 0(i=1 , m) , а субградієнт S(x ) функції f ( x ) дорівнює лінійній

m

комбінації ∑ ai S i (x) субградієнтів Si (x ) функцій f ( x ) .

i=1

Властивість 2. Якщо функції f 1 ( x ) , … , f m (x ) опуклі, то опуклою буде і

функція f ( x )=max f i ( x ), і всі субградієнтні множини Si (x 0 ) функцій f i ( x ), для яких

f ( x 0 ) =f ( x ) , входять в субградієнтну множину S( x ) функції f ( x ) в будь-якій

0

заданій точці x=x 0.

До відомих виборів кроків hi відносять:

∞

a. Класичні умови: h k > 0 ; lim hk =0 ; ∑ ¿+∞

k→ ∞ k=0

γ ( f ( x k )−f )

¿

b. Фейєрів крок:h k = , 0< γ <2

‖g f ( x )‖

k

c. Геометрична прогресія:h k+1=h k∗q k ,0 <q k < 1, k =0 , 1 ,2 , …

3. Методи розтягу простору

Простий субградієнтний метод, розглянутий вище, може виявитися

повільно збіжним, якщо області рівня цільової функції сильно витягнуті в

одному напрямку, або, як часто при цьому говориться, мають вигляд вузьких і

довгих ярів. Ця ситуація характерна для багатьох задач негладкої оптимізації.

Для поліпшення збіжності методу в подібних випадках використовують методи

розтягу простору.

Розтяг простору зводиться до заміни змінних x 1 , … , x k в цільовій функції

f ( x )=f (x 1 , … , x k ) деякими їх лінійними комбінаціями. Особливо просто

виконується розтяг в напрямку однієї з координатних осей. Змінна x i, що

відповідає цій осі, замінюється при цьому на k −1 x i, де k - коефіцієнт розтягу, а

решта залишається без змін.

You might also like

- ФУНКЦІЇ ТА ЇХ ОСНОВНІ ВЛАСТИВОСТІDocument1 pageФУНКЦІЇ ТА ЇХ ОСНОВНІ ВЛАСТИВОСТІ2ngxf4fpkvNo ratings yet

- СР ФБЗDocument36 pagesСР ФБЗГлеб КрипакNo ratings yet

- Лекція 15. Дослідження Функцій За Допомогою ПохіднихDocument9 pagesЛекція 15. Дослідження Функцій За Допомогою ПохіднихirisNo ratings yet

- Лекція 15. Дослідження Функцій За Допомогою ПохіднихDocument9 pagesЛекція 15. Дослідження Функцій За Допомогою ПохіднихirisNo ratings yet

- 1474 Prezentacya Na Temu Funkcyi Yih GrafkiDocument22 pages1474 Prezentacya Na Temu Funkcyi Yih GrafkiТарас МалярNo ratings yet

- Розділ 7. Наближення ФункційDocument42 pagesРозділ 7. Наближення ФункційІгор ПоліщукNo ratings yet

- функція та їх властивостіDocument12 pagesфункція та їх властивостіARSENKANo ratings yet

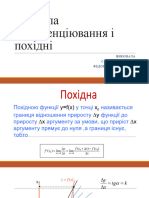

- Правила Диференціювання і ПохідніDocument31 pagesПравила Диференціювання і ПохідніValia FedorchukNo ratings yet

- PR 4Document10 pagesPR 4SoshO PetrenkoNo ratings yet

- Lecture 2Document4 pagesLecture 2Bob AndersonNo ratings yet

- Lecture 3Document4 pagesLecture 3Bob AndersonNo ratings yet

- Похідною функції y=f (x), за аргументом x називають границюDocument8 pagesПохідною функції y=f (x), за аргументом x називають границюЯна КраснолуцькаNo ratings yet

- Лекція 14. Основні Теореми Диференціального ЧисленняDocument11 pagesЛекція 14. Основні Теореми Диференціального ЧисленняirisNo ratings yet

- Ma-4-II. ФункціїDocument22 pagesMa-4-II. Функціїanton antonNo ratings yet

- Lab 3Document6 pagesLab 3Max SlobodianNo ratings yet

- 01 - 2023 - 02 - 06 - Визначений інтегралDocument13 pages01 - 2023 - 02 - 06 - Визначений інтегралДима ЛехановNo ratings yet

- Лекція11Document11 pagesЛекція11zxcdedinsaid07No ratings yet

- Лекция 6 исследование функцийDocument11 pagesЛекция 6 исследование функцийVeronica ParkerNo ratings yet

- Функції Та Їх Основні ВластивостіDocument15 pagesФункції Та Їх Основні ВластивостіmilenamankoneNo ratings yet

- Опорний Конспект Невизнвчений ІнтегралDocument3 pagesОпорний Конспект Невизнвчений ІнтегралНаталия ПронозаNo ratings yet

- UntitledDocument22 pagesUntitledivan56565No ratings yet

- 3 Vyznachenyy - IntegralDocument6 pages3 Vyznachenyy - IntegralMaxym HladunNo ratings yet

- УСЕ ПРО ФУНКЦІЇ НА НМТDocument12 pagesУСЕ ПРО ФУНКЦІЇ НА НМТkmaistrenko1802No ratings yet

- UntitledDocument44 pagesUntitledHOT CrossNo ratings yet

- МатМодЗадСВч2,3Document49 pagesМатМодЗадСВч2,3Yurii FedorukNo ratings yet

- ІІсем.ЛЕКЦІЯ 2.ВИЗНАЧ.ІНТDocument15 pagesІІсем.ЛЕКЦІЯ 2.ВИЗНАЧ.ІНТfodeke2428No ratings yet

- Ma2 FF FiDocument13 pagesMa2 FF FiDashaNo ratings yet

- Лекція 12Document18 pagesЛекція 12Аліна ВласикNo ratings yet

- 1 Nevyznach - IntegrDocument12 pages1 Nevyznach - IntegrMaxym HladunNo ratings yet

- ЛЕКЦІЯ 2Document8 pagesЛЕКЦІЯ 2fodeke2428No ratings yet

- 03 10 22 Математичні методи в обробці медичних данихDocument83 pages03 10 22 Математичні методи в обробці медичних данихvladagarmNo ratings yet

- pr04 PDFDocument15 pagespr04 PDFEdgard Wəllsn100% (1)

- 034Document43 pages034misvladyslavNo ratings yet

- Лекція. 13 Неперервність ФункціїDocument7 pagesЛекція. 13 Неперервність ФункціїОля КузанNo ratings yet

- Лекція 12Document13 pagesЛекція 12knf4fmb5myNo ratings yet

- Lecture 9Document5 pagesLecture 9Bob AndersonNo ratings yet

- ІНТЕГРАЛИ, ЩО ЗАЛЕЖАТЬ ВІД ПАРАМЕТРАDocument88 pagesІНТЕГРАЛИ, ЩО ЗАЛЕЖАТЬ ВІД ПАРАМЕТРАmariya.bystrykNo ratings yet

- 15.09 Функція Та Її ВластивостіDocument38 pages15.09 Функція Та Її ВластивостіВасилий ДекапольцевNo ratings yet

- 11 Klas Algebra Nelin 2011Document448 pages11 Klas Algebra Nelin 2011Alex IsNo ratings yet

- Застосування похіднихDocument18 pagesЗастосування похіднихValia FedorchukNo ratings yet

- PR 02Document9 pagesPR 02АнастасияNo ratings yet

- 06 Визначений інтегралDocument23 pages06 Визначений інтегралІгор ТкаченкоNo ratings yet

- Група 17 13.03, 16.03, 17.03 PDFDocument8 pagesГрупа 17 13.03, 16.03, 17.03 PDFanastasiia1467No ratings yet

- Algebra 11 Klas Nelin 2011Document448 pagesAlgebra 11 Klas Nelin 2011vladbartkozanNo ratings yet

- Ð Ð ÐºÑ Ñ Ñ 16Document6 pagesÐ Ð ÐºÑ Ñ Ñ 16настя 47No ratings yet

- 4 Formula - Nyutona - LeybnicaDocument6 pages4 Formula - Nyutona - LeybnicaMaxym HladunNo ratings yet

- вишматDocument14 pagesвишматИрина ПалинкоNo ratings yet

- 1 - Класичні задачі ВЧDocument5 pages1 - Класичні задачі ВЧ111111No ratings yet

- Опорний Конспект Невизнвчений ІнтегралDocument3 pagesОпорний Конспект Невизнвчений ІнтегралНаталия ПронозаNo ratings yet

- 374181Document7 pages374181Евгения СидоренкоNo ratings yet

- 374181Document7 pages374181Евгения СидоренкоNo ratings yet

- Лекція 19. Визначений ІнтегралDocument4 pagesЛекція 19. Визначений ІнтегралСерёга ВойкккккNo ratings yet

- 372517Document8 pages372517Евгения СидоренкоNo ratings yet

- Вступ до матан!Document7 pagesВступ до матан!Баба ЗинаNo ratings yet

- Лаба 2 сем 2 СмоковичDocument7 pagesЛаба 2 сем 2 СмоковичpodkopvaNo ratings yet

- Група 17 13.03, 16.03, 17.03 PDFDocument8 pagesГрупа 17 13.03, 16.03, 17.03 PDFLiza BaranovaNo ratings yet

- ФДЗпDocument10 pagesФДЗпLiza ApilatNo ratings yet

- Тема 2 НЕЛІНІЙНЕDocument12 pagesТема 2 НЕЛІНІЙНЕIryna IgorivnaNo ratings yet

- Lecture 10-12Document11 pagesLecture 10-12Bob AndersonNo ratings yet